Подключение Windows 7 к iSCSI SAN

В данной статье не рассматривается процесс установки iSCSI SAN, мы предполагаем что он у вас уже запущен и работает.

Настройка iSCSI в Windows 7

Для начала запустим iSCSI Initiator, который в Windows 7 установлен по умолчанию. Вы можете запустите его несколькими способами.

Первым вариантов является запуск через панель управления Windows 7:

Интересное

Качественное сведение и мастеринг в студии звукозаписи Timeline Music

В качестве альтернативы для продвинутых пользователей можно запустить программу, набрав её имя в строке поиска. Для этого наберем iscsicpl.exe и нажмем Enter

Не зависимо от способо запуска, результат один. Появится предупреждение о том, что служба iSCSI не запущена. Нажимаем Yes для запуска службы

В итоге мы попали в окно iSCSI Initiator Properties где мы будем настраивать подключение.

В этот момент мы готовы подключить iSCSI инициатор к iSCSI-таргет. В нашем случае роль iSCSI Target играет виртуальная машина с дистрибутивом OpenFiler, запущенная под управлением vSphere.

Введем имя нашего таргета — wb-iscsi-san.

В следующем скриншоте нам будет предложено к какому из обнаруженных объектов мы хотим присоединиться. Выберем WB-iSCSI-WINDOWS .

Нажмите Connect, после чего раздел iSCSI SAN будет добавлен в Windows и после этого нажмите DONE.

Теперь в статусе таргета указано – Connected.

В завершение перейдите в вкладку

После чего нажмите OK для закрытия свойств iSCSI инициатора.

Нам осталось сделать подключенный раздел доступным в Windows, для этого перейдем в Computer Management и нажмем на Disk Management.

Вы должны увидеть новый неинициализированный диск. Инициализируем его.

Нажмите OK для инициализации.

Как вы можете видеть, теперь диск находиться в состоянии Online, но пока ещё на нем не создан ни один раздел.

Нажмите на диске правой кнопкой и выберите New Simple Volume.

Я предполагаю что вы способны самостоятельно создать новый раздел в Windows 7, поэтому пропущу подробности.

В результате будет создан новый раздел, его статус Healthy (Primary Partition), он отформатирован в NTFS.

Напоследок зайдем в Мой компьютер и посмотрим на свежесозданный диск там.

Как вы видите, ничего сложного нет!

Автор: David Davis

Источник: Статьи для системного администратора

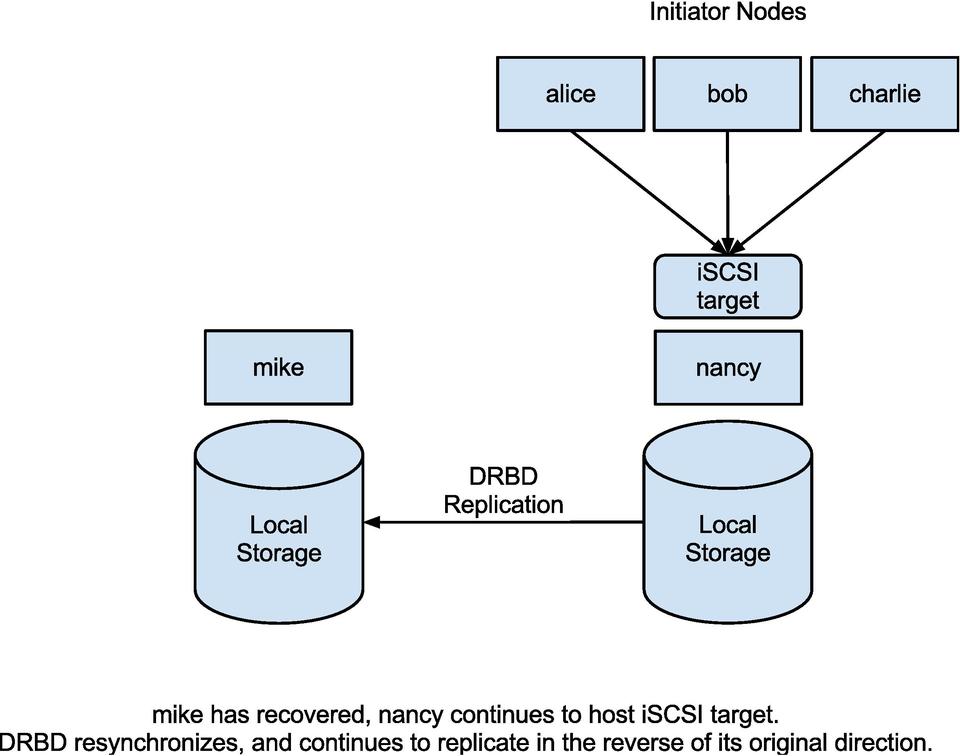

Превращаем старый сервер в iSCSI Target с помощью Enterprise Storage OS (ESOS)

Продолжая тему полезного использования старого серверного оборудования, на этот раз поговорим об использовании сервера модели В прошлый раз мы уже рассматривали такой сервер в роли хранилища резервных копий виртуальных машин с программной дедупликацией от Quadstor. Однако в нашем случае ситуация усугубилась тем, что на некоторых удалённых площадках, где была развёрнута описанная конфигурация, виртуальные машины, подвергавшиеся резервному копированию, со временем получили дополнительный диск под хранение контента для точки распространения SCCM. А, как известно, содержимое дисков, которые используются под распространение контента в SCCM может временами очень активно меняться (загружаются новые обновления SUP, удаляются просроченные обновления, загружается какое-либо ПО для развёртывания и т.п.). Поэтому, учитывая то обстоятельство, что используемое ПО

В прошлый раз мы уже рассматривали такой сервер в роли хранилища резервных копий виртуальных машин с программной дедупликацией от Quadstor. Однако в нашем случае ситуация усугубилась тем, что на некоторых удалённых площадках, где была развёрнута описанная конфигурация, виртуальные машины, подвергавшиеся резервному копированию, со временем получили дополнительный диск под хранение контента для точки распространения SCCM. А, как известно, содержимое дисков, которые используются под распространение контента в SCCM может временами очень активно меняться (загружаются новые обновления SUP, удаляются просроченные обновления, загружается какое-либо ПО для развёртывания и т.п.). Поэтому, учитывая то обстоятельство, что используемое ПО

«Вишенкой на торте» в описанной ситуации стало то, что в сервере, который используется в нашем случае в качестве iSCSI Target (из реализации Quadstor), очень скромная дисковая корзина – всего 4 слота SAS/SATA форм-фактора 3.5″, два из которых заняты под хостовую ОС Linux.

Здесь мы рассмотрим один из возможных вариантов решения совокупности описанных проблем и ограничений, который заключается в замене полноценной инсталляции ОС Linux на загружаемый с USB-накопителя и работающий в оперативной памяти специализированный Linux-дистрибутив проекта Enterprise Storage OS (ESOS). По своей сути ESOS это оптимизированное под работу в ОЗУ современное Linux-ядро с интегрированным ПО проекта SCST, пример использования которого, мы уже рассматривали ранее.

Общий план мероприятий будет выглядеть так:

- Убираем из дисковой корзины диски малой ёмкости, на которых установлена хостовая ОС, и ставим на это место диски большей ёмкости (все диски в корзине станут одинаковой ёмкости)

- На уровне аппаратного RAID-контроллера определяем каждый из четырёх дисков, подключённых к дисковой корзине, как самостоятельное устройство.

- Подготавливаем загрузочный USB-накопитель с ESOS

- Загружаем сервер с ESOS и создаём программный RAID-массив из всех дисков корзины.

- Конфигурируем в ESOS iSCSI Target и подключаем диск на стороне сервера iSCSI Initiator

- Настраиваем дополнительное сетевое подключение между серверами и включаем Multipath

Конфигурация серверов

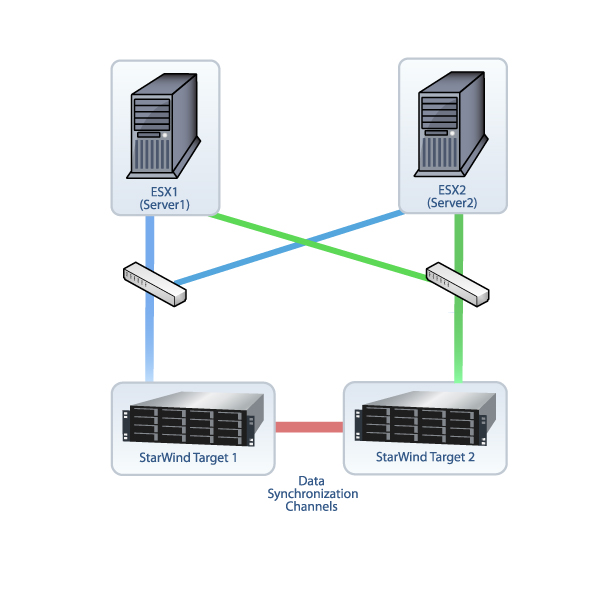

В нашем примере будет рассмотрено построение простейшей конфигурации с использование iSCSI из двух серверов, один из которых выполняет роль цели iSCSI Target на базе ESOS v 1.3.5, а другой выполняет роль хоста-инициатора iSCSI Initiator на базе

1) Сервер под роль iSCSI Target (KOM-AD01-ESOS01)

Сервер модели IBM System x3200 4362 с дисковой корзиной на 4 диска LFF HDD SAS/SATA и дополнительно установленным сетевым адаптером HP NC380T

2) Сервер под роль iSCSI Initiator (KOM-AD01-VM01)

Сервер модели HP ProLiant DL380 G5, выполняющий роль хоста виртуализации Hyper-V на базе ОС Windows Server 2012 R2 Standard. Помимо базовой комплектации в сервер дополнительно установлен сетевой адаптер HP NC380T PCI Express Dual Port Multifunction Gigabit Server Adapter (394795-B21).

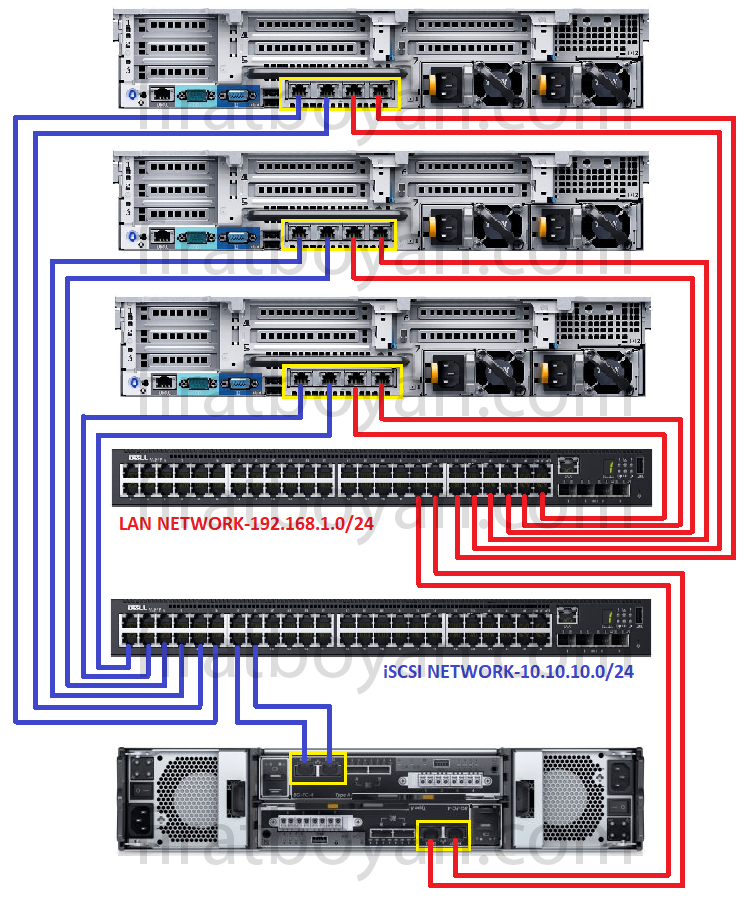

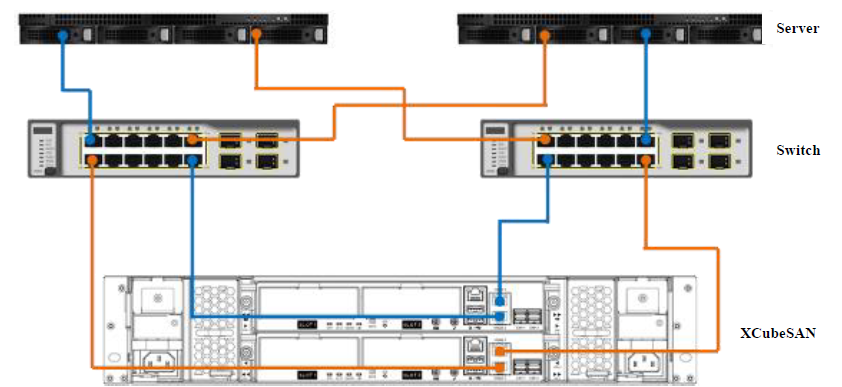

Простейшая схема подключения сетевых интерфейсов серверов будет выглядеть следующим образом:

Конфигурация RAID-контроллера на сервере IBM

Безотносительно используемой в нашем случае модели сервера и RAID-контроллера, можно сказать, что использование дистрибутива ESOS, не требующего для своей работы выделенного диска, в любой дисковой конфигурации позволит использовать под полезный дисковый объём все ресурсы дисковой корзины. В некоторых ситуациях этот аргумент может иметь существенное значение.

В нашем примере в дисковую корзину установлено 4 одинаковых диска SATA 7200 1TB.

Для того, чтобы отвязать себя от весьма скромных возможностей аппаратного RAID-контроллера, которым оснащён наш сервер, и в дальнейшем воспользоваться возможностями построения программного RAID-массива на базе ESOS, нам потребуется, чтобы для ESOS каждый диск выглядел, как отдельное физическое устройство. Поэтому во встроенной утилите управления RAID-контроллером удаляем все имеющиеся логические RAID-диски, чтобы каждый диск был представлен как отдельное устройство.

Поэтому во встроенной утилите управления RAID-контроллером удаляем все имеющиеся логические RAID-диски, чтобы каждый диск был представлен как отдельное устройство.

Некоторые RAID-контроллеры, например HP Smart Array, не позволяют транслировать подключённые диски, как самостоятельные дисковые устройства. В таких случаях потребуется создать отдельный том RAID-0 для каждого отдельно взятого диска. В нашем случае всё проще, так как установленный в нашем сервере контроллер LSI Logic SAS1064ET довольно примитивен и показывает все диски, как отдельные устройства, если эти диски не включены в аппаратный RAID-массив.

Подготовка загрузочного USB-накопителя ESOS

Загружаем последнюю актуальную версию ESOS стабильной ветки (branch 1.x.x) со страницы проекта ESOS — Package Downloads. На этой же странице можно найти описание других веток ESOS (master – разрабатываемая и 0.1.x — устаревшая).

В процессе написания этой статьи использовалась версия 1. 3.5 (25.01.2018), доступная по ссылке esos-1.3.5.zip. К моменту публикации мне уже удалось поработать с более новой версией 1.3.6 (12.04.2018).

3.5 (25.01.2018), доступная по ссылке esos-1.3.5.zip. К моменту публикации мне уже удалось поработать с более новой версией 1.3.6 (12.04.2018).

Так как ESOS, это ориентированная на ОЗУ система, запускаться она будет с подключаемого через обычный USB-порт внешнего накопителя. То есть нам потребуется USB-накопитель размером от 4GB и более. Если Вы планируете использовать ветку master branch, то для успешного обновления между версиями, согласно рекомендаций документа Upgrading, на USB-накопителе может потребоваться до 5GB дополнительного пространства. В нашем случае для ESOS успешно использовались накопители разной степени «подвальности» размером от 8GB и больше.

В документации о подготовке USB-накопителя рассматриваются варианты для Linux, Windows и MacOS. Вариант c MacOS оставим для гламурных сектантов Apple. Вариант для Windows у меня не заработал (попытка предпринималась на Windows 10, задача подготовки накопителя завершалась мутной ошибкой и в итоге загрузка с накопителя не работала). Поэтому мы остановимся на варианте подготовки накопителя на платформе Linux.

Поэтому мы остановимся на варианте подготовки накопителя на платформе Linux.

Итак, в качестве системы, на которой выполняется подготовка загрузочного USB-накопителя ESOS, в нашем примере используется Debian GNU/Linux 9, поэтому нам предварительно потребуется поставить пакет rpm2cpio:

# apt-get install rpm2cpio

Распаковываем загруженный с сайта ESOS архив во временный каталог и запускаем скрипт подготовки накопителя:

# mkdir ~/ESOS # cd ~/ESOS # unzip esos-1.3.5.zip # cd esos-1.3.5/ # ./install.sh

Скрипт выдаст список всех обнаруженных дисковых устройств. На первый заданный вопрос о выборе диска введём путь к дисковому устройству, которое ассоциировано в системе с нашим USB-накопителем. В нашем примере это /dev/sdax. Здесь важно не промахнуться и не указать какой-нибудь другой диск с полезными данными, в противном случае эти данные могут быть утеряны.

Перед форматированием накопителя нас переспросят о наших намерениях. Вводим yes

Вводим yes

Всё содержимое накопителя будет удалено и на него будет записан загружаемый раздел. По окончании процесса, скрипт предложит нам либо нажать Enter для добавления утилит управления аппаратными RAID-контроллерами (поддерживаются инструменты, упомянутые в Supported Hardware), либо завершить процедуру подготовки накопителя, нажав Ctrl+C. В нашем случае будет использоваться программный RAID-массив, поддержка которого уже заложена в ESOS, поэтому мы жмём Ctrl+C.

Первая загрузка ESOS и первичная настройка

Устанавливаем подготовленный ранее накопитель в USB порт нашего сервера IBM, а в настройках BIOS сервера включаем загрузку с этого накопителя.

Дожидаемся успешного окончания первой загрузки ESOS. Первая загрузка может занять 5-10 минут, так как в её ходе на накопителе выполняется ряд первичных служебных процедур. Последующие загрузки ESOS с этого же накопителя будут проходить значительно быстрей.

Описание процедур первичной настройки ESOS можно найти в документе Initial System Configuration

Учётные данные, используемые по умолчанию:

- Имя пользователя: root

- Пароль: esos

При входе в систему автоматически запускается специальная оболочка Text-based User Interface (TUI), максимально упрощающая работу с системой. В верхней области TUI имеется основное функциональное меню, которое позволяет выполнять все основные задачи по конфигурации сервера в качестве хранилища для сетей SAN.

Первоочередными задачами начальной настройки являются смена стандартного пароля пользователя root и настройка сети, для возможности удалённой работы с системой.

Переходим в пункты меню System > Change Password и задаём новый пароль для пользователя root.

Затем перейдём в System > Network Settings и выберем пункт настройки основных параметров сети General Network Settings

В открывшейся форме укажем имя хоста, имя DNS-домена, IP адрес шлюза по умолчанию и адреса DNS-серверов.

После изменения сетевых настроек, ESOS будет предлагать перезагрузку службы сети, для вступления внесённых изменения в силу. Пока мы не произвели всех минимальных настроек сети, можем отказаться от рестарта службы сети.

Снова вернёмся в System > Network Settings, выберем сетевой адаптер, который будет использоваться для удалённого управления ESOS и настроим параметры IP. В нашем примере используется статическая конфигурация и интерфейсу управления ESOS задан IP адрес 10.1.2.201/24. Маску сети и адрес широковещания, как я понял, указывать обязательно, иначе при сохранении настроек могут возникать ошибки.

После сохранения сделанных изменений мы снова получим вопрос о перезагрузке сети. Теперь на этот вопрос ответим утвердительно.

Сеть будет перезапущена и, в случае успешного применения заданных настроек, у нас появится возможность удалённого подключения к ESOS по протоколу SSH.

В рамках этой заметки, мы пропускаем прочие настройки, имеющиеся в ESOS, такие как настройка времени, конфигурация отсылки почты, управление дополнительными пользователями и т. д. Вместо этого мы сосредоточимся лишь на тех моментах, которые имеют значение в контексте нашей задачи. Тем не менее, прежде чем подключаться к нашему серверу ESOS по протоколу SSH, мне хочется сделать маленькое косметическое отступление относительно цветовой схемы TUI.

д. Вместо этого мы сосредоточимся лишь на тех моментах, которые имеют значение в контексте нашей задачи. Тем не менее, прежде чем подключаться к нашему серверу ESOS по протоколу SSH, мне хочется сделать маленькое косметическое отступление относительно цветовой схемы TUI.

В интерфейсе TUI ESOS есть две цветовых схемы – стандартная светлая, выдержанная в голубых и бирюзовых тонах, что на скриншотах выше, и альтернативная — тёмная, выдержанная в лучших традициях «подземелья со свечкой». Ни тот ни другой вариант, на мой взгляд, удачными не являются, так как при удалённом подключении к консоли сервера при пониженной цветопередаче (например при подключении через функцию Remote Control в IBM RSA), в некоторых местах TUI наблюдается эффект сливающегося с фоном текста. А если подключаться к TUI ESOS SSH-клиентом PuTTy с Windows-системы, то стандартные цветовые схемы вообще превращаются, на мой взгляд, во что-то «кислотное».

Так как работать с ESOS мы будем в основном конечно же с использованием удалённого SSH подключения, то, в частности, для клиента PuTTy есть простое решение – использование настраиваемых цветовых схем на стороне SSH-клиента на любой вкус и цвет. Примеры такой настройки мы рассматривали ранее в заметке Пара приёмов работы с TUI через PuTTy. Далее, для работы с ESOS через SSH мы будем использовать схему PuTTy – Twilight.

Примеры такой настройки мы рассматривали ранее в заметке Пара приёмов работы с TUI через PuTTy. Далее, для работы с ESOS через SSH мы будем использовать схему PuTTy – Twilight.

Создание программного RAID-массива в ESOS

Завершив первичную базовую настройку ESOS, переходим к конфигурации дисковой системы сервера. Выполним создание программного RAID-массива (реализовано на базе Linux Software RAID/mdraid) из 4 имеющихся в нашем распоряжении дисков. Для этого перейдём в меню Software RAID > Add Array

В перечне доступных для включения в программный RAID блочных устройств отметим диски, из которых будем создавать RAID-массив.

Выбрав диски нажмём Enter. Откроется экран настройки RAID-массива. Присвоим массиву имя в традициях mdraid, например md0. Выберем уровень RAID (в нашем случае это RAID5) и размер блока. В нашем случае массив собирается под задачи резервного копирования больших файлов дисков виртуальных машин, поэтому размер блока мы выбрали самый большой.

После нажатия кнопки OK будет запущена процедура инициализации RAID-массива. Переходим в меню навигации в Software RAID > Linux MD Status и проверяем статус созданного RAID-массива.

Здесь мы можем дождаться полного завершения построения RAID-массива, либо можно продолжить настройку нашего сервера, так как фактически дисковая ёмкость массива нам уже доступна.

Конфигурация iSCSI Target

Чтобы созданную нами дисковую ёмкость RAID-массива можно было презентовать на хост виртуализации по сети по протоколу iSCSI, на сервере ESOS нужно создать iSCSI Target. Для этого а меню навигации перейдём в Targets > Add iSCSI Target. В форме создания цели укажем имя iSCSI Qualified Name (IQN).

В нашем случае использовано предлагаемое по умолчанию имя в формате iqn.2018-03.esos.<имя сервера>:. Единственное, что я изменил в имени – убрал двоеточие в конце имени.

Единственное, что я изменил в имени – убрал двоеточие в конце имени.

После сохранения информация о цели iSCSI Target появится на главном экране ESOS, но данная цель будет находится в выключенном состоянии.

Чтобы активировать цель, перейдём в меню навигации в Targets > Enable/Disable Target, из списка целей выберем только что созданную нами цель и поменяем в её свойствах Disabled на Enabled.

Убедимся в том, что на главном экране TUI информация о состоянии цели изменилась.

Далее нам нужно описать дисковое устройство, которое будет транслироваться через созданную цель iSCSI Target. Для этого меню навигации перейдём в Devices > Add Device

Из перечня режимов трансляции устройств, описание которых можно найти в документе 36_Devices_and_Mappings — SCST I/O Modes, выбираем интересующий нас режим. В нашем примере используется режим vdisk_blockio, который обеспечивает прямой доступ к блочным устройствам и исключает использование промежуточных механизмов кеширования Linux.

После выбора режима откроется окно выбора возможных для этого режима блочных устройств. Выбираем наш RAID-массив.

После этого откроется форма настройки параметров SCST для виртуального блочного устройства vdisk_blockio. Укажем любое короткое и понятное нам имя устройства. Это имя будет в дальнейшем отображаться на стороне хоста виртуализации, выполняющего роль iSCSI Initiator, в диспетчере устройств. Поэтому в качестве имени я использовал сокращённое имя хоста и RAID-устройства — ESOS01-MD0. Остальные параметры можно оставить в значениях по умолчанию.

Сохраняем настройки виртуального блочного устройства и переходим к описанию хостов, которым разрешено подключаться к созданной нами цели iSCSI Target. Но прежде чем описать хосты, необходимо создать группу хостов. Переходим в меню Hosts > Add Group

Выбираем ранее созданную нами цель iSCSI Target, к которой будет относится создаваемая группа хостов.

Задаём любое имя группы хостов, например Group1, и жмём Enter

Итак, группа хостов создана и привязана к цели iSCSI Target. Теперь нам нужно описать каждый хост, который будет выступать в качестве iSCSI Initiator с назначением этого хоста на созданную группу хостов. В нашем случае такой хост будет всего один – наш хост виртуализации Hyper-V на базе ОС Windows Server 2012 R2.

Прежде чем добавить в ESOS хост-инициатор, выясним его имя Initiator Name на нашем хосте виртуализации. Найти (и при желании изменить) это имя можно в Панели управления Windows Server, вызвав апплет iSCSI Initiator и открыв вкладку Configuration

Как видим, в нашем случае имя хоста-инициатора — iqn.1991-05.com.microsoft:kom-ad01-vm01.holding.com.

Возвращаемся в TUI ESOS и добавляем хост-инициатор в меню Hosts > Add Initiator

При этом нас спросят к какой цели SCST Target относится добавляемый хост. Выбираем единственную ранее созданную и включённую нами цель.

Выбираем единственную ранее созданную и включённую нами цель.

Затем выбираем созданную ранее группу хостов, к которой будет привязан добавляемый хост-инициатор.

И наконец вводим IQN хоста-инициатора, которое мы выяснили ранее, и жмём Enter

Итак, на данном этапе в ESOS мы уже имеем созданную цель SCST (в нашем случае iSCSI Target), имеем виртуальное блочное устройство SCST (транслируется программный RAID-массив), нами описана группа хостов и к этой группе привязан хост-инициатор (iSCSI Initiator). Теперь нам только остаётся примапить виртуальное блочное устройство SCST к группе хостов. Для этого переходим в меню навигации в Devices > Map to Host Group.

Выбираем виртуальное блочное устройство SCST.Выбираем цель SCST.

Выбираем группу хостов, в которую был включен хост-инициатор.

Далее откроется форма настройки LUN-а, который будет транслироваться в сеть. Укажем номер LUN-а (по умолчанию первому транслируемому LUN-у присваивается номер 0) и сохраним настройки, нажав ОК.

Укажем номер LUN-а (по умолчанию первому транслируемому LUN-у присваивается номер 0) и сохраним настройки, нажав ОК.

Посмотреть итоговую конфигурацию трансляции виртуальных устройств SCST можем перейдя в меню Devices > LUN/Group Layout

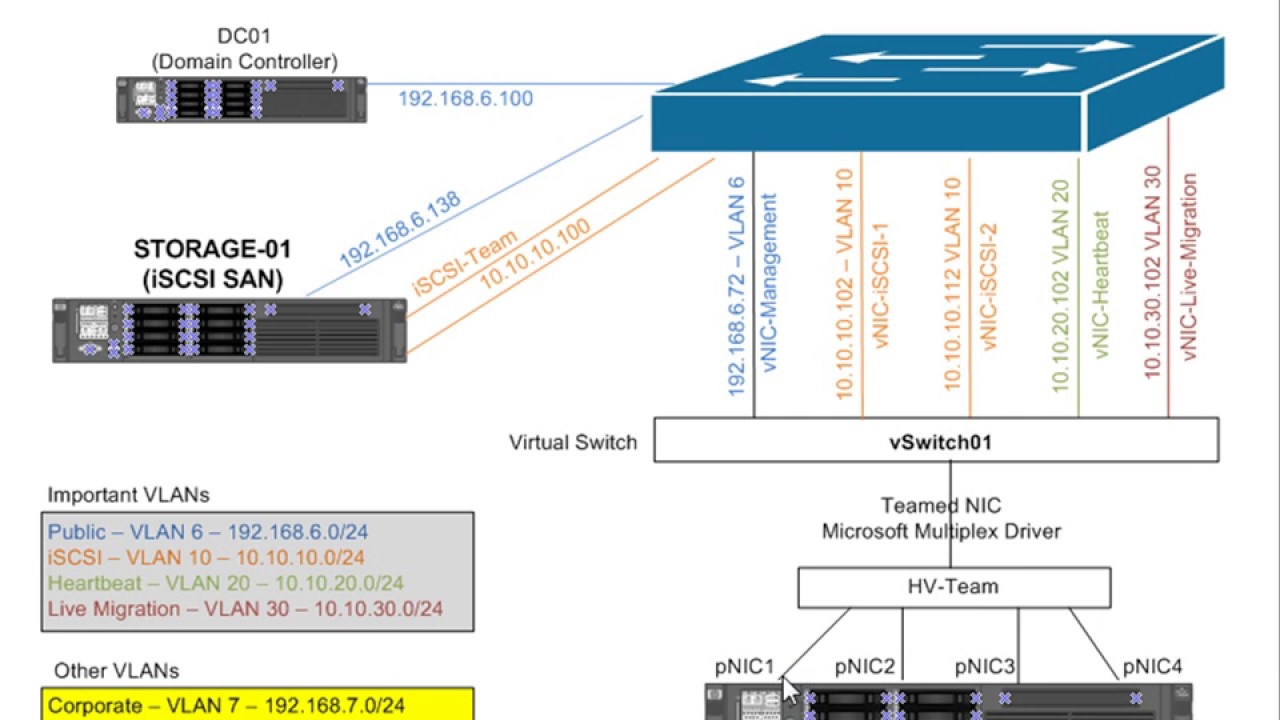

Теперь определимся с отделением сетевого трафика iSCSI от трафика управления самим сервером ESOS. Сделаем так, чтобы полностью разделить эти виды трафика по разным сетевым интерфейсам.

Для этого настроим на стороне сервера ESOS и на стороне клиента iSCSI Initiator отдельные сетевые интерфейсы с IP-адресацией отличной от адресации, используемой для управления серверами. Например, в нашем случае для управления серверами используется сеть 10.1.2.0/24, поэтому для отделения трафика iSCSI мы используем небольшую выделенную подсеть на 6 хостов — 192.168.168.0/29 (на уровне сетевого оборудования дополнительно можно изолировать данную сеть в отдельный VLAN).

Сначала настроим выделенный под iSCSI сетевой интерфейс на стороне сервера ESOS, перейдя в меню навигации в System > Network Settings и выбрав соответствующий сетевой адаптер.

Зададим на этом интерфейсе статический IP-адрес 192.168.168.1/29, укажем маску подсети, адрес широковещания и увеличенный размер MTU – 9000 (технология Jumbo Frame должна поддерживаться сетевым адаптером) для улучшения производительности при передаче больших объёмов данных.

При сохранении настроек на вопрос о перезагрузке сети ответим утвердительно (все сетевые соединения с ESOS будут временно потеряны).

По завершению процедуры перезагрузки сети мы получим сводную информацию о статусе применения новых настроек

Теперь переходим к настройке на стороне хоста-инициатора.

Конфигурация iSCSI Initiator

На стороне нашего хоста виртуализации на базе Windows Server, на который мы будем принимать по протоколу iSCSI дисковую ёмкость с сервера ESOS, настроим выделенный сетевой адаптер для использования в работе с протоколом iSCSI.

Отключим все, кроме того что может потребоваться нам на этом выделенном интерфейсе при работе с iSCSI. Например, оставим только поддержку протокола TCP/IPv4 и QoS.

Выбрав протокол TCP/IPv4 по кнопке Properties зададим IP-адрес из сети, которую мы определили под трафик iSCSI, например 192.168.168.3/29. Адрес шлюза по умолчанию и DNS-серверов оставляем пустыми. Откроем расширенные настройки кнопкой Advanced.

На вкладке DNS отключим включённую по умолчанию опцию регистрации в DNS, а на вкладке WINS отключим поддержку LMHOST и NetBIOS over TCP/IP.

Вернёмся на основную вкладку свойств сетевого интерфейса и вызовем диалог настройки параметров сетевого адаптера по кнопке Configure.

В открывшейся форме на вкладке расширенных настроек Advanced найдём опцию поддержки больших пакетов Jumbo Packet и выберем максимально возможное значение (в нашем примере это 9014). На вкладке Power Management отключим возможность отключения системой данного сетевого адаптера в режимах энергосбережения – Allow the computer to turn off this device to save mode.

На вкладке Power Management отключим возможность отключения системой данного сетевого адаптера в режимах энергосбережения – Allow the computer to turn off this device to save mode.

Закроем все окна с сохранением кнопкой ОК.

Теперь проверим доступность сервера ESOS через выделенный сетевой интерфейс. Сначала утилитой tracert, чтобы убедиться в том, что маршрутизация трафика идёт между серверами напрямую.

tracert -d 192.168.168.1

Затем с помощью утилиты ping, включив флаг запрета фрагментации (опция —f) и указав размер передаваемых пакетов (опция —l)

ping 192.168.168.1 -f -l 8000

В случае если где-то, например на коммутаторе, к которому подключены серверы ESOS и наш хост-инициатор, не включена поддержка Jumbo Frame, мы можем получить сообщения «Packet needs to be fragmented but DF set. » В нашем случае проверка прошла успешно, поэтому можно переходить к процедуре подключения iSCSI диска.

» В нашем случае проверка прошла успешно, поэтому можно переходить к процедуре подключения iSCSI диска.

Перейдём в Панель управления Windows Server, вызовем апплет iSCSI Initiator и открыв вкладку Discovery нажмём кнопку Discover Portal. В окне настроек обнаружения укажем IP адрес сервера ESOS из сети для трафика iSCSI и нажмём кнопку Advanced.

В форме расширенных настроек обнаружения в качестве локального адаптера выберем Microsoft iSCSI Initiator и настроенный ранее IP адрес из сети для трафика iSCSI – 192.168.168.3. Сохраним настройки, нажимая OK до тех пор, пока не вернёмся в главное окно апплета.

После этого перейдём на вкладку Targets, где в разделе Discovered targets должен появится ранее упомянутый IQN нашего сервера ESOS со статусом Inactive. То есть система его обнаружила, но он пока не подключен. Для того, чтобы произвести подключение к iSCSI Target воспользуемся кнопкой Connect.

Для того, чтобы произвести подключение к iSCSI Target воспользуемся кнопкой Connect.В открывшемся окне подключения обратим внимание на то, чтобы был включен признак добавления подключаемой цели в список избранных целей — Add this connection to the list of Favorite Targets (для последующего автоматического подключения к цели в случае перезагрузки сервера). Нажмём кнопку Advanced.

В форме расширенных настроек подключения явно укажем сетевые интерфейсы из сети для трафика iSCSI, которые должны быть задействованы для передачи iSCSI трафика для данного сессионного подключения. То есть в качестве Initiator IP выберем из списка адрес выделенного на нашем хосте iSCSI-интерфейса 192.168.168.3, а в качестве Target portal IP выберем из списка адрес выделенного на сервере ESOS iSCSI-интерфейса — 192.168.168.1.

Закроем с сохранением окна Advanced Settings и Connect to Target и удостоверимся в том, что статус подключения изменился на Connected

Заглянем на вкладку Favorite Targets и убедимся в том, что подключенная цель попала в список избранных.

Убедимся в том, что в консоли управления “Диспетчер устройств”/Device Manager (devmgmt.msc) в разделе Disk drives появился дополнительный SCSI-диск с именем, которое ранее мы определяли на сервере ESOS для виртуального блочного устройства SCST.

Следующим шагом нам нужно выполнить инициализацию подключенного по протоколу iSCSI диска. Для этого перейдём в консоль управления дисками Disk Management (diskmgmt.msc), выберем соответствующий диск и переведём его в состояние Online.

После того как диск успешно изменит свой статус, проведём инициализацию диска и отформатируем его “по вкусу”, например в файловую систему NTFS, задав любую понятную нам метку тома. С этого момента в графическом интерфейсе Windows данный диск станет нам доступен для стандартных файловых операций.

На данном этапе, если мы заглянем в консоль сервера ESOS, то увидим в нижней части TUI информацию о сессии подключения хоста-инициатора.

На этом основную настройку простейшей конфигурацией iSCSI можно считать законченной.

Простейшая проверка производительности

После подключения диска по iSCSI желательно провести хотя бы какие-то нехитрые замеры производительности, чтобы понимать то, что у нас получилось в конечном итоге и то, чего можно ожидать от такого диска.

Полагаться на цифры, которые при копировании больших файлов с локального диска сервера на iSCSI диск показывает нам проводник Windows особо не стоит, так как объективной информации мы там не увидим. Например, в моём случае при копировании нескольких больших ISO-файлов (с разным содержимым) скорость обозначилась в районе 150-160 MB/s, что отличается в большую строну от реальной допустимой скорости iSCSI-линка между двумя моими серверами в 1Gbit/s (~ 125MB/s). К тому же более или менее похожая на правду скорость отображается при копировании первого файла, а при копировании последующих файлов она несколько увеличивается (возможно включается в работу кеш файловой системы и прочие другие кеши разных уровней).

Для разного рода замеров всегда хочется использовать какие-то “родные” инструменты, не требующие установки дополнительного ПО, но к сожалению это далеко не всегда возможно. В клиентских системах Windows для оценки производительности разных подсистем, в том числе и дисковой, используется утилита WinSAT (winsat disk), однако в составе Windows Server 2012 R2 этой утилиты я не обнаружил. Поэтому

я скопировал с имеющейся по рукой клиентской ОС Windows 10 x64 два файла — WinSAT.exe и WinSATAPI.dll из каталога %windir%\System32 в аналогичный каталог сервера. Теперь можно попробовать воспользоваться этой утилитой, запустив её из командной строки с правами администратора.

winsat disk -drive T -count 3

Здесь после ключевого слова disk в опции –drive указывается имя буквы диска, который мы желаем протестировать, а в опции –count указывается количество циклов тестирования.

Как я понял, данная утилита не позволяет проводить тестирование оперируя большими блоками данных (более 1MB), то есть она больше подходит для тестирования ситуаций с большим количеством мелких файлов. У нас же ситуация обратная – резервное копирование дисков виртуальных машин предполагают малое количество файлов существенного размера.

У нас же ситуация обратная – резервное копирование дисков виртуальных машин предполагают малое количество файлов существенного размера.

Ещё одним простым инструментом является утилита Diskspd (DiskSpd: A Robust Storage Performance Tool), пришедшая на замену утилите SQLIO Disk Subsystem Benchmark Tool (SQLIO). Скачиваем утилиту, распаковываем на сервере и запускаем с набором параметров, отвечающим контексту нашей задачи.

cd /d C:\Tools\Diskspd-v2.0.17\amd64fre\ Diskspd.exe -d60 -b1M -s -w100 -t1 -c100G T:\io1.dat T:\io2.dat

Используемые нами параметры означают:

-d60 : Время выполнения теста 60 секунд

-b1M : Оперировать блоками по 1MB

-s : Выполнять операции с последовательным доступом

-w100 : Выполнять полный тест на запись (тест на чтение не выполняется)

-t1 : Количество потоков работы с целью (с файлом T:\io.dat)

-c100G : Создавать файлы размером 100GB

В конце перечислены имена генерируемых для теста файлов.

Немного отклоняясь, отмечу, что на момент написания статьи для задачи резервного копирования виртуальных машин Hyper-V у нас используется ПО Veeam Backup & Replication, поэтому при выборе размера блока для проведения тестов я буду отталкиваться от специфики этого ПО. Как я понял из документа Data Compression and Deduplication, VBR в операциях резервного копирования на SAN использует блоки по 1024MB, поэму именно такой размер блока мы и будем использовать при тестировании.

Как я понял из документа Data Compression and Deduplication, VBR в операциях резервного копирования на SAN использует блоки по 1024MB, поэму именно такой размер блока мы и будем использовать при тестировании.

Для сравнения проведём ещё раз тест с тем же набором условий, но увеличим его продолжительность до 5 минут

Diskspd.exe -d300 -b1M -s -w100 -t1 -c100G T:\io1.dat T:\io2.dat

Здесь хорошо видно, что при длительной нагрузке показатели заметно проседают. Могу предположить, что связано это с тем что “бутылочное горлышко” в этом случае перемещается из области сетевой подсистемы в область медленных дисков, используемых у нас на стороне сервера ESOS.

Для любителей графических инструментов для проведения подобных поверхностных тестов производительности дисковой подсистемы на Windows может пригодиться ещё одна простая бесплатная утилита ATTO Disk Benchmark. Загрузить её можно по ссылке: Disk Benchmark. Интерфейс утилиты прост и понятен и комментировать по ней, пожалуй, нечего.

О каких-то более сложных инструментах тестирования, как например IOMeter, я не говорю, так как в рамках нашей задачи нет цели заниматься бенчмарками как таковыми. А показатели простых инструментов получаются лишь для того, чтобы иметь базу для сравнения в дальнейшем, когда между сервером ESOS и хостом Hyper-V у нас будет не один линк, как на данном этапе настройки, а два линка и задействованный механизм Multipath.

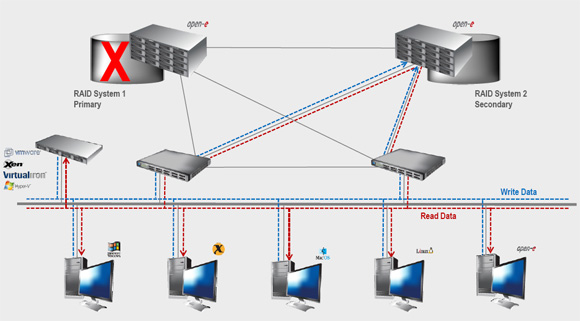

Настройка Multipath

Итак, мы имеем подключенный по iSCSI диск и некие базовые показатели тестов производительности, от которых можем отталкиваться. Теперь попробуем улучшить эти показатели, добавив на сервер ESOS и хост-инициатор ещё по одному гигабитному сетевому адаптеру и объединив их работу с помощью механизма Multipath на стороне хоста-инициатора.

Начнём с настройки сервера ESOS. В главном меню навигации перейдём в System > Network Settings, выберем дополнительный сетевой адаптер, который будет использоваться для ещё одного подключения по протоколу iSCSI и настроим параметры IP. В нашем примере используется статическая конфигурация и дополнительному iSCSI-интерфейсу ESOS задан IP адрес 192.168.168.2/29, а также дополнительно увеличен размер MTU.

В нашем примере используется статическая конфигурация и дополнительному iSCSI-интерфейсу ESOS задан IP адрес 192.168.168.2/29, а также дополнительно увеличен размер MTU.

Сохраняем настройки сети в ESOS и переходим к настройке дополнительного сетевого адаптера на стороне хоста-инициатора, то есть нашего сервера на базе Windows Server с iSCSI Initiator.

Настраиваем по аналогии с первым второй iSCSI-интерфейс, задав ему IP 192.168.168.4/29

Отключим ранее настроенный интерфейс c адресом 192.168.168.3 (iSCSI диск при этом у нас отвалится) и убедимся в том, что дополнительно настроенные iSCSI-интерфейсы сервера ESOS и хоста-инициатора видят друг друга.

В апплете Панели управления iSCSI Initiator на вкладке Discovery добавим дополнительный путь обнаружения, указав связку 192.168.168.2 — 192.168.168.4

Так как ранее мы создали iSCSI подключение к цели без включённого признака multi-path, то теперь нам будет правильней деактивировать это подключение и создать его заново, но уже с включенным признаком multi-path..png)

Сначала удалим созданное ранее подключение из автозагрузки на вкладке Favorite Targets

Теперь перейдём на вкладку Targets и выполним отключение (инициализированный и подключенный в системе iSCSI диск при этом исчезнет из Windows)

Затем выполним повторное подключение цели iSCSI, но на этот раз уже с включённой опцией Enable multi-path (и не забываем по кнопке Advanced произвести явную связку интерфейсов 192.168.168.1 — 192.168.168.3)

Убедившись в том, что цель снова перешла в состояние Connected откроем её свойства, чтобы добавить второе подключение по дополнительному выделенному интерфейсу

На вкладке Targets зайдём по кнопке Properties в свойства подключенной цели, и воспользуемся кнопкой Add session, чтобы настроить второе подключение.

Кстати, здесь по кнопке MCS мы сможем убедится в том, что первая установленная сессия действительно использует заданный нами выделенный сетевой интерфейс.

Итак, используя кнопку Add session добавим дополнительное подключение к iSCSI Target указав в качестве интерфейсов дополнительную пару интерфейсов, которую мы настроили ранее (192.168.168.2 — 192.168.168.4)

Теперь в списке сессий должна появиться запись о второй сессии.

Также созданную дополнительную сессию мы увидим и на стороне сервер ESOS.

На стороне хоста-инициатора заглянем в оснастку “Диспетчер устройств”/Device Manager (devmgmt.msc) и убедимся в том, что в разделе Disk drives появился дополнительный SCSI-диск с тем же именем (ESOS01-MD0).

То есть сейчас, на стороне Windows-сервера мы фактически видим один и тот же диск, как два отдельных устройства. Чтобы система смогла работать с этим диском, как с единым устройством, используя оба сетевых линка iSCSI до сервера ESOS, нам потребуется включить поддержку MPIO для iSCSI. Для этого переходим в Панель управления Windows, открываем апплет MPIO и на вкладке Discover Multi-Paths включаем опцию Add support for iSCSI devices. После этого нажимаем кнопку Add и утвердительно отвечаем на вопрос о перезагрузке сервера.

Для этого переходим в Панель управления Windows, открываем апплет MPIO и на вкладке Discover Multi-Paths включаем опцию Add support for iSCSI devices. После этого нажимаем кнопку Add и утвердительно отвечаем на вопрос о перезагрузке сервера.

После перезагрузки снова заглянем в консоль Device Manager и убедимся в том, что теперь наш iSCSI диск отображается, как единое устройство и имеет имени …Multi-Path Disk Device . Откроем свойства диска и на вкладке MPIO проверим то, что диск доступен по двум путям.

Более подробную информацию о маршрутах подключения можем увидеть в апплете панели управления iSCSI Initiator.

Здесь по кнопке MPIO мы увидим информацию об используемых подключениях.

На этом базовую настройку Multipath можно считать законченной.

Теперь для того, чтобы оценить изменения в скорости работы с iSCSI-диском, которые мы получили в результате организации второго линка и настройки Multipath проведем простой тест линейной записи больших файлов на диск по аналогии с тем, что делали ранее:

Diskspd.exe -d60 -b1M -s -w100 -t1 -c100G T:\io1.dat T:\io2.dat

Судя по тому, что нам показывает Diskspd в данном случае, в среднем в каждый из файлов запись прошла со скоростью ~225MB/s, что равно 1800Mb/s. То есть в итоге мы получаем скорость приближенную к суммарной пропускной способности двух организованных линков iSCSI.

Тот же тест, но более продолжительный по времени (5 минут):

Diskspd.exe -d300 -b1M -s -w100 -t1 -c100G T:\io1.dat T:\io2.dat

Средняя величина в ~48.5 MB/s, полученная при работе с каждым файлом, выглядит ощутимо лучше, чем полученные ранее 16 MB/s на одном линке iSCSI.

На основании этих нехитрых замеров мы можем понять, что благодаря организации Multipath-подключения мы не только увеличили его доступность, но и получили улучшенные показатели производительности. И это хорошо.

Горячая замена USB-накопителя ESOS

Учитывая то, что собирая бюджетное решение, описанное в рамках нашего примера, мы могли использовать дешёвые USB-накопители, в некоторых случаях может возникнуть потребность в замене этого накопителя (например при его выходе из строя). Учитывая то, что ESOS это Linux-система полностью адаптированная к работе в оперативной памяти, замена USB-накопителя является очень простой операцией, корректная обработка которой реализована разработчиком этой системы.

Учитывая то, что ESOS это Linux-система полностью адаптированная к работе в оперативной памяти, замена USB-накопителя является очень простой операцией, корректная обработка которой реализована разработчиком этой системы.

Фактически выполняется замена накопителя в несколько простых действий:

- На уже загруженной и работающей системе ESOS в любой момент времени извлекаем USB-накопитель (накопитель, который нужно заменить), с которого эта система была загружена.

- Подготавливаем новый USB-накопитель с ESOS стандартным методом, описанным выше в разделе “Подготовка загрузочного USB-накопителя ESOS”, и устанавливаем этот накопитель в работающий сервер ESOS.

- Вызываем процедуру синхронизации работающей в оперативной памяти конфигурации ESOS с файловой системой на USB-накопителе. Пункт меню System > Sync Configuration

После этого желательно перезагрузить сервер и убедиться в том, что с нового USB-накопителя система запускается успешно. В процессе первой загрузки с заменённого USB-накопителя ESOS выполнит некоторые служебные процедуры и уже буквально через несколько минут сервер будет готов к работе, подгрузив ранее настроенную нами конфигурацию.

В процессе первой загрузки с заменённого USB-накопителя ESOS выполнит некоторые служебные процедуры и уже буквально через несколько минут сервер будет готов к работе, подгрузив ранее настроенную нами конфигурацию.

Судя по описанию документа 13_Upgrading, точно таким же нехитрым образом выполняется обновление сервера ESOS на более новую версию, что существенно облегчает обслуживание такой системы.

Заключение

В заключении хочу сказать, что в нашем примере, благодаря системе ESOS, нам удалось выжать максимум из дисковой корзины устаревшего во всех отношениях сервера и получить на хосте виртуализации вполне сносную по производительности дисковую ёмкость под задачу резервного копирования виртуальных машин. И мне остаётся только поблагодарить разработчика ESOS за проделанный труд и пожелать проекту дальнейшего успешного развития.

Поделиться ссылкой на эту запись:

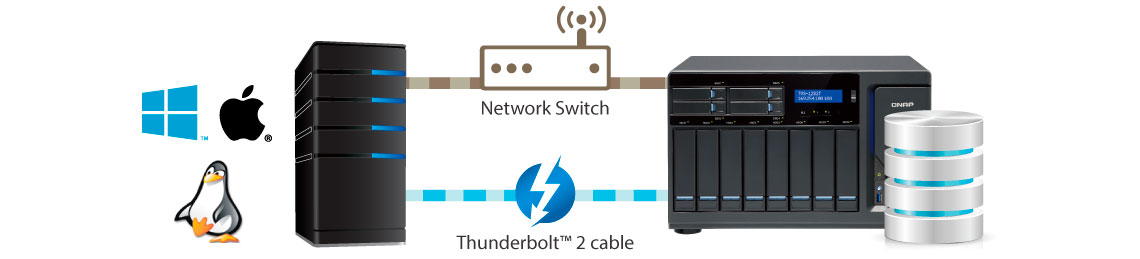

ПохожееПодключение к iSCSI Target, созданной на сетевом хранилище с ОС Linux – QNAP Россия и СНГ

Сетевые хранилища QNAP могут одновременно служить в качестве NAS (Network Attached Storage) для организации совместного доступа к файлам и быть частью облачных сред, с использованием iSCSI.

Если вы используете другую операционную систему: Windows, OS X.

Откройте Главное Меню и найдите приложение Terminal.

Установите пакет open-iscsi

sudo apt-get install open-iscsi

Откройте файл конфигурации Open-iSCSI Initiator редактором Nano.

nano /etc/iscsi/iscsid.conf

Найдите строку node.startup = automatic и уберите знак # в начале строки. Это нужно сделать для того, чтобы iSCSI LUN монтировался при загрузке операционной системы.

Перезагрузите службу open-iscsi

/etc/init.d/open-iscsi restart

Выполните обнаружение целей iSCSI.

iscsiadm -m discovery -t sendtargets -p 192.168.10.101:3260

Отметьте один или несколько узлов iSCSI, которые требуется подключить.

iscsiadm -m node

Войдите в цель iSCSI следующей командой

iscsiadm -m node —targetname «iqn.2004-04.com.qnap:ts-469pro:iscsi.ts469.dd1c10» —portal «192.168.10.101:3260» —login

Если все пройдет успешно, вы увидите сообщение следующего вида:

Login to [iface: default, target: iqn.2004-04.com.qnap:ts-469pro:iscsi.ts469.dd1c10, portal: 192.168.10.101,3260]: successful

Создайте раздел на подключенном iSCSI-диске.

fdisk /dev/sde

В мастере разделов нажмите клавишу n, выберите требуемые параметры, после чего нажмите на клавишу w для того, чтобы сохранить настройки.

Отформатируйте созданный раздел.

mkfs.ext4 /dev/sde1

Создайте папку монтирования.

mkdir /mnt/iscsi

Примонтируйте Lun.

mount -t ext4 /dev/sde1 /mnt/iscsi/

На этом настройка окончена, виртуальный диск подключен в папку /mnt/iscsi

KB-4142

san, iscsi

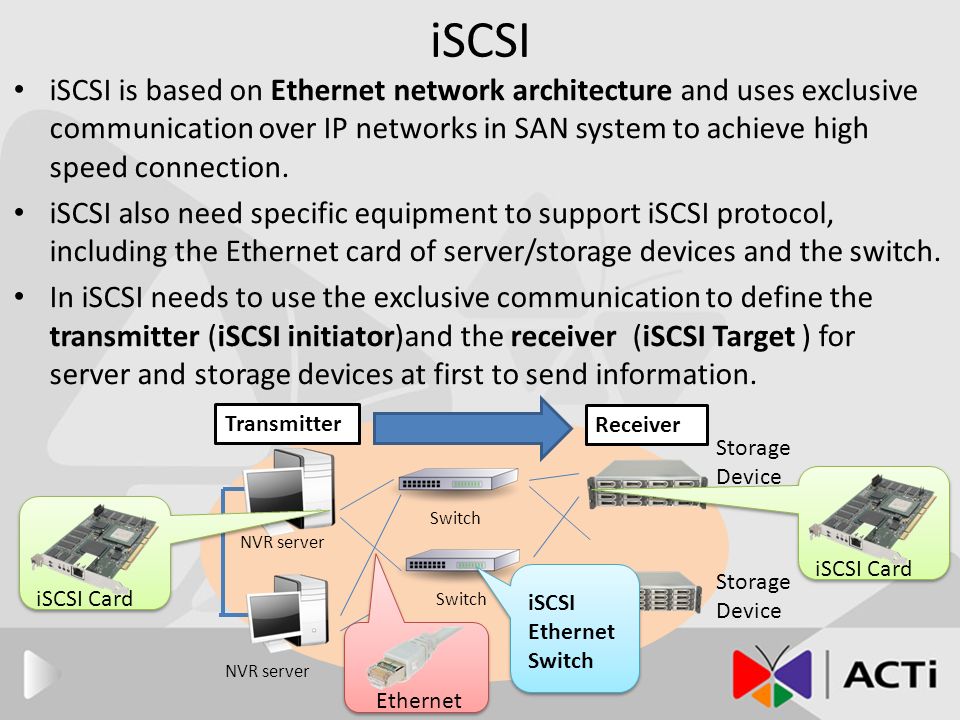

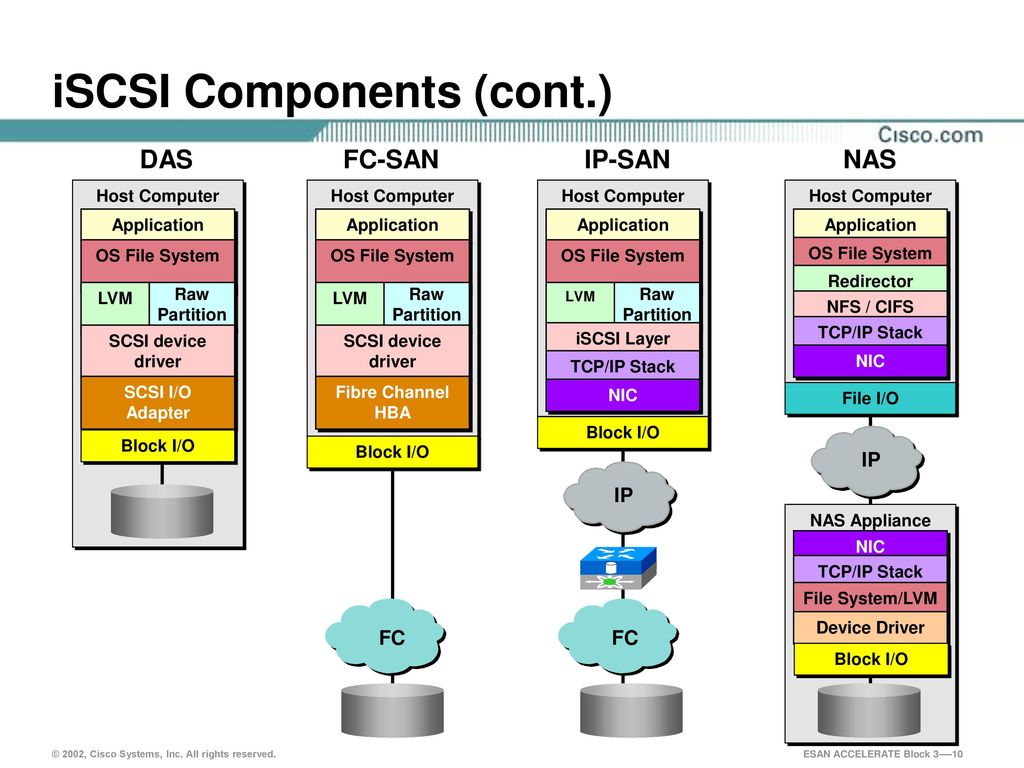

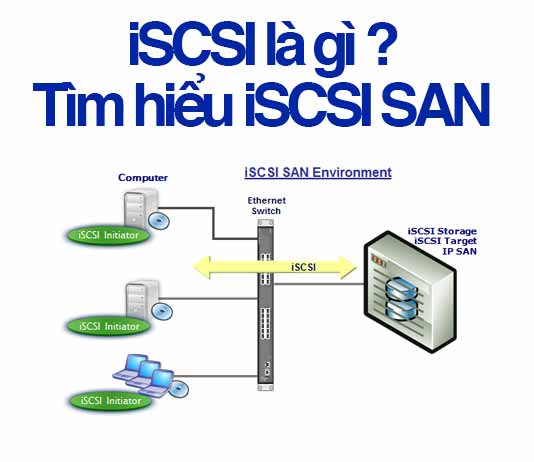

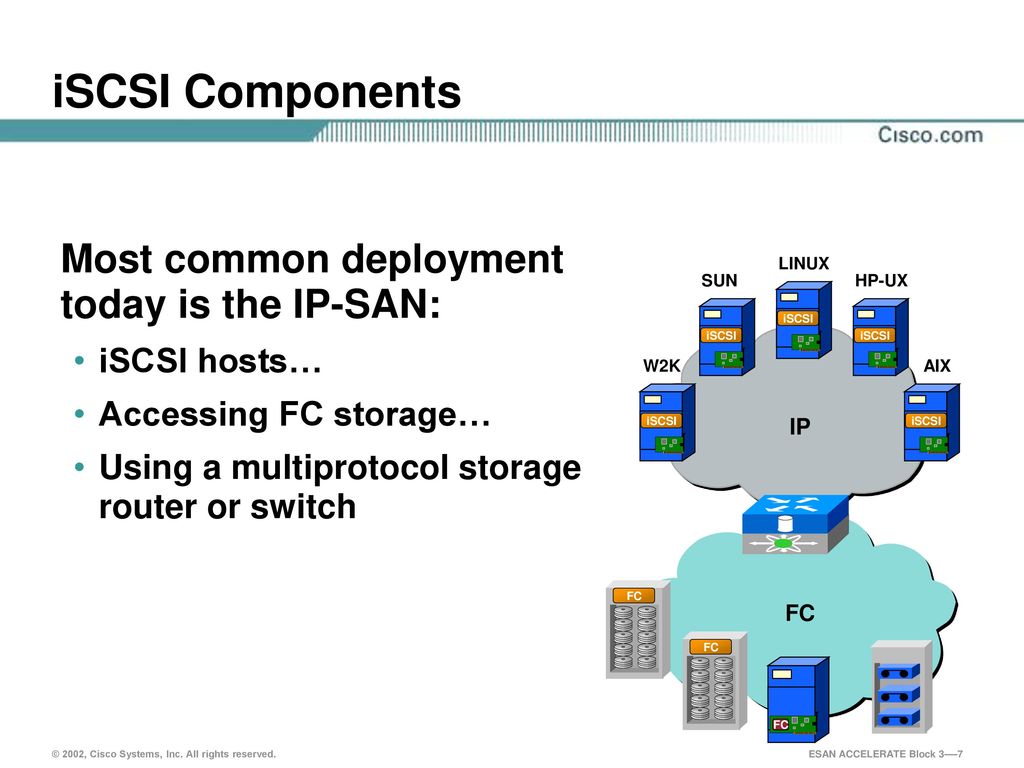

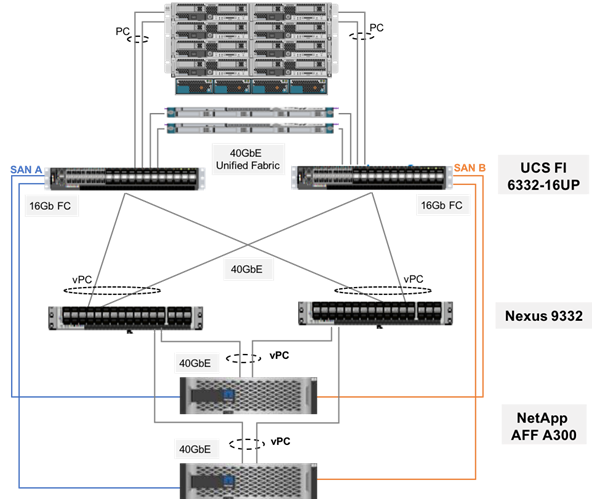

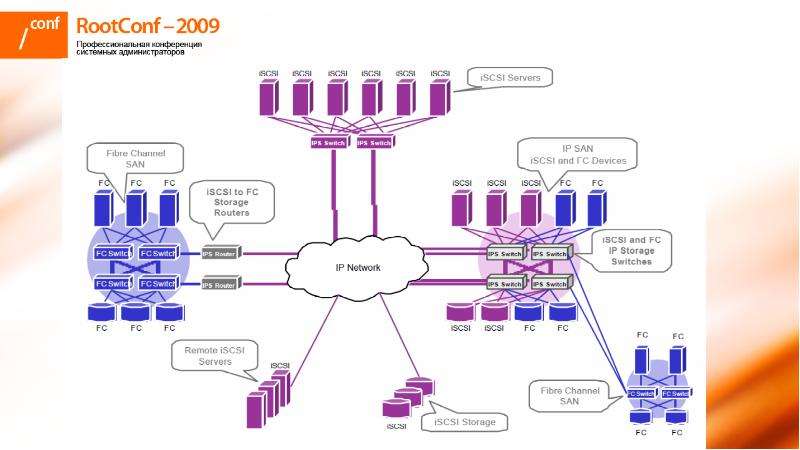

Storage Area Network, SAN — сеть хранения данных. Инфраструктура SAN предполагает создание выделенной сети только под данные. В случае iSCSI SAN такая сеть строится поверх обычной инфраструктуры IP.

Используются обычные коммутаторы Ethernet, а в серверах в качестве контроллеров используются более или менее специализированные аппаратные инициаторы iSCSI(iSCSI HBA) или обыкновенные сетевые контроллеры (за счет использования программного инициатора — службы, входящей в состав ESX(i) любых редакций). За счет использования стандартной, относительно дешевой и часто уже имеющейся инфраструктуры IP, iSCSI SAN может оказаться дешевле FC SAN. -сервер.

-сервер.

Инициатор iSCSI в более узком смысле — это контроллер, который обеспечивает подключение к iSCSI СХД.

Инициатор iSCSI — это контроллер SCSI, который принимает команды SCSI от VMkernel, упаковывает их в пакеты IP и отправляет по Ethernet на хранилище. Получает в ответ пакеты IP, извлекает из них команды SCSI и отдает их гипервизору.

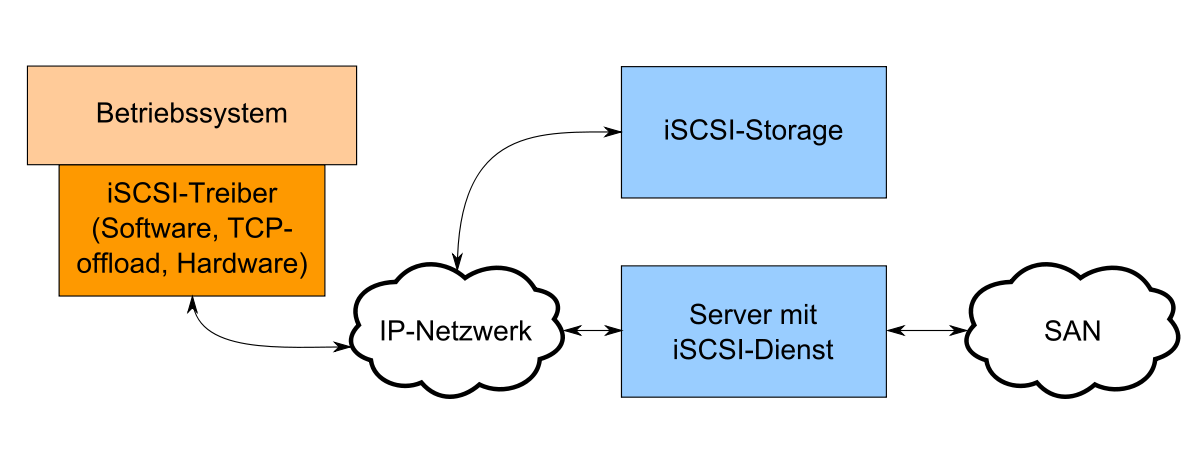

iSCSI инициатор бывает аппаратный, с аппаратной поддержкой и программный (рис. 3.15).

В случае аппаратного инициатора ESX(i) видит его как обычный дисковый контроллер, HBA. Гипервизор отдает SCSI команды его драйверу, тот передает их контроллеру, и контроллер на своем чипе инкапсулирует их в IP, которые сам отдает в сеть.

Рис. 3.15. Иллюстрация разницы между вариантами инициатора iSCSI

Источник: VMware

В случае программной реализации гипервизор передает команды SCSI на вход службе программного инициатора iSCSI, та запаковывает SCSI в IP, а IP отдает стеку TCP/IP VMkernel. А VMkernel через обычные сетевые контроллеры отдает эти пакеты в сеть. Однако во множестве случаев производительности и обеспечиваемой скорости у программного iSCSI оказывается вполне достаточно.

Однако во множестве случаев производительности и обеспечиваемой скорости у программного iSCSI оказывается вполне достаточно.

В случае промежуточной реализации у нас есть контроллеры, которые одновременно и являются сетевыми, и предоставляют функционал iSCSI инициатора. Отличие таких сетевых контроллеров от аппаратных инициаторов iSCSI — в том, что каждый такой контроллер отображается одновременно и как сетевой, и как дисковый контроллер в интерфейсе ESX(i). Зависимые инициаторы требуют настройки сети такие же, как и программный инициатор, то есть создание виртуальных сетевых интерфейсов VMkernel, назначение их на соответствующие физические сетевые контроллеры, настройка Discovery.

Плюсы программного инициатора — для его использования можно ничего дополнительно не приобретать или приобретать лишь дополнительные сетевые контроллеры. Но максимальная скорость может быть меньше, и возрастает нагрузка на процессоры сервера.

В принципе, для использования iSCSI с ESX(i), кроме самой СХД с поддержкой iSCSI, не надо ничего — в составе ESX(i) есть программный инициатор, то есть серверу достаточно иметь обычные сетевые контроллеры, подключенные к обычным коммутаторам. Однако для использования iSCSI в производственной среде обычно оправдано организовать выделенную под iSCSI инфраструктуру IP — коммутаторы и сетевые контроллеры серверов.

Однако для использования iSCSI в производственной среде обычно оправдано организовать выделенную под iSCSI инфраструктуру IP — коммутаторы и сетевые контроллеры серверов.

Плюсы аппаратного и зависимого инициаторов — потенциально большая производительность, меньшая нагрузка на процессоры сервера. Минусы — его надо покупать.

С точки зрения ОС (здесь — ESX(i)), аппаратный iSCSI HBA — это контроллер SCSI, не отличающийся от FC HBA. То, что FC HBA оборачивает SCSI в пакеты fibre channel, а iSCSI HBA — в пакеты IP, для ОС прозрачно, и она их воспринимает одинаково. То есть если у вас есть аппаратный инициатор, то нужно настроить только его — указать ему собственный IP-адрес и IP-адреса СХД (iSCSI target).

Но, в отличие от FC HBA, инициатор iSCSI может быть программный. Самое для нас главное — в ESX(i) такой программный инициатор есть.

⇐3.4.3. про зонирование (zoning) и маскировку (lun masking, lun presentation) | Администрирование VMware vSphere | 3.5.1. как настроить программный инициатор или аппаратный зависимый iscsi на esx(i)⇒

iscsi — Перевод на русский — примеры английский

На основании Вашего запроса эти примеры могут содержать грубую лексику.

На основании Вашего запроса эти примеры могут содержать разговорную лексику.

The iSCSI initiator driver and user-mode utilities are available in Red Hat Enterprise Linux 4 Update 2.

В Red Hat Enterprise Linux 4 Update 2 доступны драйверы инициатора iSCSI и утилиты пользовательского режима.There is also no support for iSCSI configuration in the Anaconda installation program.

Также нет поддержки конфигурации iSCSI в программе установки Anaconda.There are many options available to make a Windows server into a software-based iSCSI server.

Существует множество вариантов преобразования сервера Windows в сервер iSCSI на базе ПО.

In this regard it is more comparable to Fibre Channel over Ethernet than iSCSI.

Исходя из этого, можно считать, что АоЕ скорее сравним с Fibre Channel over Ethernet, чем с iSCSI.In essence, iSCSI allows two hosts to negotiate and then exchange SCSI commands using Internet Protocol (IP) networks.

По сути, iSCSI позволяет двум хостам согласовать соединение и после этого обмениваться командами SCSI с помощью интернет протокола(IP).In this new article we will show how to configure our server to provide storage QNAP NAS iSCSI our virtualization environment.

В этой новой статье мы покажем, как настроить наш сервер, чтобы обеспечить хранение QNAP NAS ISCSI виртуализации нашей окружающей среды.

FreeNAS — like Open Filer, FreeNAS is an opensource iSCSI SAN.

FreeNAS — как и Open Filer, решение FreeNAS также является iSCSI SAN решением с открытым исходным кодом.Sure, you can buy a hardware-based iSCSI SAN like the Iomega Storcenter ix2-200 or the Drobo Pro (a couple of my favorites).

Конечно, вы можете купить iSCSI SAN на базе аппаратного оборудования, как например Iomega Storcenter ix2-200 или Drobo Pro (пара моих любимых решений).What are the options available in order to create a software-based Windows iSCSI Server?

Какие существуют варианты создания сервера Windows iSCSI Server на базе программного обеспечения? Nexus IT Solutions has signed a reseller contract with StarWind Software Inc. , a leading global provider of storage virtualization and Open iSCSI SAN solutions.

, a leading global provider of storage virtualization and Open iSCSI SAN solutions.

StarWind Software — recently I saw a webcast covering Starwind’s iSCSI solution which was presented by fellow vExpert Greg Shields.

StarWind Software — недавно я просматривал веб каст о iSCSI решении от компании Starwind, который вел сотрудник vExpert, Грег Шилдс (Greg Shields).Not only do they have a free iSCSI server option but, from there, you can upgrade to a one of 4 advanced versions (see Starwind’s Editions page).

Они не только предоставляют опцию бесплатного сервера iSCSI, но с этого решения вы можете обновиться до одной из четырех расширенных версий (смотрите страницу Starwind’s Editions).

Networking protocols supported by Openfiler include: NFS, SMB/CIFS, HTTP/WebDAV, FTP and iSCSI (initiator and target).

Openfiler поддерживает следующие сетевые протоколы: Network File System, SMB/CIFS, HTTP/WebDAV, FTP and iSCSI (таргет и инициатор), FC (таргет и инициатор).On the Windows platform, the closest equivalent solution is to use a technology like Intel vPro to run a client-side hypervisor and mount the root filesystem image using iSCSI.

На платформе Windows, ближайшим аналогом является использование технологий типа Intel vPro для запуска гипервизора на стороне клиента и монтирования образа корневой файловой системы, используя iSCSI.As a result, iSCSI is often seen as a low-cost alternative to Fibre Channel, which requires dedicated infrastructure except in its FCoE (Fibre Channel over Ethernet) form.

В результате, iSCSI часто используется как удешевленная альтернатива для волоконного канала(Fibre Channel), которому требуется собственная, отдельная инфраструктура, за исключением одного из вариантов его реализации(FCoE — Fibre Channel over Ethernet).By doing this, this unused disk space is used and you don’t need a separate physical server for your iSCSI SAN (as long as you were already using VMware ESX).

В результате это неиспользуемое дисковое пространство используется, и вам не нужен отдельный физический сервер для вашей iSCSI SAN (если вы уже использовали VMware ESX).At the start of this article, I mentioned how I had written a number of articles on how to connect your PC or server to an iSCSI SAN.

В начале этой статьи я упомянул о том, что писал ряд статей о том, как подключать ваши ПК или серверы к iSCSI SAN.I have written numerous articles on how to connect your server or workstation to an iSCSI server but not many on what the various software options are, how they differ, or where to find them.

Я писал большое количество статей о том, как подключать свой сервер или рабочую станцию к серверу iSCSI, однако лишь несколько статей было посвящено рассмотрению софтверных опций, их отличиям или где их найти.I will start with why you need an iSCSI Server and then move on the cover the various free and commercial software options to turn a Windows Server into a shared file store.

Я начну с того, для чего нужен iSCSI сервер, а затем мы рассмотрим некоторые бесплатные и платные программные продукты, которые позволяют преобразовать сервер Windows Server в общее хранилище файлов.Because iSNS is able to emulate Fibre Channel fabric services and manage both iSCSI and Fibre Channel devices, an iSNS server can be used as a consolidated configuration point for an entire storage network.

Из-за того, что iSNS способен эмулировать фабрику сервисов Fibre Channel, и управлять как ISCSI, так и Fibre Channel устройствами, iSNS сервер может быть использован в качестве объединяющего пункта для всей сети хранения.|

Готовое решение для малого бизнеса StarWind Native SAN for Hyper-V. Отказоустойчивый кластер без покупки внешнего хранилища. |

|

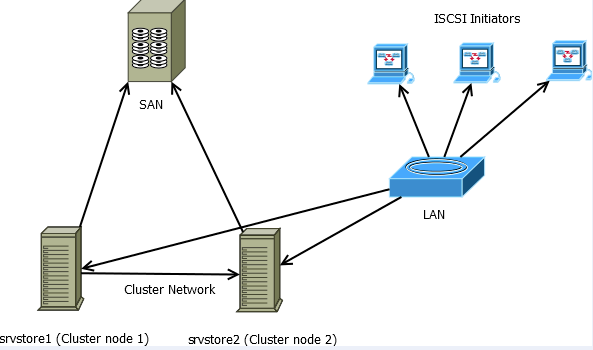

Эта статья описывает создание сетевого iSCSI хранилища на базе FreeNAS с последующим подключением к гипервизору ESXi 5.0 Есть, как минимум, два основных варианта создания такого хранилища. В первом RAID создается на аппаратном контроллере, а потом уже готовые разделы отдаются через iSCSI сервис в качестве LUN-ов. Во втором, более сложном варианте, RAID собирается софтверный силами FreeNAS и уже на нем создаются разделы, которые можно будет отдать по iSCSI. Не берусь судить, какой из способов более правильный, каждый это решит для себя сам. Сам FreeNAS в доках первый вариант почти не рассматривает, описывая прелести второго с файловой системой ZFS, он же будет описан и в статье. |

| 1. Первым делом создаем RAID из имеющихся у нас дисков. Файловая система должна быть ZFS. Если вы выберете UFS, то отдать раздел по iSCSI вы не сможете. Необходимо заметить, что для работы ZFS требуется большой объем оперативной памяти, лучше, если это будет 8 Гб. Если у вашего FreeNAS не будет хотя бы 4Гб, то начнутся проблемы с ZFS. Storage –> Active Volumes –> Create Volume –> Add Volume |

2. На созданном Raid Volume, создаем еще один раздел ZFS. Указываем название раздела, его размер (например, 100Gib) и уровень сжатия. В результате, получаем раздел FreeNAS1, который мы сможем отдать хостам ESXi по протоколу iSCSI. Storage –> Active Volumes –> Create ZFS Volume –> Add ZFS Volume |

3. Теперь можем приступить к настройке iSCSI службы. Если у вас RAID был создан на аппаратном контроллере, то первые два шага можно пропустить и сразу приступить к конфигурации iSCSI. Для этого переходим в раздел Services и жмем по изображению гаечного ключа напротив iSCSI выключателя, у нас открывается новая вкладка iSCSI. |

| 4. Здесь будет описана минимально необходимая настройка, которая будет работать без авторизации на всех IP адресах назначенных моему FreeNAS. Как вы поймете в процессе, настроек у этого сервиса в FreeNAS 8.1 больше чем у остальных. Нам нужно по очереди посетить 5 разделов во вкладке iSCSI. |

| 5. iSCSI –> Portals –> Add Portal . Создаем портал, который будет слушать все интерфейсы FreeNAS на порту 3260. Если это первый портал, то ему присваивается ID 1 |

| 6. iSCSI –> Authorized Initiator –> Add Authorized Initiator . Создаем логический объект, который может быть использован для разделения доступа к LUN-ам. В нашем случае, он будет создан с номером ID 1, который не будет проверять инициатора и не будет проверять из какой сети происходит доступ, а будет пускать всех. Существует рекомендация о создании отдельной сети передачи данных между хостами ESXi и системами хранения данных, если такая сеть будет создана, то ее можно будет прописать здесь (Authorized network). |

7. iSCSI –> Targets –> Add Target. Добавляем iSCSI target, это «точка» подключения к нашей системе хранения по iSCSI, ее увидит Initiator, обратившись к СХД по TCP/IP на порт 3260. |

8. iSCSI –> Device Extents –> Add Extent Добавляем логический объект, который дает имя созданному ранее разделу. Для тех, кто не создавал программный ZFS рейд, а использует аппаратный Raid контроллер, в меню Disk device будут видны готовые разделы отданные системе контроллером. Вообще, я рекомендую использовать именно аппаратные RAID. |

9. iSCSI -> Associated Target -> Add Extent to Target Теперь пришло время выставить соответствие между созданными ранее Target и Extent, чтобы наш Хост ESXi обратившись к FreeNAS по имени Target попал бы на нужный нам Extent.В FreeNAS 7 все было проще, но сейчас тоже есть логика, ее нужно один раз понять и настройка больше не будет вызывать проблем. |

10. Пришло время включить службу Services -> iSCSIИз-за того, что у FreeNAS не всегда с первого раза включаются службы, лучше перезагрузиться. Цель – это добиться работы тумблера FreeNAS на вкл/выкл без ошибок. Если все в порядке, то идем дальше |

11. Подключаемся к нашему ESXi хосту через vCenter или напрямую, используя vSphere Client. Переходим в меню Configurations -> Storage Adapters. Если у вас ESXi 5 то iSCSI устройства вы не увидите, его сначала нужно включить (включается здесь же, справа вверху Add). |

12. Для того, чтобы наш хост увидел LUN на FreeNAS, как на картинке ниже, нужно прописать в настройках iSCSI Software Adapter. Для этого правой кнопкой мыши кликаем по адаптеру и выбираем Properties. Находим вкладку Dynamic Discovery -> Add, добавляем IP адрес нашего FreeNAS сервера, жмем ОК. Теперь, если вы все сделали правильно, то во вкладке Static Discovery автоматически появится путь к нашему Target, который мы презентовали ранее. |

13. Теперь нужно добавить LUN в список хранилищ хоста, в процессе добавления он будет отформатирован (на выбор VMFS3 или VMFS5). Переходим в Configuration -> Storage -> Add Storage и проходим по всем пунктам мастера. Если вы пробовали настраивать NFS storage, то должны помнить, что к одному и тому же LUN могут получить доступ разные ESXi хосты, работающие без vCenter под бесплатными лицензиями. С iSCSI сделать подобного не получится, каждый бесплатный ESXi будет пытаться отформатировать LUN перед подключением.Само собой, vCenter решает эту проблему. Если денег на покупку лицензий очень мало, то можно взять самый недорогой пакет Essentials Kit (700$) и 3 хоста будут видеть общие луны. |

14.В итоге видим добавленный LUN и можем его использовать для хранения и запуска виртуальных машин. |

Подключение iSCSI хранилища в Windows Server 2016

Если вы настраиваете отказоустойчивый кластер Windows Server 2016 или вы строите кластер Hyper-V Windows Server 2016, вам понадобится общее хранилище для размещения файлов виртуальных машин, т.к. хранение данных и файлов на локальных дисках не очень хорошо с точки зрения отказоустойчивости кластера. Довольно популярным протоколом для доступа к сетевым хранилищам, который используется сегодня повсюду, является iSCSI (Internet Small Computer System), который позволяет передавать команды SCSI через обычную TCP/IP сеть и разработан для установления взаимодействия и управления системами хранения данных, серверами и клиентами. Давайте рассмотрим, как подключить общее хранилище iSCSI на Windows Server 2016.

- Как подключить iSCSI диск по сети в Windows Server 2016

- Инициализация iSCSI диска в консоли управления дисками Windows Server 2016

Содержание:

Как подключить iSCSI диск по сети в Windows Server 2016

В качестве iSCSI initiator в нашем случае будет использоваться наш сервер Windows Server 2016, а в качестве сетевого хранилища — виртуальное устройство FreeNAS, которое используется как iSCSI target. Необходимо проверить настройки брандмауэра, чтобы исключить все возможные проблемы с блокировкой портов и трафика между устройствами. Как правило, для связи, протокол iSCSI использует 860 и 3260 TCP-порты.

В Windows Server 2016 есть приложение «iSCSI initiator», открыть его можно перейдя в окно поиска и набрав «iSCSI initiator». Запустить приложение можно так же набрав iscsicpl.exe.

При первом запуске «iSCSI initiator» появится диалоговое окно с информацией о том, что служба Microsoft iSCSI не запущена. Если вы нажмете «Yes», то служба запустится и, в дальнейшем, будет запускаться автоматически.

После нажатия в диалоговом окне кнопки «Yes» запустится служба Microsoft iSCSI Initiator Service, это можно увидеть, открыв консоль управления службами (services.msc), а тип ее запуска изменился на «Automatic».

Теперь, когда у нас открыто диалоговое окно свойств iSCSI инициатора, мы можем указать IP-адрес нашего хранилища iSCSI Target. В нашем случае особых настроек для FreeNAS target не потребуется, поэтому нужно только указать его IP адрес и нажать на кнопку «Quick Connect». В результате вы автоматически подключитесь к iSCSI target.

Обратите внимание, что при нажатии кнопки «Quick Connect» можно увидеть статус подключения и target name, которая совпадает с настройками target в FreeNAS.

Затем вам нужно щелкнуть по вкладке «Volumes and Devices», чтобы настроить том iSCSI. Здесь также необходимо выбрать параметр «Auto Configure», после этого будут автоматически добавлены и настроены все доступные устройства.

Теперь можно увидеть, что iSCSI диск подключен.

Если необходимо поменять определенные параметры или значения в конфигурации подключения iSCSI, их можно настроить, перейдя на вкладку Configuration. К ним относятся учетные данные CHAP, настройки IPsec и т.д. Вы также можете формировать отчеты о подключенных объектах и устройствах, а также изменять имя инициатора на вкладке Configuration.

Инициализация iSCSI диска в консоли управления дисками Windows Server 2016

Нам осталось сделать ещё кое-что. Необходимо добавить дисковый раздел в Windows Server 2016 в консоли управления дисками (Disk Management), чтобы этот раздел мог использоваться в системе . Обратите внимание, что после повторного сканирования подключенных устройств хранения появился ещё один диск (с индексом Disk1). Изначально после добавления он находится в статусе «Offline».

Щелкните правой кнопкой мыши по новому тому с неразмеченной областью) и выберите пункт меню «Online». После этого диск станет активным.

Затем нам нужно инициализировать диск. Для этого снова щелкните правой кнопкой мыши и выберите пункт «Initialize Disk».

Далее в появившемся окне «Initialize disk» нужно выбрать таблицу разделов, MBR или GPT. Если вам нужна поддержка больших дисков (более 2 Тб), выберите пункт GPT.

Итак, мы добавили новый диск, который был отформатирован и теперь готов к работе.

Процесс добавления общего хранилища iSCSI в Windows Server 2016 очень прост. После того, как было организовано соединение между initiator и iSCSI- target, нам необходимо выполнить определенные настройки в графическом интерфейсе. Затем, нам остается добавить новый том в консоли управления дисками (Disk management) в Windows, после чего сетевое дисковое хранилище можно использовать.

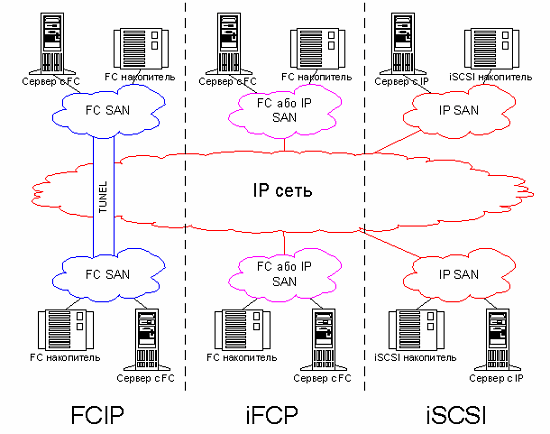

Что такое iSCSI SAN и как это работает

iSCSI, сокращенно от Internet Small Computer System Interface, является транспортным протоколом SCSI (Small Computer System Interface) для отображения блочно-ориентированных данных хранения в сетях TCP / IP. Он обеспечивает универсальный доступ к устройствам хранения и сетям хранения данных (SAN) по стандартным сетям TCP / IP. В этом посте подробно рассказывается об iSCSI SAN и о том, как она работает.

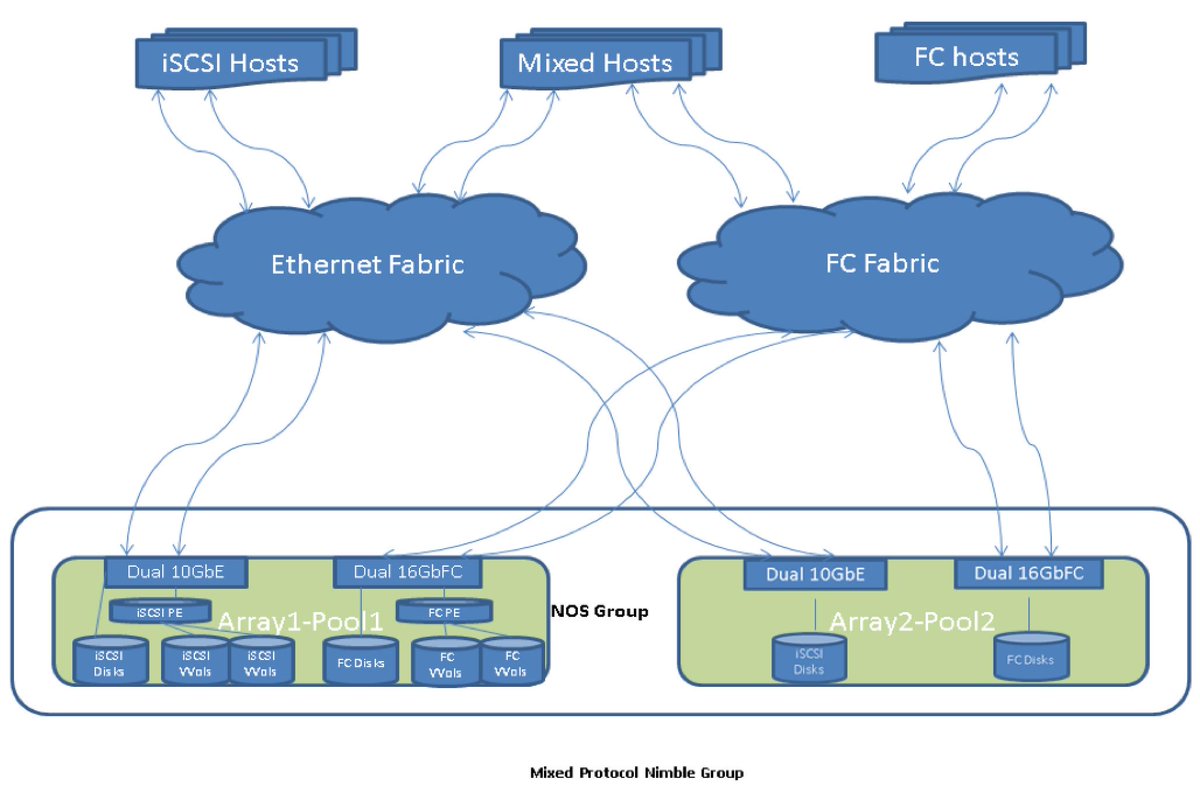

Fibre Channel против iSCSI против FCoE SAN

Поскольку iSCSI SAN часто сравнивают с Fibre Channel и FCoE, в этой части основное внимание будет уделено Fibre Channel, iSCSI и FCoE SAN.

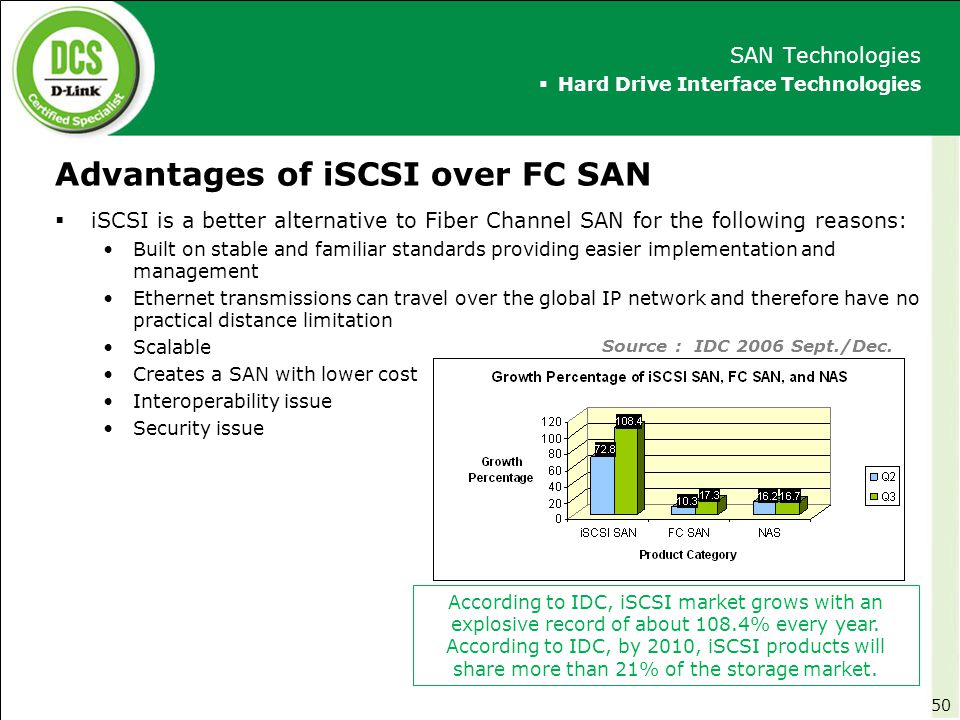

Fibre Channel в сравнении с iSCSI SAN

iSCSI и Fibre Channel предназначены для сетей хранения данных, которые соответственно называются iSCSI SAN и FC SAN. Благодаря высокой производительности и надежности Fibre Channel уже давно считается стандартной технологией для корпоративных приложений SAN. Однако FC SAN дороги и сложны в управлении и внедрении. Таким образом, iSCSI SAN становится все более популярной альтернативой Fibre Channel SAN, поскольку обеспечивает высокую производительность для компаний, работающих с небольшими бюджетами.Кроме того, iSCSI SAN использует традиционные сетевые компоненты Ethernet (такие как Ethernet-коммутаторы, серверы и т. Д.) Для связи между хостами и устройствами хранения, что значительно удешевляет внедрение. Тогда вы можете спросить: iSCSI или Fibre Channel SAN, какую из них выбрать? Все зависит от ваших потребностей. FC SAN, как правило, работают быстрее с меньшими задержками / более высокими IOPS (операции ввода / вывода в секунду). В то время как iSCSI SAN проще и дешевле.

FCoE против iSCSI SAN

И iSCSI, и FCoE — это стандарты сетей хранения на основе IP.Но у каждого есть свои особенности. FCoE — это сокращение от Fibre Channel over Ethernet, который является новым отраслевым стандартом. Это позволяет инкапсулировать кадры Fibre Channel в сетях Ethernet. В то время как iSCSI является более зрелой технологией для обеспечения блочного доступа к устройствам хранения путем передачи команд SCSI по стандартному TCP / IP Ethernet. Кроме того, iSCSI SAN относительно прост в настройке и устранении неполадок, и он может работать в любой IP-сети. Для FCoE SAN требуются мосты для центров обработки данных и адаптеры конвергентной сети, работающие со скоростью 10 Гбит / с или быстрее.Из-за более высокой стоимости он теперь обычно используется в приложениях, где есть оборудование, программное обеспечение и опыт Fibre Channel.

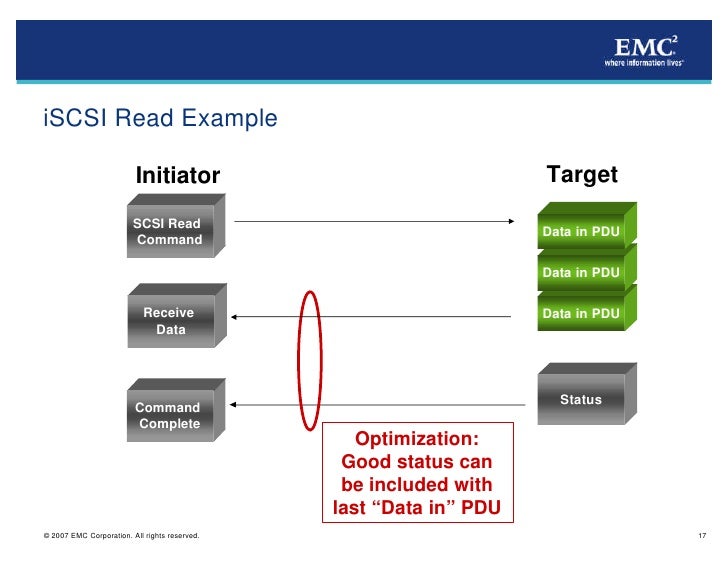

Как работает iSCSI SAN?

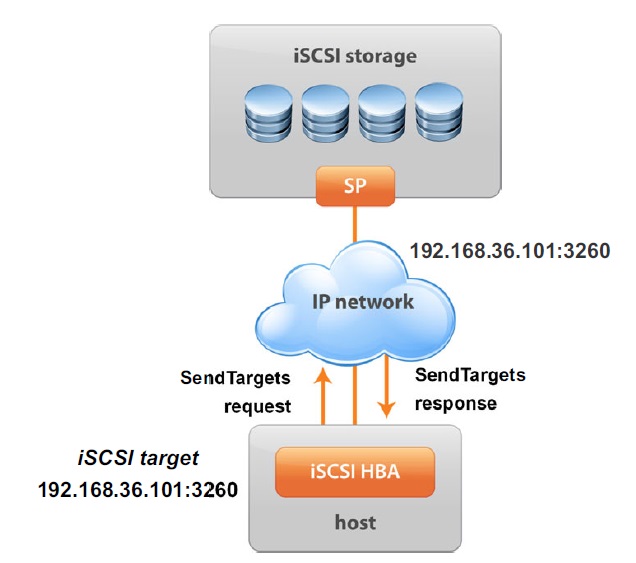

Обычно iSCSI SAN использует обычную IP-сеть для передачи данных на уровне блоков между инициатором iSCSI на сервере и целью iSCSI на устройстве хранения. Вот как это работает:

1. Приложение или пользователь хочет получить доступ к данным или файлу с сервера;

2.Сервер с инициатором преобразует команды SCSI в команду iSCSI, которая затем отправляется в IP SAN с помощью соединения точка-точка;

3. После получения пакета принимающая сторона разбирает и обрабатывает пакет;

4. Цель преобразует эти IP-пакеты в команды SCSI и отправляет их в хранилище. Безопасность обеспечивается посредством проверки подлинности iSCSI и виртуальных частных сетей (VPN), если это необходимо.

Примечание : Инициатор — это тот, кто запрашивает данные для чтения или записи в хранилище.А цель отвечает за обработку команд от инициатора.

Заключение

Подводя итог, iSCSI предлагает компаниям ряд преимуществ, таких как гибкость, низкая стоимость и упрощенное управление. И iSCSI SAN — идеальный выбор для пользователей, которые заинтересованы в переходе на сетевое хранилище.

ОбзорiSCSI SAN — видеоурок

В этом руководстве по хранилищам SAN и NAS я рассмотрю протокол SAN iSCSI (Internet Small Computer System Interface).iSCSI работает в сетях Ethernet и изначально был разработан как менее дорогая альтернатива Fibre Channel.

Он имеет более высокие накладные расходы на пакеты и традиционно считается имеющим более низкую надежность и производительность, чем Fibre Channel. Прокрутите вниз до видео, а также текстового руководства.

Хотите пройти полный курс? Щелкните здесь, чтобы получить бесплатный курс «Введение в SAN и NAS Storage»

ОбзорiSCSI SAN — видеоурок

Я рекомендую вам сначала ознакомиться с моей серией обзоров Fibre Channel, чтобы получить хорошее представление об общих основах SAN, прежде чем переходить к iSCSI.Серия из трех видеороликов доступна здесь:

Часть первая — Адресация FCP и WWPN

Часть вторая — Зонирование, маскировка LUN и вход в матрицу

Часть третья — Резервирование и многолучевость

ТрафикiSCSI может проходить через традиционные карты сетевого интерфейса Ethernet (NIC) или карты TCP Offload Engine (TOE) на наших хостах. Карты TOE — это специализированные сетевые адаптеры, которые разгружают обработку TCP / IP хранилища с центрального процессора сервера. Они также известны как адаптеры шины хоста iSCSI (HBA).

Что такое iSCSI?iSCSI — это протокол транспортного уровня, работающий через TCP / IP. Этот стандарт сети хранения на основе IP позволяет передавать данные на уровне блоков на хосты с помощью протокола SCSI.

iSCSI связывает средства хранения данных и обеспечивает TCP восстановление после потери пакетов. Он также поддерживает шифрование и дешифрование сетевых пакетов.

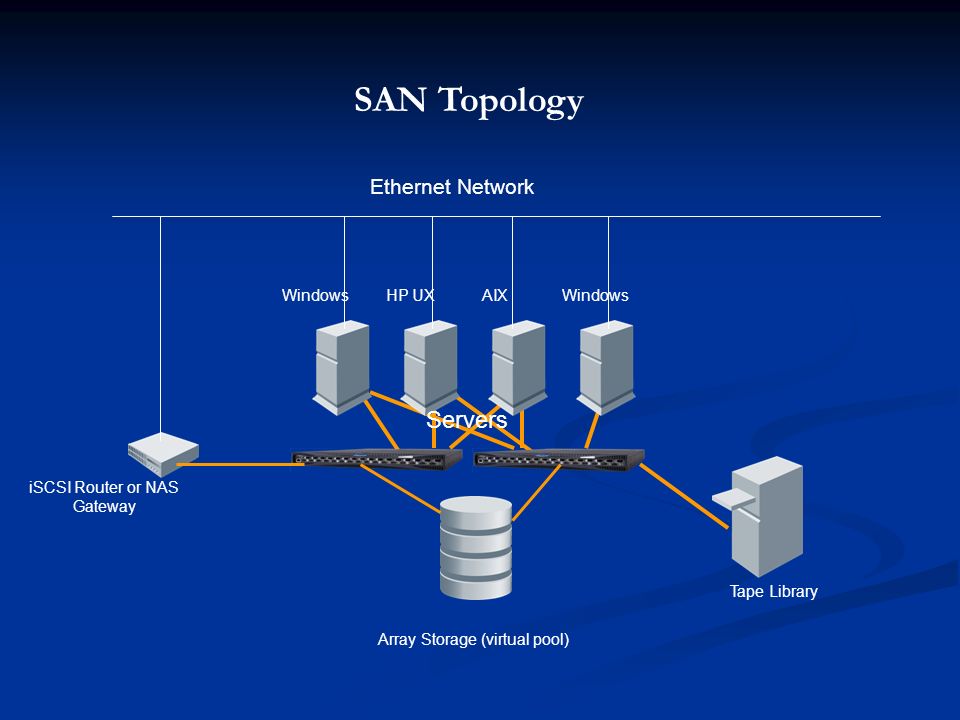

Сети iSCSI

iSCSI может совместно использовать существующую сеть передачи данных Ethernet или иметь собственную выделенную сетевую инфраструктуру.

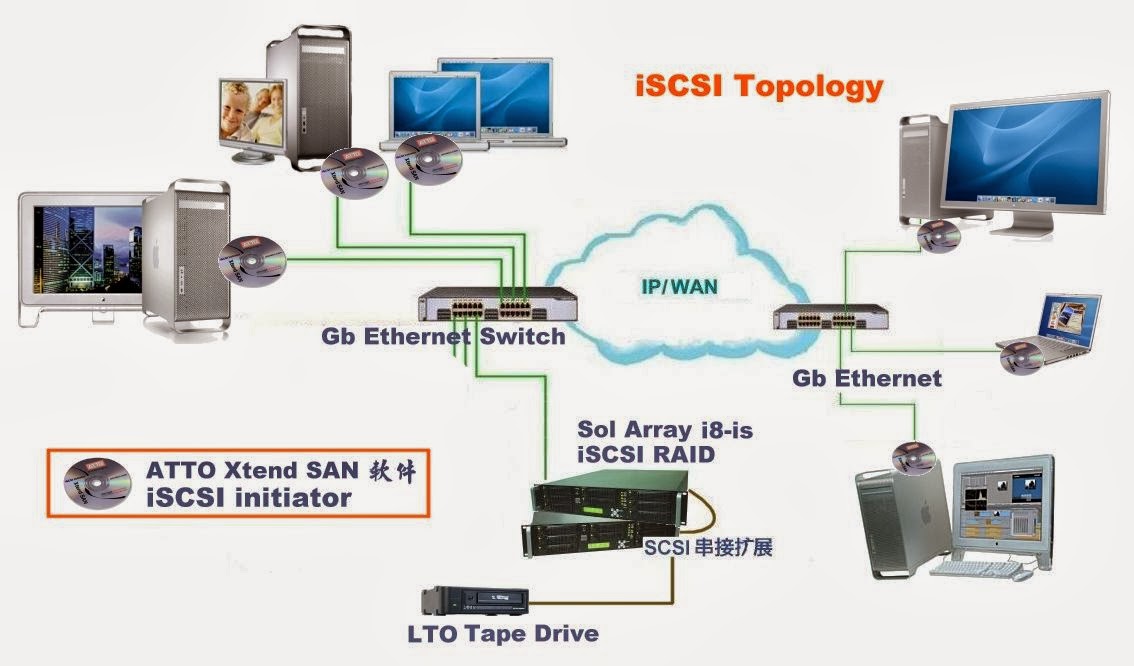

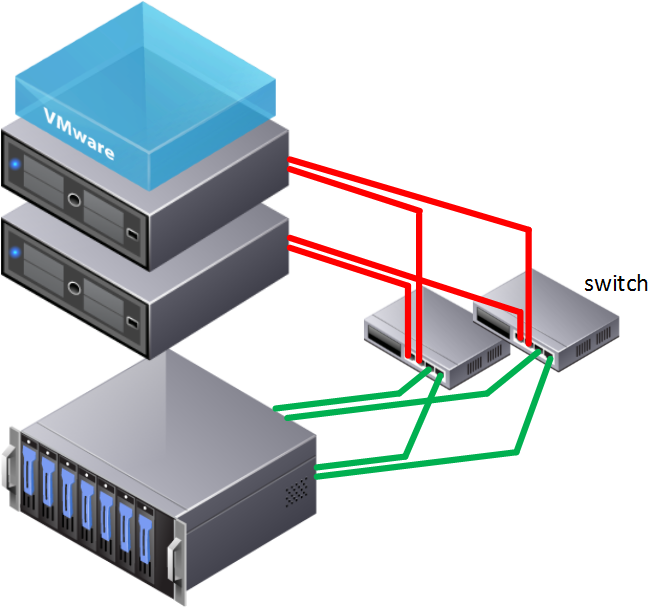

На схеме ниже показан пример выделенной сетевой инфраструктуры для трафика хранилища iSCSI.

Выделенная сеть iSCSI

У нас есть веб-сервер «Сервер 1» в середине диаграммы и клиент вверху, который хочет открыть веб-страницу, размещенную на Сервере 1. Клиент отправляет свой HTTP-запрос Серверу 1 через наш стандартная локальная сеть вверху.

Server 1 затем загружает веб-страницу из своего хранилища iSCSI внизу, используя отдельную выделенную сеть Ethernet, которая используется только для хранения.

Сервер 1 имеет резервные сетевые подключения. У него есть две сетевые карты Ethernet, подключенные к сети передачи данных вверху, обращенные к клиенту, и пара сетевых адаптеров или карт TOE, подключенных к сети хранения данных внизу.

На следующей диаграмме ниже у нас есть общая сетевая инфраструктура для обоих серверов для хранения и трафика между серверами и клиентами. Наши обычные данные и трафик нашего хранилища проходят через одни и те же коммутаторы и могут использовать одни и те же сетевые карты на наших конечных хостах.

Общая сеть iSCSI SAN

Если вы попытались сделать это в те времена, когда у нас был только 1 Gigabit Ethernet, у вас могли бы возникнуть проблемы, но теперь это более осуществимо, когда у нас есть 10 Gigabit Ethernet и даже более высокие скорости.

Если мы используем общую инфраструктуру, лучше всего разделить наши данные и трафик хранилища по разным VLAN для повышения производительности и безопасности.

iSCSI SAN с виртуальными локальными сетями

На сервере мы могли бы иметь два разных физических порта для трафика данных и хранилища, или мы могли бы объединить обе VLAN в одну и ту же физическую часть.

Чтобы коммутатор мог переключать трафик, нам необходимо соблюдать физически отдельную передовую практику «Fabric A / Fabric B» для трафика хранилища. Коммутаторы, вероятно, будут перекрестно подключены для трафика данных. По этой причине у нас будут отдельные порты для трафика данных и хранилища, а также для повышения производительности и безопасности.

Обратите внимание, что у нас здесь половина инфраструктуры по сравнению с тем, когда мы использовали выделенную сеть хранения. В выделенной сети хранения у нас было 4 сетевых порта на сервере и 4 кабеля, которые были подключены к 4 коммутаторам.

С общей инфраструктурой у нас есть 2 сетевых порта, 2 кабеля и 2 коммутатора. Наличие выделенной инфраструктуры увеличивает затраты на оборудование и требует больше места, питания и охлаждения, но может дать нам большую надежность и более простую конфигурацию VLAN.

Основные компоненты iSCSI

Инициатор iSCSI может быть аппаратным устройством или программным обеспечением, находящимся на главном компьютере в сети хранения данных, который обрабатывает обмен данными по IP-сети.Инициатор подключается к цели iSCSI и передает команды iSCSI в виде пакетов данных.

iSCSI target — это удаленное запоминающее устройство, которое отображается на хосте как локальный диск. Когда цель iSCSI получает пакеты данных от инициатора iSCSI, команды iSCSI представляются, а затем разбираются в ОС. Если пакеты данных зашифрованы на уровне инициатора, они расшифровываются на целевом уровне.

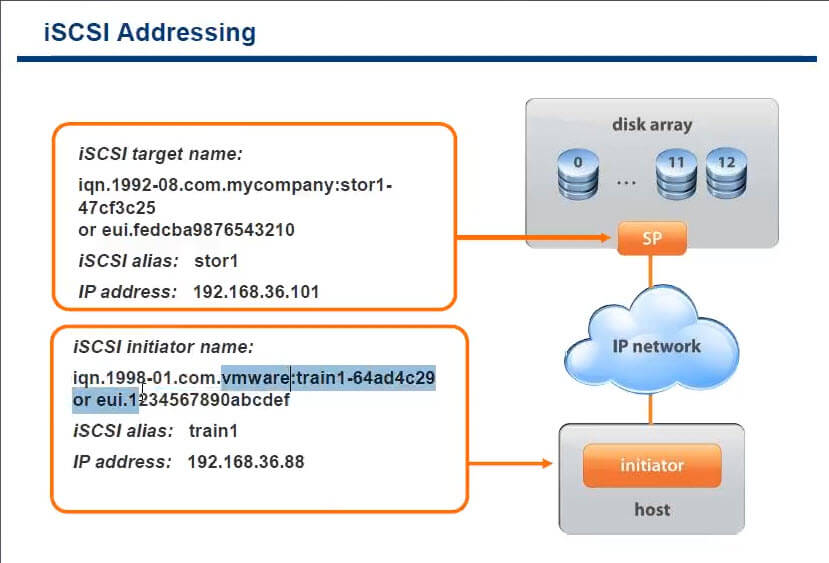

Адресация iSCSI

К обращению сейчас.Fibre Channel использует всемирные имена для идентификации инициаторов и целей. iSCSI использует полные имена iSCSI (IQN) или, реже, может использовать расширенный уникальный идентификатор (EUI). IQN может содержать до 255 символов и имеет формат:

.iqn.yyyy-mm.naming-author: уникальное имя

Например, IQN может быть iqn.1991-05.com.microsoft:testHost. Не волнуйтесь, если увидите в IQN действительно старую дату. IQN определяется тем, когда поставщик подал заявку на получение адресов IQN, поэтому обычно это старая дата.IQN назначается хосту в целом аналогично тому, как WWNN применяется в Fibre Channel.

iSCSI работает через Ethernet, поэтому отдельные порты адресуются IP-адресами, а не WWPN, как в Fibre Channel. iSCSI не поддерживает процессы входа в систему Fibre Channel FLOGI, PLOGI и PLRI.

Следовательно, администратор должен явно указать инициатору на его цель, указав один из IP-адресов в целевой группе портала.Затем он обнаружит IQN цели и другие порты в TPG.

Программное обеспечениеMultipathing на инициаторе может выбрать путь или пути к цели. Использование нескольких путей в iSCSI работает так же, как использование нескольких путей в Fibre Channel. Несмотря на то, что он работает через Ethernet, iSCSI по-прежнему является протоколом SAN с интеллектуальным управлением множественными путями на инициаторе.

LUN Masking также настраивается так же, как и в Fibre Channel, но с использованием IQN, а не WWPN для идентификации клиента.Зонирование не поддерживается в iSCSI на наших коммутаторах.

Аутентификация на основе пароля обычно настраивается на инициаторе и цели для защиты от атак с подделкой, а также может быть включено сквозное шифрование IPSec, если вам нужно дополнительно повысить безопасность.

Каковы преимущества iSCSI SAN?iSCSI Storage или SAN — экономичная замена при переходе на сетевое хранилище. Кроме того, iSCSI SAN может быть построен в существующей сети, и он также дает несколько преимуществ, таких как:

- Быстрая и эффективная передача данных, так как она основана на блоках.

- Гибкость и высокая производительность.

- Упрощенная среда и управление сетевым хранилищем.

- Большинство сетевых запоминающих устройств совместимы с iSCSI.

Посмотрите видео, чтобы увидеть практическую демонстрацию подключения к LUN от инициатора Windows iSCSI.

Дополнительные ресурсы

RFC 3720 — Интерфейс малых компьютерных систем Интернета

Википедия — iSCSI

TechTarget — iSCSI Essentials

Бесплатный учебный курс «Введение в SAN и NAS Storage»Видео представляет собой отрывок из моего курса «Введение в SAN и NAS Storage».Вы можете получить всю серию бесплатно здесь:

https://www.flackbox.com/introduction-to-san-and-nas-storageКогда вы будете готовы вывести свои знания о хранении данных на новый уровень, вы можете пройти мой учебный курс

«NetApp ONTAP 9 Storage Complete».Страница не найдена

ДокументыМоя библиотека

раз- Моя библиотека

Что такое iSCSI? | SNIA

Словарь SNIA определяет интерфейс малых компьютерных систем Интернета (iSCSI) как транспортный протокол, который обеспечивает передачу протокола SCSI по IP-сети на основе TCP, стандартизованный инженерной группой Интернета и описанный в RFC 3720.

iSCSI — это блочный протокол для сетей хранения данных, который запускает очень распространенный протокол хранения SCSI через сетевое соединение, которым обычно является Ethernet.

iSCSI, как и Fibre Channel, можно использовать для создания сети хранения данных (SAN). Трафик iSCSI может передаваться через общую сеть или выделенную сеть хранения. Однако iSCSI не поддерживает файловый доступ к сетевым хранилищам (NAS) или доступ к хранилищам объектов (они используют разные транспортные протоколы).

Для iSCSI можно использовать несколько транспортов.Наиболее распространенным является TCP / IP через Ethernet, но удаленный прямой доступ к памяти (RDMA) также можно использовать с iSER, который является расширениями iSCSI для RDMA. При использовании iSER транспортным средством является RoCE или InfiniBand, а базовой сетью является Ethernet (для RoCE) или InfiniBand (для транспорта InfiniBand).

iSCSI предлагает хорошую производительность блочного хранилища при низкой стоимости. Он также широко поддерживается всеми основными операционными системами и гипервизорами и может работать на стандартных сетевых картах или специализированных адаптерах главной шины (HBA).Он также поддерживается почти всеми корпоративными массивами хранения. По этим причинам он был популярен для приложений так называемого уровня 2, которым требуется хорошая, но не лучшая производительность блочного хранилища, а также для хранилища, которое совместно используется многими хостами. Он также очень популярен среди гипермасштабируемых компаний и крупных поставщиков облачных услуг, когда им требуется решение для блочного хранилища, работающее через Ethernet.

iSCSI также можно ускорить с помощью сетевых адаптеров с аппаратной разгрузкой iSCSI и / или TCP Offload Engine (TOE).В первом случае аппаратный адаптер (или HBA) разгружает функцию инициатора iSCSI с ЦП сервера. В последнем случае адаптер разгружает обработку TCP с ядра сервера и процессора.

Быстрый рост более высоких скоростей Ethernet, таких как 25G, 50G и 100G, наряду с увеличением поддержки управления перегрузками и качества обслуживания трафика (QoS) на коммутаторах Ethernet, значительно улучшил потенциальную производительность, надежность и предсказуемость iSCSI как хранилища. протокол.

Узнайте больше об iSCSI в нашей образовательной библиотеке

Подробнее о фундаментальных темах сетей хранения данных:

Создание iSCSI SAN | Computerworld

За последние несколько лет приложения, требовательные к хранению данных, такие как электронная коммерция, хранилища данных и онлайн-мультимедиа, предъявили огромные требования к вычислительной инфраструктуре не только с точки зрения пропускной способности сети, но и все более и более с точки зрения емкости хранения.Более того, тенденция к консолидации и развертыванию модульных серверных возможностей, монтируемых в стойку, вытеснила хранилище за пределы сервера.

Эти факторы, наряду с необходимостью для ИТ-менеджеров эффективно управлять огромными объемами хранения, создали потребность в надежном, масштабируемом и управляемом решении внешнего хранения. Сеть хранения данных (SAN) была разработана для удовлетворения этих потребностей. SAN предлагает ИТ-менеджерам возможность перемещать хранилище в сеть, предназначенную для хранилища, где его можно консолидировать и управлять с помощью инструментов и процессов, специально разработанных для этой цели.

На рисунке 1 показана базовая реализация SAN, не зависящая от протокола.

Полезно думать о SAN как о двух основных разновидностях, основанных на транспортном протоколе, используемом в самой SAN. Изначально была Fibre Channel SAN, а позже появилась Internet SCSI (iSCSI) SAN. Оба типа сетей хранения данных предоставляют многие из одинаковых преимуществ:

- Более эффективное использование хранилища: Благодаря консолидации хранилищ становится меньше серверов с неиспользуемой емкостью и меньше серверов с полной емкостью.Вместо этого серверы совместно используют пул хранения.