Добавить iSCSI диск на сервер Windows Hyper-v или Core server

Я довольно часто использую бесплатный гипервизор hyper-v от Microsoft. Бесплатная редакция основана на core версии сервера. Это доставляет некоторые неудобства в решении стандартных задач, о которых даже не задумываешься во время работы на полноценной версии сервера с графическим интерфейсом. Одной из таких задач было добавление диска через iSCSI.

Если у вас есть желание научиться строить и поддерживать высокодоступные и надежные системы, рекомендую познакомиться с онлайн-курсом «Специализация Administrator Linux» в OTUS. Курс для новичков из двух ступеней — Junior и Middle. Полная программа курса по .

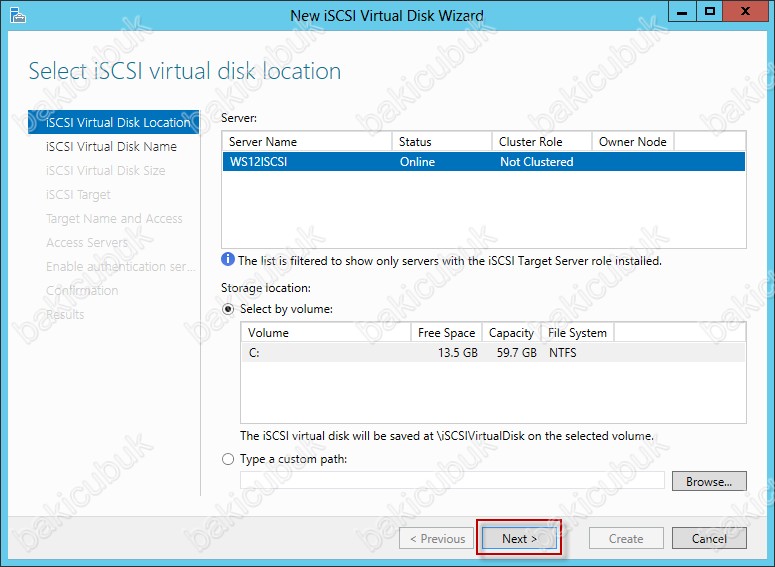

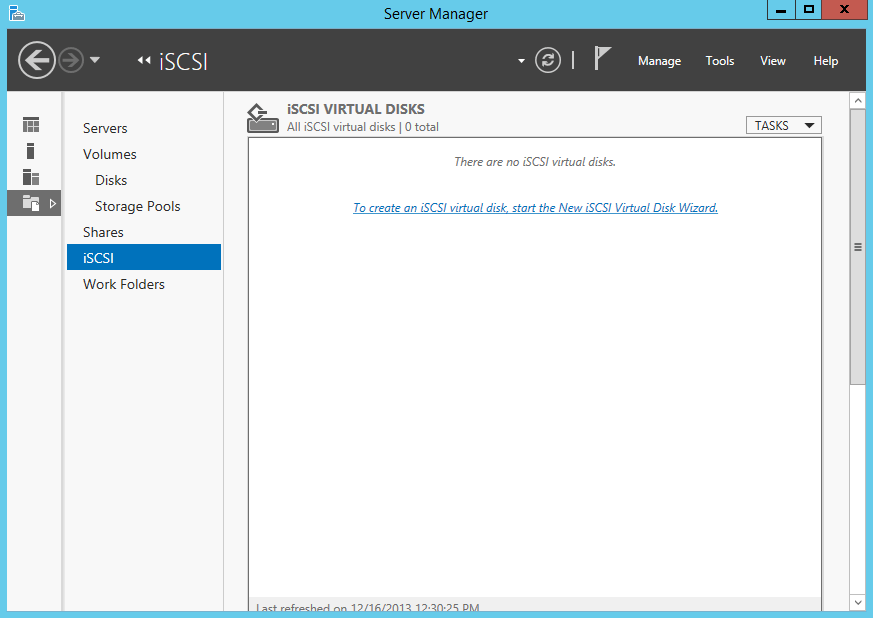

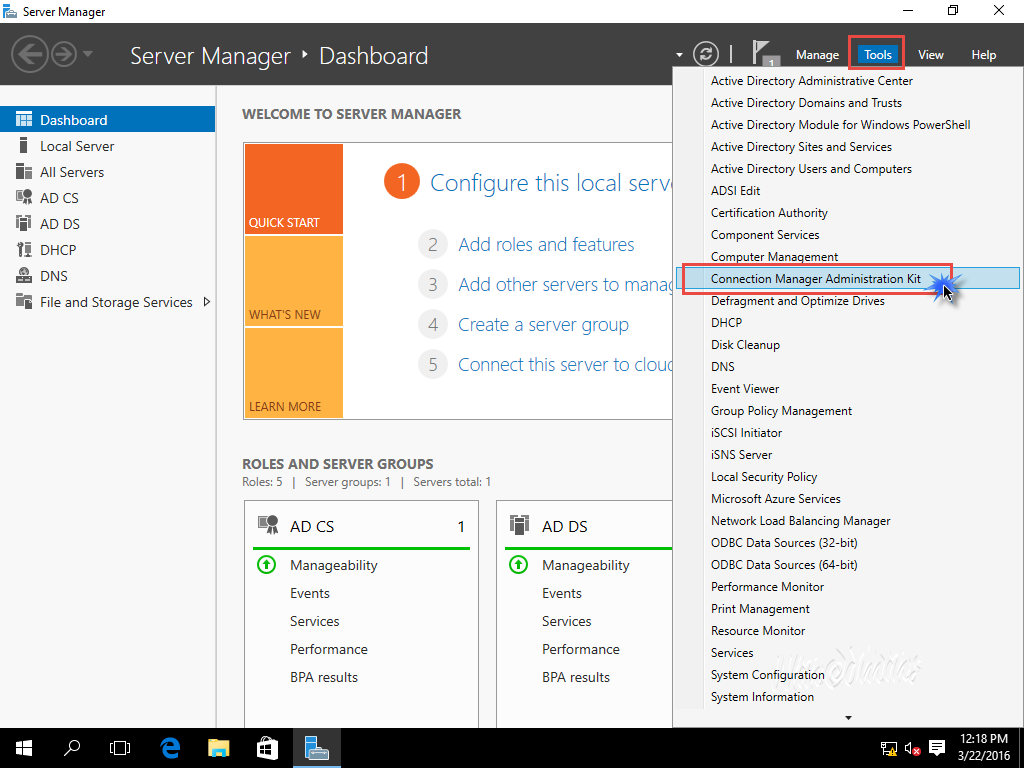

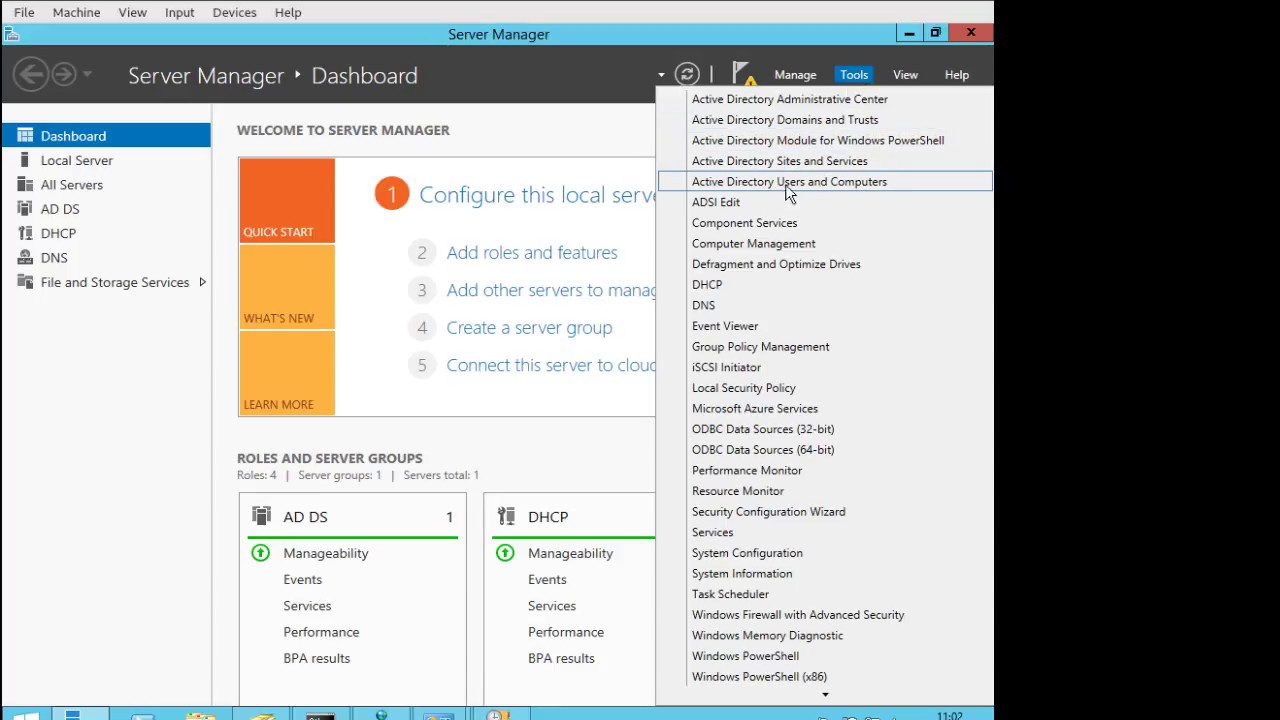

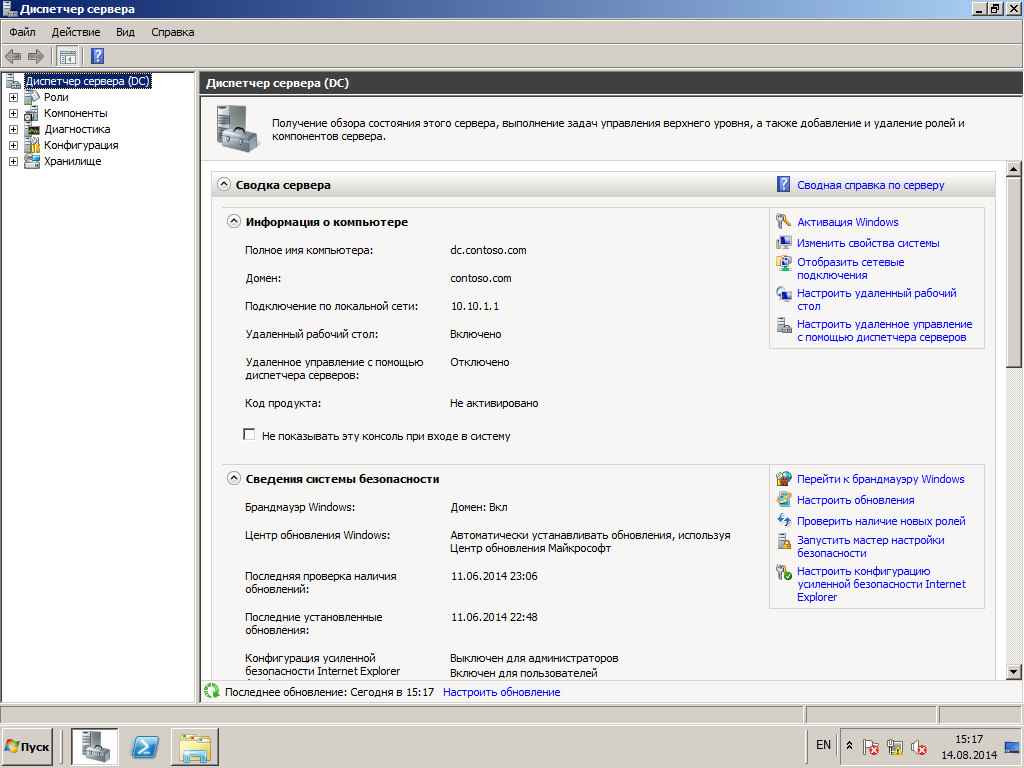

В стандартной версии сервера с GUI это делается просто через панель управления. Там есть отдельный раздел для этого.

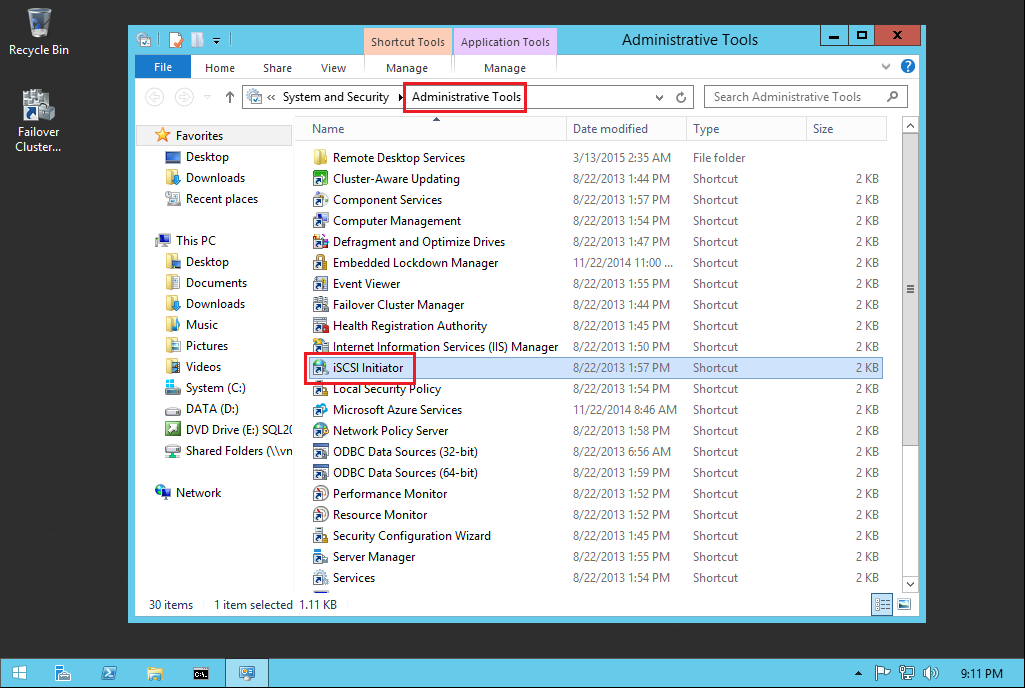

Есть еще в разделе администрирования оснастка для этих же целей. А что делать, если у вас нет GUI? Решение есть и достаточно простое.

Первым делом нам надо запустить службу Microsoft iSCSI Initiator Service и установить тип запуска «Автоматически»

Делается это с машины, на которой настроены оснастки управления Hyper-V. Подробнее об этом читайте в статьях:

Принцип настройки один и тот же в обоих случаях. После этого подключаемся к гипервизору по rdp и запускаем в командной строке:

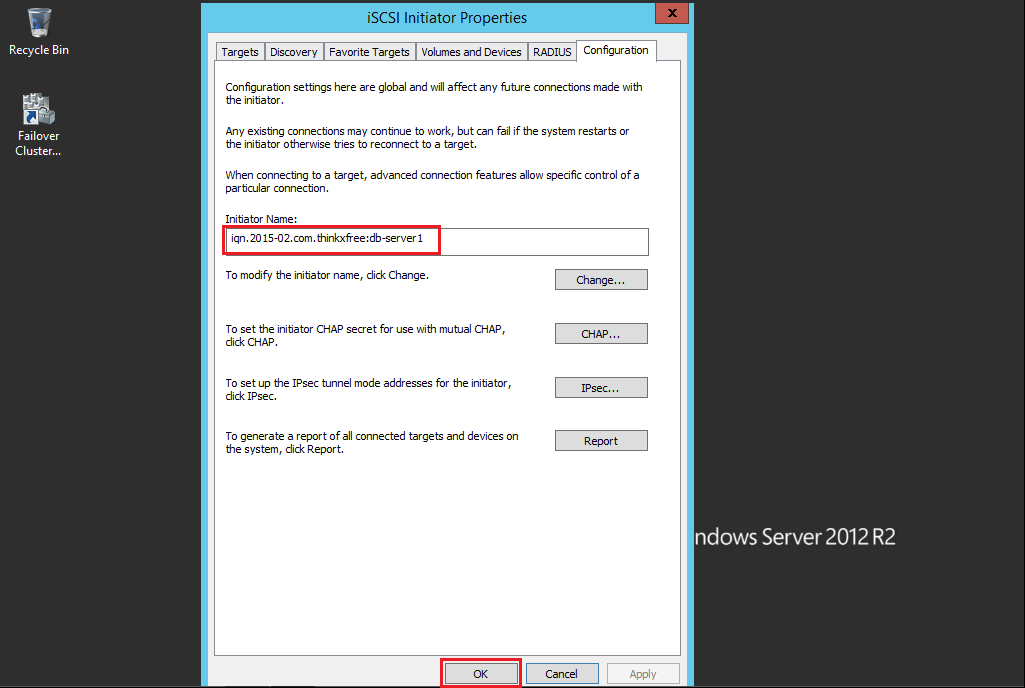

iscsicpl

Откроется оснастка управления iSCSI Initiator.

Дальше стандартным образом подключаете источник и работаете с ним. Чтобы инициализировать подключенный диск, необходимо использовать оснастку управления дисками. Запускаете ее с того же компьютера, на котором стоят оснастки управления Hyper-V.

Онлайн курс «DevOps практики и инструменты»

Если у вас есть желание научиться строить и поддерживать высокодоступные и надежные системы, научиться непрерывной поставке ПО, мониторингу и логированию web приложений, рекомендую познакомиться с онлайн-курсом «DevOps практики и инструменты» в OTUS. Курс не для новичков, для поступления нужны базовые знания по сетям и установке Linux на виртуалку. Обучение длится 5 месяцев, после чего успешные выпускники курса смогут пройти собеседования у партнеров. Проверьте себя на вступительном тесте и смотрите программу детальнее по .

Курс не для новичков, для поступления нужны базовые знания по сетям и установке Linux на виртуалку. Обучение длится 5 месяцев, после чего успешные выпускники курса смогут пройти собеседования у партнеров. Проверьте себя на вступительном тесте и смотрите программу детальнее по .Помогла статья? Подписывайся на telegram канал автора

Анонсы всех статей, плюс много другой полезной и интересной информации, которая не попадает на сайт.Как установить ISCSI сервер в Windows Server 2008 R2, для настройки iSCSI-хранилища

Как установить ISCSI сервер в Windows Server 2008 R2-01

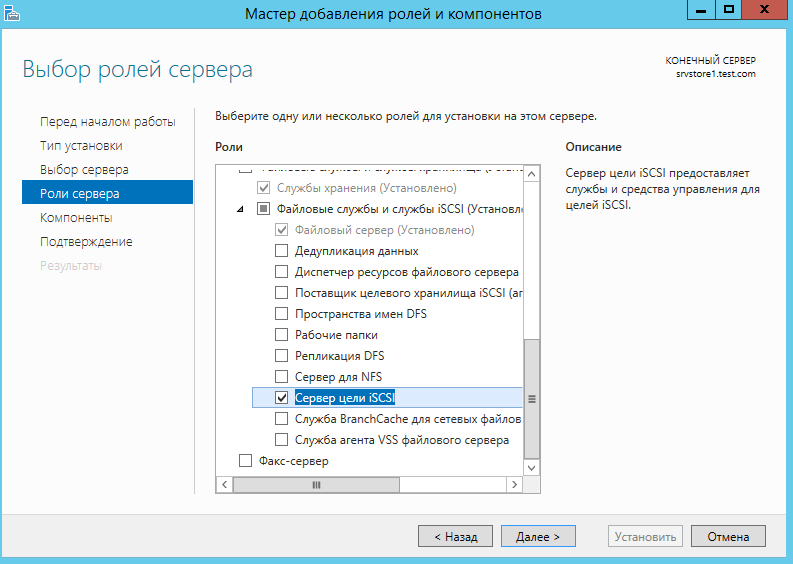

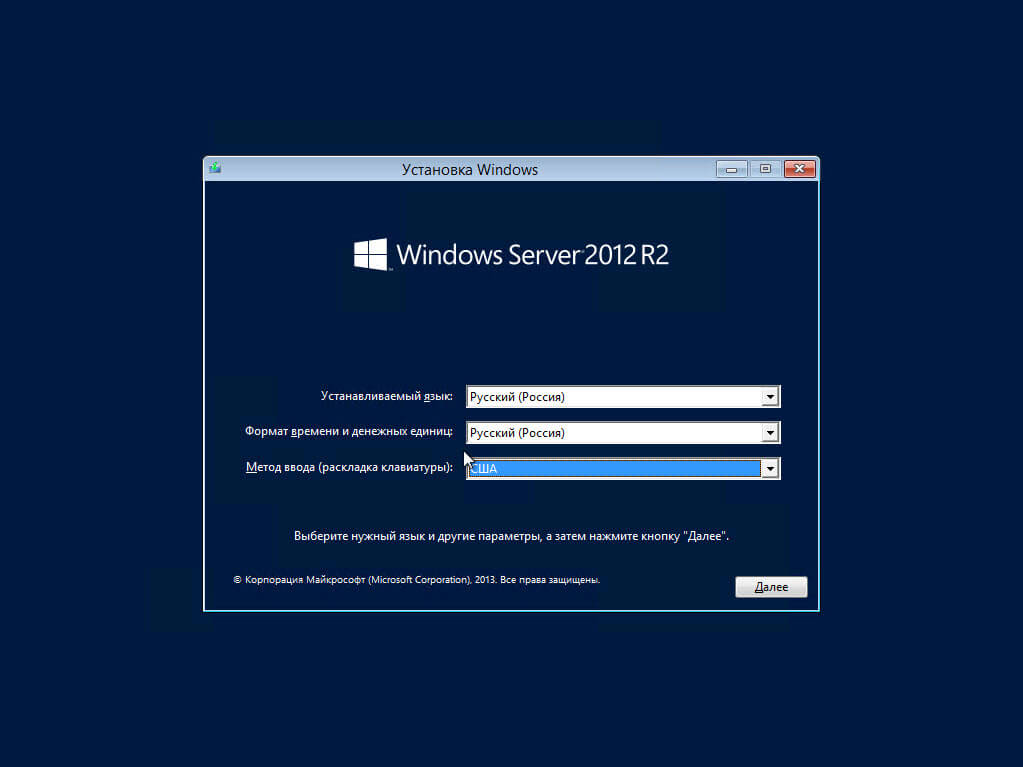

Всем привет сегодня расскажу как установить ISCSI сервер в Windows Server 2008 R2. По умолчанию данная служба не идет в комплекте Windows Server 2008 R2 и скачивается отдельно как компонент. Сам ISCSI сервер, состоит из iscsi target windows, который будет выступать в роли цели к кому будет подключаться встроенный компонент Windows инициатор iscsi, и с помощью них будет производиться настройка iSCSI-хранилища.

Напомню что такое ISCSI протокол (англ. Internet Small Computer System Interface) — протокол, который базируется на TCP/IP и разработан для установления взаимодействия и управления системами хранения данных, серверами и клиентами. iSCSI описывает: Транспортный протокол для SCSI, который работает поверх TCP. Благодаря ему вы можете создать дисковое хранилище средствами Windows и подключить его через вашу локальную сеть ethernet, скорость конечно будет зависеть больше от вашего сетевого парка, но вам не придется тратиться на дорогостоящие FC свитчи, а если у вас есть 10 и более гигабитные ISCSI свитчи то вообще все будет шикарно, так как они уже мало чем проигрывают FC, плюс их проще внедрять в существующую инфраструктуру.

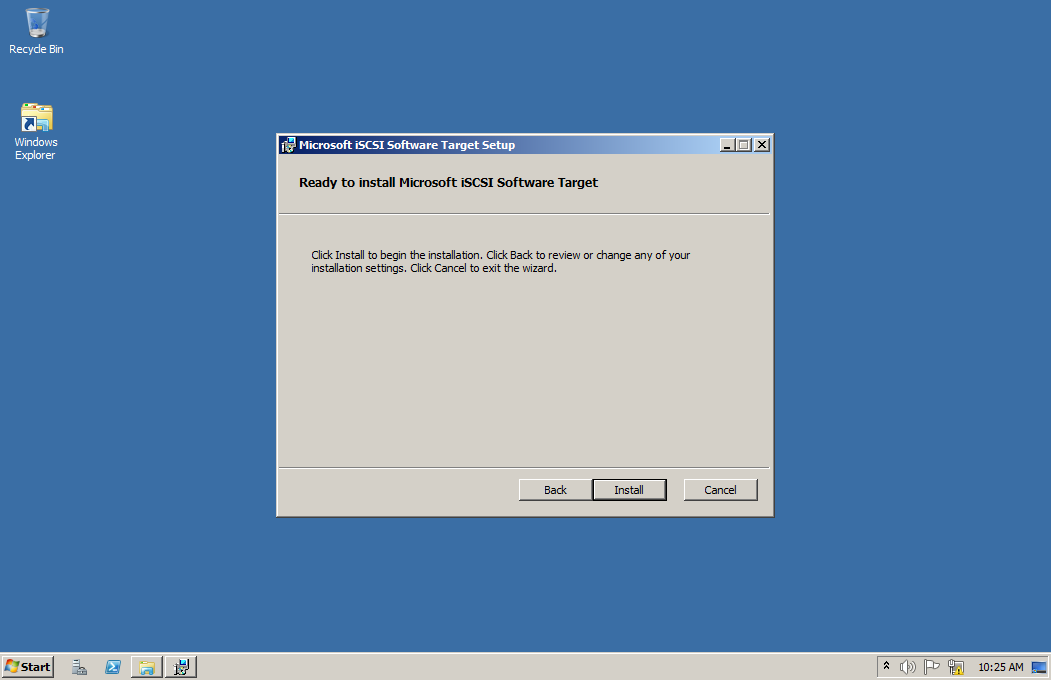

Для того чтобы наш iscsi сервер работал скачаем Microsoft iSCSI Software Target 3.3. Запускаем скачанный дистрибутив

Как установить ISCSI сервер в Windows Server 2008 R2, для настройки iSCSI-хранилища-01

Через browse указываем куда хотим выгрузить установочный файл

Как установить ISCSI сервер в Windows Server 2008 R2, для настройки iSCSI-хранилища-02

видим Microsoft iSCSI Software Target 3. 3 успешно извлечен.

3 успешно извлечен.

Как установить ISCSI сервер в Windows Server 2008 R2, для настройки iSCSI-хранилища-03

Переходим в директорию в которую извлекались файлы, нас будет интересовать папка x64, запускаем iscsitaget_public

Как установить ISCSI сервер в Windows Server 2008 R2, для настройки iSCSI-хранилища-04

откроется мастер установки жмем сразу next.

Как установить ISCSI сервер в Windows Server 2008 R2, для настройки iSCSI-хранилища-05

Соглашаемся с лицензионным соглашением

Как установить ISCSI сервер в Windows Server 2008 R2, для настройки iSCSI-хранилища-06

при желании можно изменить каталог установки

Как установить ISCSI сервер в Windows Server 2008 R2, для настройки iSCSI-хранилища-07

next

Как установить ISCSI сервер в Windows Server 2008 R2, для настройки iSCSI-хранилища-08

Install

Как установить ISCSI сервер в Windows Server 2008 R2, для настройки iSCSI-хранилища-09

начнется установка

Как установить ISCSI сервер в Windows Server 2008 R2, для настройки iSCSI-хранилища-10

Finish.

Как установить ISCSI сервер в Windows Server 2008 R2, для настройки iSCSI-хранилища-11

Теперь откроем Пуск-Администрирование и видим новую оснастку Программная цель ISCSI (Micrsoft)

Как установить ISCSI сервер в Windows Server 2008 R2, для настройки iSCSI-хранилища-12

Читайте далее Как создать ISCSI диск в Windows Server 2008 R2, для подключения его к ESXI 5.5.

Вот так вот просто установить ISCSI сервер в Windows Server 2008 R2, для настройки iSCSI-хранилища.

Материал сайта pyatilistnik.org

Подключение СХД Qsan к серверам в среде Windows Server и Hyper-V / Блог компании Skilline / Хабр

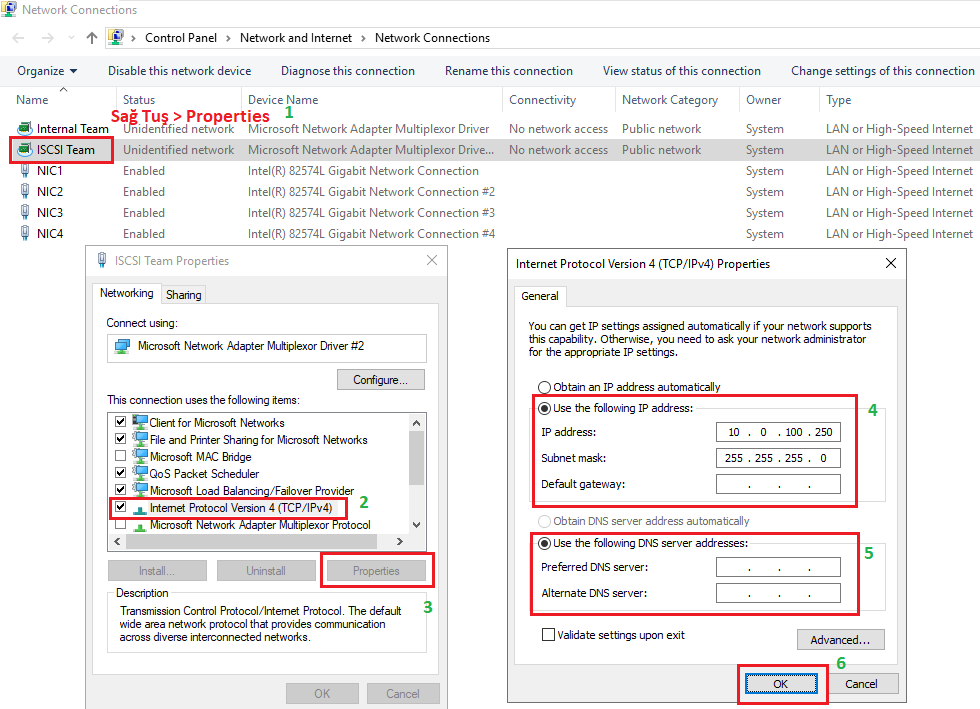

Мы продолжаем цикл публикаций из серии How To для пользователей СХД Qsan. В данной статье пойдет речь о подключении СХД к серверам на базе Windows Server, в том числе при использовании функционала виртуализации Hyper-V.

В статье мы будем рассматривать подключения СХД Qsan с использованием блочных протоколов доступа iSCSI и Fibre Channel. Сам процесс подключения можно разделить на несколько основных этапов:

- Физическая и логическая коммутация

- Действия на стороне СХД

- Действия на стороне хоста(ов)

В статье приведены скриншоты настройки операционной системы Windows Server 2016/2019 с нелокализованным интерфейсом. Часть описания, не относящаяся напрямую к ОС, взята из нашего предыдущего обзора по настройке ESXi.

Часть описания, не относящаяся напрямую к ОС, взята из нашего предыдущего обзора по настройке ESXi.

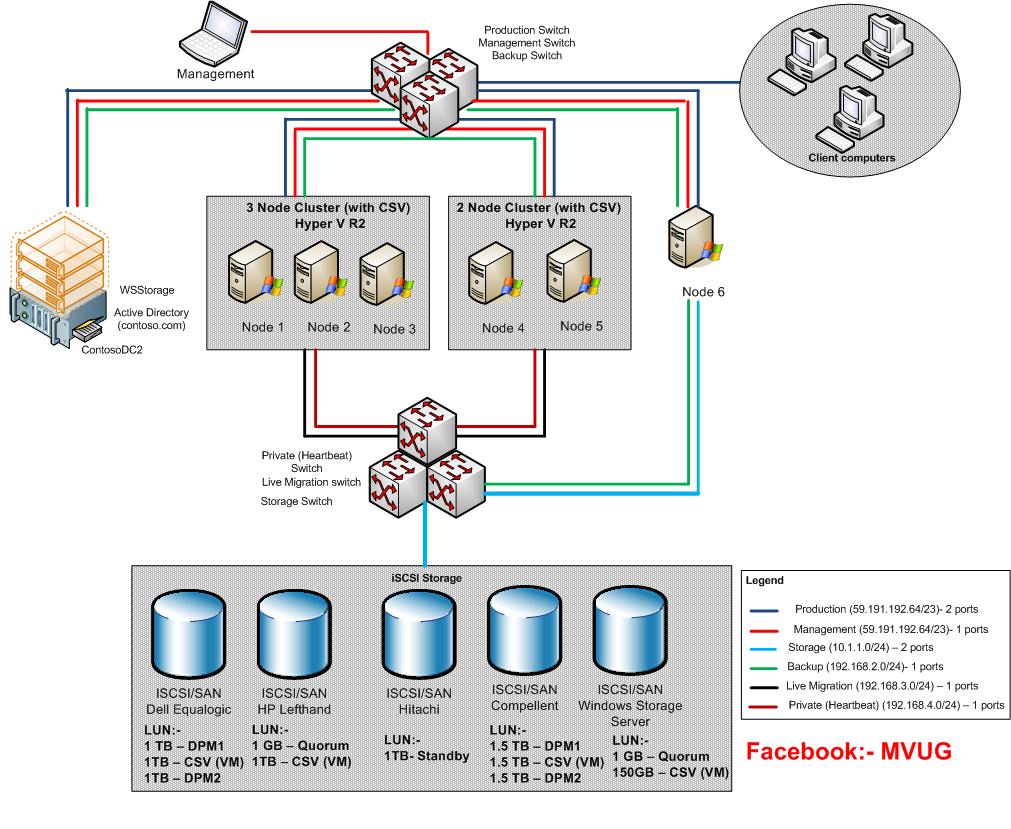

Физическая и логическая коммутация

Совокупность оборудования и линий связи между СХД и серверами образуют так называемую SAN сеть. Отказоустойчивое подключение участников SAN сети подразумевает постоянное наличие хотя бы одного пути между инициатором (хост) и таргетом (СХД). Т.к. СХД сейчас практически поголовно имеют минимум два контроллера, каждый сервер должен иметь связь с каждым из них. В простейшем варианте серверы подключаются к СХД напрямую. Такой режим работы называют Direct Attach. СХД Qsan поддерживают такой режим работы. В этом случае каждый сервер должен иметь двухпортовую HBA для соединения с каждым контроллером СХД. Т.е. между сервером и СХД будет 2 пути. При наличии максимального количества опциональных портов в таком режиме к СХД можно подключить до 10 серверов через iSCSI или до 8 серверов через Fibre Channel.

В большинстве случаев серверы соединяются с СХД через коммутаторы. Для большей надежности их должно быть два (в общем случае их, конечно же, может быть больше, но это они все равно делятся на две группы – фабрики). Этим выполняется защита от выхода из строя самого коммутатора, линка и порта контроллера СХД/HBA. В этом случае каждый сервер и каждый контроллер СХД подключается к каждому коммутатору. Т.е. между каждым сервером и СХД будет 4 пути (в случае двух коммутаторов).

Для большей надежности их должно быть два (в общем случае их, конечно же, может быть больше, но это они все равно делятся на две группы – фабрики). Этим выполняется защита от выхода из строя самого коммутатора, линка и порта контроллера СХД/HBA. В этом случае каждый сервер и каждый контроллер СХД подключается к каждому коммутатору. Т.е. между каждым сервером и СХД будет 4 пути (в случае двух коммутаторов).

Важные замечания по поводу параметров SAN сети:

- Фабрики между собой не соединяются для изоляции в случае возникновения ошибок в сети;

- Если протокол iSCSI делит использование коммутаторов с другими сервисами, то весь трафик iSCSI должен быть помещен в изолированный VLAN;

- Для протокола Fibre Channel необходимо настроить в коммутаторах зонирование по принципу «один инициатор – один или несколько таргетов» для исключения влияния серверов друг на друга;

- Для iSCSI соединений со скоростью 10G и выше рекомендуется включить поддержку кадров большого размера (MTU=9000) с целью увеличения производительности.

Важно помнить, что необходимо изменить MTU у всех участников сети: порты контроллера СХД, физические коммутаторы, физические и виртуальные порты сетевых карт серверов.

Для Qsan параметр MTU меняется на каждом порту каждого контроллера в меню iSCSI Ports

В Windows Server параметр MTU меняется в настройках драйвера адаптера:

Control Panel\Network and Internet\Network Connections → Свойства конкретного адаптера → Configure → Advanced → Jumbo Packet (у некоторых адаптеров этот пункт может называться что-то типа Large Packets)

Для получения инструкций по изменению MTU у физических коммутаторов рекомендуем обратиться к документации конкретного производителя.

Действия на стороне СХД

Необходимые настройки на СХД можно разделить на два этапа:

- Настройка интерфейсов

- Настройка пространства хранения

Настраивать интерфейсы требуется в основном в случае использования протокола iSCSI: необходимо задать IP адреса портов на вкладке iSCSI Ports.

В случае использования интерфейса Fibre Channel ничего настраивать, как правило, не нужно.

Далее необходимо создать пространство хранения. Сначала создается пул – группа физических накопителей, работающих совместно. Пулов в пределах СХД может быть несколько. Накопители внутри пула объединяются в соответствии с выбранным при его создании уровнем RAID, обеспечивая заданную надежность. Пулы создаются на вкладке Pools → Create Pool, где запускается пошаговый мастер.

- Необходимо выбрать тип пула: thick (место выделяется сразу) или thin (место выделяется по мере заполнения). Отметим, что thick пулы являются более производительными.

- Выбрать конкретные диски

- Уровень RAID

- Указать параметры физических накопителей, влияющие на их производительность.

Рекомендуется использовать установки по умолчанию для максимальной скорости:- Enable Disk Write Cache

- Enable Disk Read-ahead

- Enable Disk Command Queuing

- Disable Disk Standby

Помимо обычных пулов Qsan поддерживает создание AutoTiering пулов при условии активации соответствующей лицензии.

После создания пула(ов) необходимо создать тома (volume): Volumes → Create volumes. Также запустится пошаговый мастер создания тома.

Необходимо задать требуемый размер тома, тип тома выбирается как RAID volume. Рассмотрим их более подробно.

- Block Size – размер блока, который будет эмулироваться для хоста. Для Windows Server рекомендуется задать значение 4КБ как наиболее оптимальное.

- Background I/O Priority – приоритет фоновых задач (расширение, миграция и пр.)

- Erase Volume Data – необходимость зануления создаваемого тома. Значение Fast Erase соответствует записи нулей в первый гигабайт пространства, может быть полезно при повторном использовании дисков с целью удалить остатки предыдущих данных (стереть таблицы размещения). Full Erase – запись нулей по всему объему, полезно для достижения максимальной производительности в случае использования RAID 1/10.

- Enable Cache Mode (Write-back Cache) – включение кэша СХД. Очень сильно влияет на производительность.

- Enable Video Editing Mode

- Enable Read-ahead – включение упреждающего чтения. Положительно влияет на производительность.

- Enable Fast RAID Rebuild – при активации данной настройки система будет вести трекинг всех записываемых блоков, чтобы понимать, сколько реальных данных записано на том. В случае выхода из строя диска в составе RAID группы во время ребилда не будут копироваться пустые блоки, что может ускорить данный процесс. Однако стоит помнить, что использование Fast Rebuild снижает производительность при случайном доступе.

Заключительным этапом в настройке СХД является публикация томов для доступа к ним со стороны хостов через функционал LUN mapping → Map LUN.

- Необходимо выбрать протокол доступа: FCP (Fibre Channel) или iSCSI. Доступ к одному и тому же тому может быть только через один протокол.

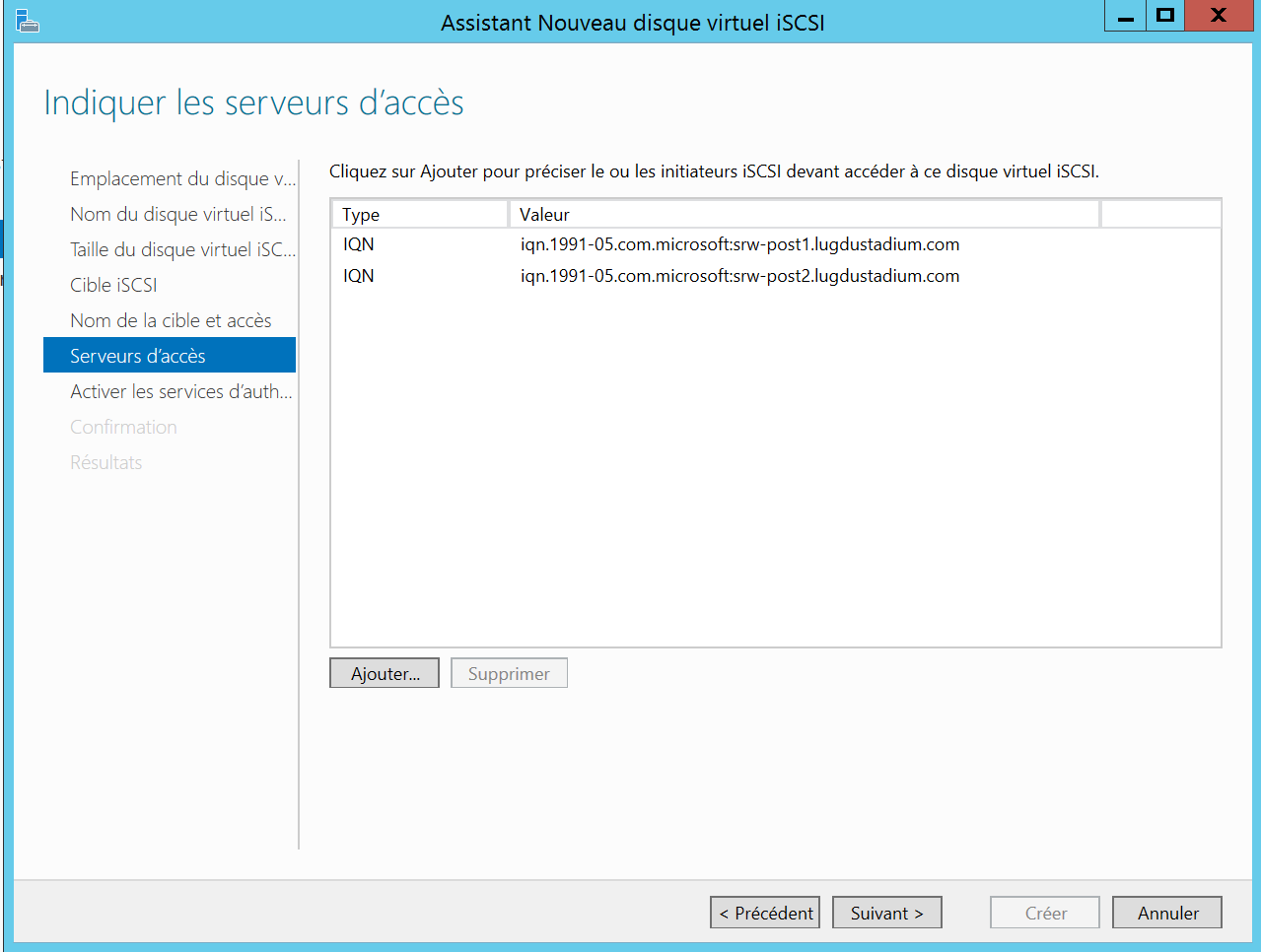

- Allowed Host – список хостов, которым разрешен доступ к тому. По умолчанию разрешено всем (*). Однако рекомендуется всегда явно указывать разрешения для исключения конфликтов доступа и, соответственно, повреждения файловой системы. Для Fibre Channel указываются WWPN хостов (с возможностью выбора из всех доступных в SAN сети). Для iSCSI указываются IQN хостов. В случае нескольких хостов они добавляются по кнопке Add Host. Со стороны Windows значения WWPN и IQN можно узнать через консольную (PowerShell) команду Get-InitiatorPort

- LUN – ID с которым том будет виден хостам. Также по этому идентификатору легко опознать том со стороны сервера. В случае использования Windows Cluster для корректной работы LUN ID должен быть одинаковым для одного и того же тома для всех узлов кластера.

Действия на стороне хоста

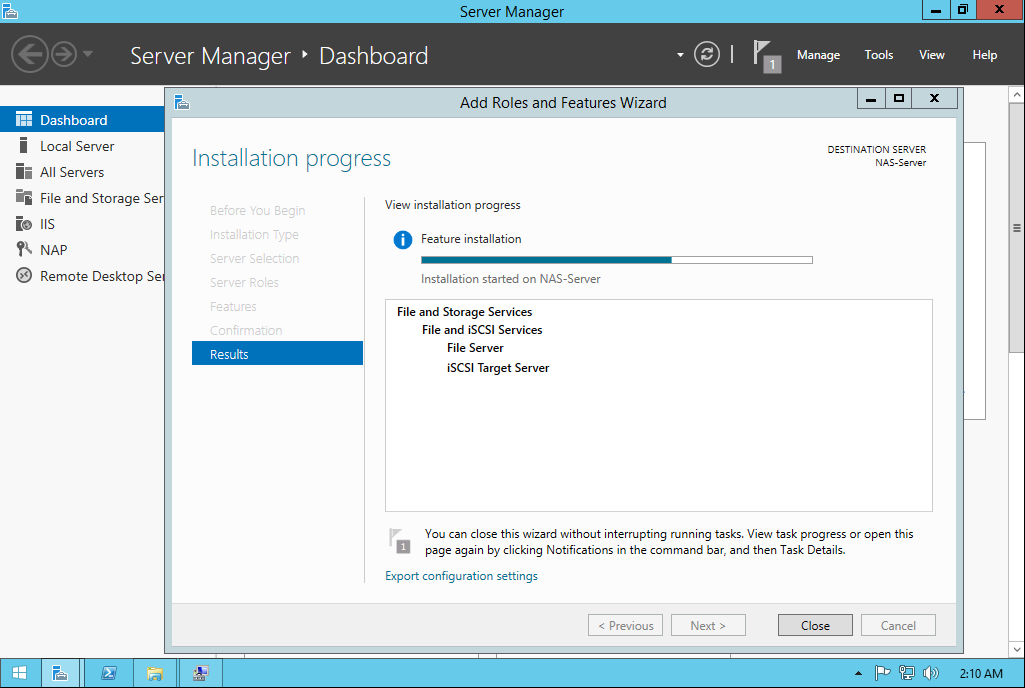

Первоначально необходимо один раз установить на сервере компонент Multipath IO, который обеспечивает работу многопутевого ввода/вывода. Данное действие производится через стандартный диалог Add Roles and Features

При использовании протокола iSCSI необходимо выполнить:

- В свойствах Software iSCSI Initiator необходимо указать адреса таргетов, т.е. СХД на вкладке Discovery должны быть введены все используемые IP адреса контроллеров СХД

- После обнаружение таргетов к ним необходимо подключиться при помощи кнопки Connect. Отметим важные детали:

- Необходимо добавить подключаемые таргеты в список Избранных, чтобы в случае разрыва соединения происходило автоматическое переподключение

- Необходимо включить поддержку MPIO

- Хотя автоматическое определение маршрутизации в большинстве случаев работает корректно, мы все же рекомендуем не пренебрегать явным указанием с какого сетевого интерфейса сервера необходимо подключаться к конкретному таргету (Advanced Settings)

- Если через один и тот же сетевой интерфейс сервера производится работа с нескольким портами СХД, то подключение через Connect нужно проделать для каждого пути

- После любого изменения параметров СХД и SAN сети необходимо выполнить Rescan в стандартной оснастке управления дисками или в Device Manager.

Итогом будет появление (т.к. мы добавляем новый том) нового устройства, доступного в нашем конкретном примере по 4 путям (согласно топологии подключения через два коммутатора в Discovery указано 4 IP адреса портов СХД) с LUN ID = 0, как мы и задавали при публикации на СХД. Также следует убедиться, что для диска установлена политика Round Robin, при которой все доступные пути до СХД будут использоваться равномерно.

Итогом будет появление (т.к. мы добавляем новый том) нового устройства, доступного в нашем конкретном примере по 4 путям (согласно топологии подключения через два коммутатора в Discovery указано 4 IP адреса портов СХД) с LUN ID = 0, как мы и задавали при публикации на СХД. Также следует убедиться, что для диска установлена политика Round Robin, при которой все доступные пути до СХД будут использоваться равномерно.

При использовании протокола Fibre Channel все гораздо проще: достаточно выполнить Rescan для обнаружения нового тома. В нашем примере это том с LUN ID = 1, доступный по 4 путям. Как и в случае с iSCSI следует убедиться, что для диска установлена политика Round Robin, при которой все доступные пути до СХД будут использоваться равномерно.

Важное замечание касательно конфигурирования MPIO. По умолчанию Windows видит дисковые устройства по отдельности, т.е. каждый путь к устройству – это отдельный диск.

Чтобы ОС «склеила» все одинаковые диски в единое устройство, необходимо в стандартной оснастке MPIO добавить новое устройство как многопутевое. Для iSCSI устройств устанавливается отдельное разрешение. По окончании настройки потребуется перезагрузить сервер. Данную настройку необходимо произвести однократно для каждой СХД. После чего все вновь презентованные диски будут опознаваться ОС как многопутевые.

Для iSCSI устройств устанавливается отдельное разрешение. По окончании настройки потребуется перезагрузить сервер. Данную настройку необходимо произвести однократно для каждой СХД. После чего все вновь презентованные диски будут опознаваться ОС как многопутевые.

В случае использования кластера из нескольких хостов Windows Server, действия, описанные выше, необходимо повторить на каждом из хостов. После чего диски, появившиеся в системе, можно добавлять в дисковые ресурсы кластера.

В рамках этой статьи были рассмотрены преимущественно базовые операции, необходимые для подключения серверов Windows Server к СХД Qsan. Для получения более полной информации настоятельно рекомендуется ознакомиться с руководствами пользователей, предоставляемыми обоими вендорами.

Глава 4. Настройки хранилища — Windows Server 2016 Hyper

Пространства хранения и Windows как решение хранения

Данный раздел вкратце рассматривает самый большой сдвиг в хранилищах, введённый в Windows Server 2012. Хотя она напрямую и не является

темой Hyper-V, я рассматриваю её, так как она скорее всего окажет воздействие на тот способ, которым проектируются ваши среды Hyper-V, в особенности

в небольших организациях и офисах подразделений.

Хотя она напрямую и не является

темой Hyper-V, я рассматриваю её, так как она скорее всего окажет воздействие на тот способ, которым проектируются ваши среды Hyper-V, в особенности

в небольших организациях и офисах подразделений.

В своём введении я рассмотрел SAN с подключением через Fibre Channel и iSCSI, которые исторически являлись предпочтительным выбором для хранения в организации, так как они предоставляют множество преимуществ:

-

Хранилище является централизованным, что позволяет самое высокое использование всего доступного пространства в противовес множеству отдельных экземпляров хранилищ с избытком тратящегося впустую пространства.

-

Возможность централизованного резервного копирования.

-

Они предлагают наивысшие уровни производительности и масштабируемости, которые возможны именно благодаря тому, что все хранилища централизованы, что делает возможным приобретение решений хранения с более высокими свойствами.

-

Хранилище доступно всем серверам в его центре обработки данных, предоставляя требуемые этим серверам подключения, такие как Fibre Channel или iSCSI.

-

Централизованные хранилища делают возможной простую миграцию виртуальных машин между физическими хостами, так как данное хранилище может быть доступно множеству серверов.

-

Они предоставляют совместно используемое хранилище, которое требуется во многих сценариях кластеров.

Применение высокоэффективного централизованного хранилища всё ещё великолепный вариант для многих организаций и вариантов применения. Однако

и другая модель применяется во многих организациях и поставщиках служб, в том числе и Microsoft Azure: решения JBOD (just a bunch of disks,

простой массив независимых дисков), которые являются либо локальными для сервера, либо выступают в виде какой- то внешней полки, подключаемой ко

множеству хостов. Это может предоставлять высокую эффективность в отношении стоимости, так как подсистемы хранения основываются на обычных дисках,

которые намного экономичнее решений SAN. Важно однако строить надёжные решения с резервным копированием по той причине, что локальные хранилища

содержат критические рабочие нагрузки (например, ваши виртуальные машины).

Это может предоставлять высокую эффективность в отношении стоимости, так как подсистемы хранения основываются на обычных дисках,

которые намного экономичнее решений SAN. Важно однако строить надёжные решения с резервным копированием по той причине, что локальные хранилища

содержат критические рабочие нагрузки (например, ваши виртуальные машины).

Windows Server издревле имел возможность построения отказоустойчивого хранилища с помощью технологии избыточных массивов независимых дисков (RAID, redundant array of independent disks) в одной из двух моделей: RAID-1, которая зеркалирует все данные с одного диска на другой и RAID-5, которая применяет чередование при помощи вычисляемых сумм (parity). Однако, для таких реализаций RAID имеются некоторые вызовы:

-

Они не обладают средствами самовосстановления. Если некий диск был утрачен, другой диск следует настраивать вручную для его замены.

-

Возможно только полное выделение (thick/fat provisioning), что означает что некий том должен может быть создан только если доступно всё физическое пространство.

Динамичное выделение (thin provisioning), которое позволяло создавать тома выходящие по своим размерам за пределы

имеющегося физического пространства, было недоступно.

Динамичное выделение (thin provisioning), которое позволяло создавать тома выходящие по своим размерам за пределы

имеющегося физического пространства, было недоступно. -

Управляемость была связана с достаточно головоломными проблемами и изменять размеры RAID было не простой задачей.

-

Они не поддерживалиь в отказоустойчивых кластерах.

Основы Пространств хранения

Windows Server 2012 ввёл в практику Пространства хранения (Storage

Spaces), как некий совершенно новый способ представления и использования подключаемых напрямую (direct- attached) хранилищ.

При использовании Пространств хранения все предоставляющие подлежащее хранилище данных физические диски полностью абстрагируются из общего

процесса запроса новых томов, теперь именуемых Пространствами

(spaces) и все необходимые для восстановления избыточности действия в случае отказа какого- то диска

выполняются автоматически данной технологией Пространств хранения по мере того как имеются доступными достаточные физические диски. Пространства хранения предоставляют программно определяемое решение хранения, которое при использовании локального хранилища снабжает

решениями хранения с высокими доступностью и масштабируемостью.

Пространства хранения предоставляют программно определяемое решение хранения, которое при использовании локального хранилища снабжает

решениями хранения с высокими доступностью и масштабируемостью.

Я собираюсь пройтись по Пространствам хранения, сосредоточившись на их воплощении в Windows Server 2012, том как они изменились в Windows Server 2012 R2 и затем какими они стали в Windows Server 2016. Будет полезным изучить все возможности в каждой версии Windows Server и посмотреть как развивались Пространства хранения, чтобы это помогла лучшему их пониманию.

Самый первый шаг состоит в создании пула хранения, который состоит в выборе одного или более

физических дисков, которые затем собираются воедино в пул и могут применяться в технологии Пространств хранения. Поддерживаемыми типами

в пуле хранения являются диски с USB-, SATA- и SAS- типами подключения. Эти диски всего лишь являются стандартными дисками, JBOD, такими как

HDD, SSD и даже NVMe для наилучшей производительности. Без какой бы то ни было аппаратной поддержки высокой доступности, такой как RAID за сценой,

Пространства хранения заботятся о восстановлении после сбоев. Наличие применимости устройств с USB- подключениями великолепно для

настольных решений, в то время как серверы сосредотачиваются на подключаемых через SAS- или SATA- устройствах. Кроме того, осуществляется

полная поддержка совместно используемых SAS, что означает, что при подключении многочисленных хостов в некий кластер можно применять дисковые

полки, а создаваемые в них Пространства хранения с совместно используемыми устройствами SAS доступны всем узлам в данном кластере и могут

применяться как часть Совместно используемых томов кластера (CSV, Cluster Shared Volumes). Это позволяет некоторому кластеру хостов Hyper-V

применять собранное в кластер Пространство хранения как общее хранилище для виртуальных машин. Если применяется некая внешняя дисковая полка,

Пространства хранения поддерживают протокол SES, который делает возможным индикацию отказов в имеющемся внешнем хранилище если он доступен,

например, LED плохого диска, в случае если имеющееся событие Пространтсв хранения выявит некую проблемы с каким- то физическим диском.

Без какой бы то ни было аппаратной поддержки высокой доступности, такой как RAID за сценой,

Пространства хранения заботятся о восстановлении после сбоев. Наличие применимости устройств с USB- подключениями великолепно для

настольных решений, в то время как серверы сосредотачиваются на подключаемых через SAS- или SATA- устройствах. Кроме того, осуществляется

полная поддержка совместно используемых SAS, что означает, что при подключении многочисленных хостов в некий кластер можно применять дисковые

полки, а создаваемые в них Пространства хранения с совместно используемыми устройствами SAS доступны всем узлам в данном кластере и могут

применяться как часть Совместно используемых томов кластера (CSV, Cluster Shared Volumes). Это позволяет некоторому кластеру хостов Hyper-V

применять собранное в кластер Пространство хранения как общее хранилище для виртуальных машин. Если применяется некая внешняя дисковая полка,

Пространства хранения поддерживают протокол SES, который делает возможным индикацию отказов в имеющемся внешнем хранилище если он доступен,

например, LED плохого диска, в случае если имеющееся событие Пространтсв хранения выявит некую проблемы с каким- то физическим диском. Хотя многие полки хранения работают с Пространствами хранения кластера, Microsoft имеет определённые сертифицированные полки для Windows

Server 2012, которые документированы в каталоге Windows Server.

Хотя многие полки хранения работают с Пространствами хранения кластера, Microsoft имеет определённые сертифицированные полки для Windows

Server 2012, которые документированы в каталоге Windows Server.

В пространствах хранения также могут быть применены и прочие технологии, такие как BitLocker. При создании некоторого нового пула хранения все добавляемые в этот пул хранения диски исчезнут из инструментария Диспетчера дисков, так как они теперь виртуализированы и используются исключительно самой технологией Пространств хранения. Состояние данных дисков можно просматривать через обзор Пулов Пространства хранения внутри Служб Файлов и Хранилища (File и Storage Services) в Диспетчере сервера.

Применение Пространств хранения

Для создания Пространств хранения (Storage Spaces) воспользуйтесь следующими шагами:

-

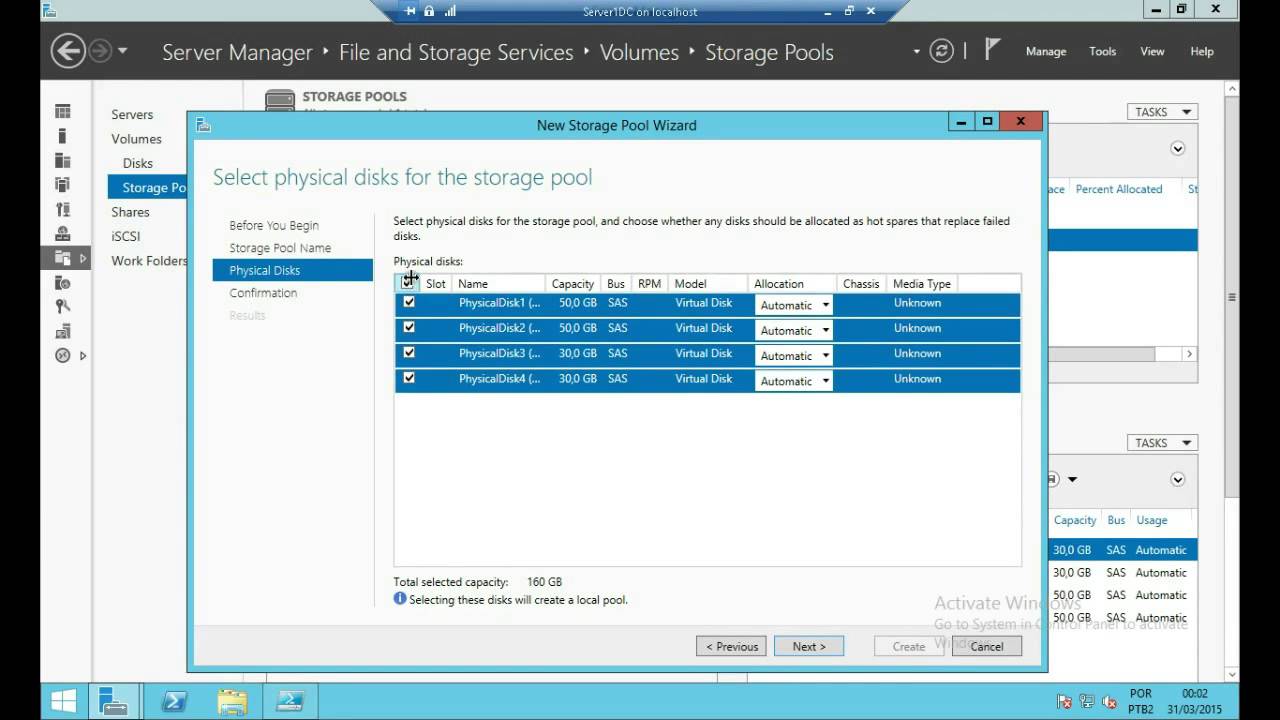

Из меню Задачи (Tasks) Выберите Новый пул хранения, что запустит соответствующий мастер Нового пула хранения.

-

Введите название для этого нового пула хранения и необязательное описание а затем кликните Далее (Next).

-

В своём следующем экране выберите необходимые физические диски, которые доступны для добавления в свой заново создаваемый пул и их размещение. Устанавливаемым по умолчанию расположЕнием является Дисковое хранилище (Disk Store), который будет применяться как часть вашего заново создаваемых виртуальных дисков, но также может быть выступать резервом для целей Горячей замены (Hot Spare). Кликните Далее (Next).

-

При появлении запроса на подтверждение кликните Создать (Create) для создания этого пула хранения.

Теперь доступен пул хранения и ваш следующий шаг состоит в создании виртуальных дисков внути данного пула хранения. Хотя Пространствами

хранения и применяется термин виртуальный диск, он не является виртуальным жёстким диском любого рода и

не применяет никоим образом VHD или VHDX. В данном контексте виртуальный диск просто является неким объектом, который создаётся в нём для

использования операционной системой, которая осуществляет прямую запись в блоки внутри имеющегося пула хранения.

В данном контексте виртуальный диск просто является неким объектом, который создаётся в нём для

использования операционной системой, которая осуществляет прямую запись в блоки внутри имеющегося пула хранения.

Пространства хранения вводят некую функциональность, которая ранее была доступна только при использовании некоторого внешнего решения хранения

такого как устройства SAN или NAS: способность динамичного выделения (thin provision). В процессе создания виртуального диска доступен вариант

создания нового виртуального диска фиксированного объёма (что означает, что всё пространство для данного размера виртуального диска выделяется в

момент его создания), либо динамического выделения (что означает, что пространство из пула берётся только по мере необходимости). Применение

диска с динамическим выделением делает возможным создание виртуального диска намного большего размера чем имеется доступным реального пространства

хранения. Это позволяет вам изначально создавать большой том без наличия предварительно выделенного физического хранилища.

Это позволяет вам изначально создавать большой том без наличия предварительно выделенного физического хранилища.

Итак, это не означает, что вы сможете хранить в диске с динамическим выделением данных больше, чем выделяется в вашем пуле, однако такой

типичный том пополняется со временем. Я могу создать некий диск с динамическим выделением в 10 ТБ, который изначально имеет только 1 ТБ

связанного с ним физического хранилища, я добавил бы 1 ТБ физического пространства в этот пул просто вставляя больше дисков. Когда будет

достигнуты 2 ТБ, я добавляю другое хранилище в 1 ТБ вставляя диски ещё и так далее. По мере того как я добавляю физические диски до его заполнения

нет никаких проблем. При достижении установленного порогового значения будет выдаваться предупреждающее сообщение, уведомляющее меня об этом,

что даёт мне запас времени для добавить необходимые диски. При создании некоторого виртуального диска всё что требуется от вас это знать какой

пул хранения вы используете для создания этого диска. Никакие знания о физических дисках не требуются и даже не доступны в открытом виде.

Основной фишкой Пространств хранения является такое абстрагирование в создании виртуальных дисков, которое необходимо для соответствия вашим

потребностям. Для создания виртуального диска выполните следующие шаги:

Никакие знания о физических дисках не требуются и даже не доступны в открытом виде.

Основной фишкой Пространств хранения является такое абстрагирование в создании виртуальных дисков, которое необходимо для соответствия вашим

потребностям. Для создания виртуального диска выполните следующие шаги:

-

Выберите какой- то пул хранения, в котором создавать новый виртуальный диск, а заетм в разделе Виртуальных дисков выберите соответствующую задачу Новый виртуальный диск (New Virtual Disk).

-

Убедитесь, что на странице выбора Пула хранения вашего мастера выбраны правильные сервер и пул хранения и кликните далее (Next).

-

Задайте название и необязательное описание для этого нового виртуального диска и кликните Далее (Next).

-

Изберите нужную схему для своего хранилища. Доступными вариантами являются Простой (Simple, никакой избыточности с чередованием данных по множеству дисков), Зеркалирование (Mirrored, данные дублируются на дополнительные диски) и Контрольный суммы (Parity, чередование данных как по множеству дисков как для Простого варианта, однако с добавлением данных контрольных сумм — parity — с тем, чтобы в случае события отказа диска никакие данные не были утрачены).

До появления пространств хранения эти схемы именовались бы, соответственно, как RAID-0, RAID-1 и

RAID-5 {Прим. пер.: RAID-6}, однако такое именование не применяется в схемах Пространств хранения по

причине различий реализации.

До появления пространств хранения эти схемы именовались бы, соответственно, как RAID-0, RAID-1 и

RAID-5 {Прим. пер.: RAID-6}, однако такое именование не применяется в схемах Пространств хранения по

причине различий реализации.Сделайте нужный выбор и кликните далее (Next), как это отображено на Рисунке 4.3. Начиная с Windows Server 2012 является доступным зеркалирование с тремя копиями, однако его следует настраивать в PowerShell вместо такого графического интерфейса.

-

Определите тип выделения пространства: Динамический (Thin) или Фиксированный (Fixed) и кликните Далее (Next).

-

Определите размер, если вы определили Динамическое выделение, вы теперь можете выбрать размер больший, чем доступное вам физическое пространство. Кликните Далее (Next).

-

Отображается подтверждение выбранных опций. Проверьте их и кликните Создать (Create).

После создания виртуального диска он становится доступным внутри оснасток MMC Диспетчера сервера (Server Manager) и Управления дисками (Disk Management) для создания томов и форматирования некоторой файловой системой. То пространство, которое используется внутри пула можно увидеть в Диспетчере сервера или, если вы применяете некоего клиента, в апплете Панели управления (Control Panel) Пространств хранения.

| Совет | |

|---|---|

|

Одним из соображений, к которому я всегда прибегал при использовании программно определяемого RAID до Windows Server 2012, относилось к

производительности. Любые вычисления контрольных сумм требуют применения процессора, который использует свои такты на вычисления и обычно

это не было оптимальным в сравнении с еким аппаратным решением RAID.

|

Изменения Пространств хранения Windows Server 2012 R2

Пространства хранения (Storage Spaces) Windows Server 2012 R2 имеют ряд улучшений. Одним из них является возможность наличия пространств с двумя контрольными суммами (parity), что делает доступным двух копий информации о контрольных суммах вместо одной. Это предоставляет дополнительную надёжность (удвоение контрольных сумм — parity — требует применения PowerShell и не доступно в Диспетчере севера -Server Manager), предоставляя поддержку для сценариев с контрольными суммами в кластерах, а также выполняет более быстрое перестроение в случае отказа. Утраченная информация восстанавливается на множестве дисков в пуле вместо повторного построения всего на отдельном диске, то ограничивало бы допустимую скорость всех доступных отдельному диску IOPS.

Имеется ещё одно ещё большее изменение пространств хранения Windows Server 2012 R2, которое может открыть новые уровни производительности:

введение различия между обычными шпиндельными дисковыми устройствами (HDD) и твердотельными накопителями (SSD). В Пространствах хранения

Windows Server 2012 R2 вы можете создавать различные уровни хранения, некий уровень HDD и какой- то уровень SSD. Технология Пространств хранения

перемещает наиболее используемые блоки файлов с их уровня HDD на уровень SSD, предоставляя наивысший уровень производительности. Кроме того,

уровень SSD может применять кэширование с отложенной записью (write-back). При возникновении записи, они вначале записываются на имеющийся

уровень SSD, который является очень быстрым, а затем по мере возможностей переписывется на уровень HDD для долговременного хранения. Такая

многоуровневая модель хранения показана на Рисунке 4.4.

В Пространствах хранения

Windows Server 2012 R2 вы можете создавать различные уровни хранения, некий уровень HDD и какой- то уровень SSD. Технология Пространств хранения

перемещает наиболее используемые блоки файлов с их уровня HDD на уровень SSD, предоставляя наивысший уровень производительности. Кроме того,

уровень SSD может применять кэширование с отложенной записью (write-back). При возникновении записи, они вначале записываются на имеющийся

уровень SSD, который является очень быстрым, а затем по мере возможностей переписывется на уровень HDD для долговременного хранения. Такая

многоуровневая модель хранения показана на Рисунке 4.4.

Когда вы применяете множество уровней, у вас должно иметься достаточное число дисков на каждом из уровней чтобы соответствовать выбранному варианту

надёжности данных. Например, если для виртуального диска выбрано зеркалирование, для предоставления достаточного пространства на уровне HDD и

уровне SSD необходимо, как минимум, по два диска. То же самое применимо и к кэшированию с отложенной записью. Теперь Пространства хранения не предоставляют

падения в надёжности.

То же самое применимо и к кэшированию с отложенной записью. Теперь Пространства хранения не предоставляют

падения в надёжности.

Для использования множества уровней и кэширования отложенной записи вы можете воспользоваться PowerShell, который предоставляет гранулированное управление (хотя по умолчанию создаётся кэш отложенной записи 1 ГБ на всех новых виртуальных дисках если достаточно пространства SSD и диски доступны в этом пуле), Либо Диспетчер сервера для более простого практического применения, но с меньшей степенью грануляции в выбираемой конфигурации. В последующих командах PowerShell я создаю некое пространство хранения из четырёх дисков и двух SSD, а затем создаю виртуальный диск и создаю какой- то том.

#Перечисляем все диски, которые могут быть помещены в пул и выводятся в формате таблицы (format-table)

Get-PhysicalDisk -CanPool $True | `

ft FriendlyName,OperationalStatus,Size,MediaType

#Запоминаем все физические диски, которые могут быть помещены в пул в какой- то переменной, $pd

$pd = (Get-PhysicalDisk -CanPool $True | Where MediaType -NE UnSpecified)

#Создаём некий новый Пул хранения с применением всех дисков из переменной $pd

# с неким названием My Storage Pool

New-StoragePool -PhysicalDisks $pd `

–StorageSubSystemFriendlyName "Storage Spaces*" `

-FriendlyName "My Storage Pool"

#Просматриваем все диски в нашем только что созданном Пуле хранения

Get-StoragePool -FriendlyName "My Storage Pool" | `

Get-PhysicalDisk | Select FriendlyName, MediaType

# Создаём два уровня в этом созданном нами Пуле хранения. #One for SSD disks and one for HDD disks

$ssd_Tier = New-StorageTier -StoragePoolFriendlyName "My Storage Pool" `

-FriendlyName SSD_Tier -MediaType SSD

$hdd_Tier = New-StorageTier -StoragePoolFriendlyName "My Storage Pool" `

-FriendlyName HDD_Tier -MediaType HDD

# Создаём новый виртуальный дтск в своём пуле с названием TieredSpace

# применяя имеющиеся уровни SSD (50GB) и HDD (300GB)

$vd1 = New-VirtualDisk -StoragePoolFriendlyName "My Storage Pool" `

-FriendlyName TieredSpace -StorageTiers @($ssd_tier, $hdd_tier) `

-StorageTierSizes @(50GB, 300GB) -ResiliencySettingName Mirror `

-WriteCacheSize 1GB

# в случае применения множества уровней не можем также определять -size, а также

# не можем использовать тип динамического выделения

#One for SSD disks and one for HDD disks

$ssd_Tier = New-StorageTier -StoragePoolFriendlyName "My Storage Pool" `

-FriendlyName SSD_Tier -MediaType SSD

$hdd_Tier = New-StorageTier -StoragePoolFriendlyName "My Storage Pool" `

-FriendlyName HDD_Tier -MediaType HDD

# Создаём новый виртуальный дтск в своём пуле с названием TieredSpace

# применяя имеющиеся уровни SSD (50GB) и HDD (300GB)

$vd1 = New-VirtualDisk -StoragePoolFriendlyName "My Storage Pool" `

-FriendlyName TieredSpace -StorageTiers @($ssd_tier, $hdd_tier) `

-StorageTierSizes @(50GB, 300GB) -ResiliencySettingName Mirror `

-WriteCacheSize 1GB

# в случае применения множества уровней не можем также определять -size, а также

# не можем использовать тип динамического выделения

Обычно со временем выявляются горячие блоки и они перемещаются на имеющийся уровень SSD как часть задания по оптимизации на час ночи.

Однако, определённые файлы могут быть закреплены за этим уровнем SSD, что оставит их там на постоянной основе. Чтобы пришпилить некий файл

к уровню SSD и тем самым принудительно оптимизировать его уровень, воспользуйтесь следующими командами:

Чтобы пришпилить некий файл

к уровню SSD и тем самым принудительно оптимизировать его уровень, воспользуйтесь следующими командами:

Set-FileStorageTier –FilePath M:\Important\test.vhd `

-DesiredStorageTier ($vd1 | Get-StorageTier –MediaType SSD)

Optimize-Volume –DriveLetter M –TierOptimize

Применяя технологию Пространств хранения вы можете создавать гибкие и высокопроизводительные решения хранения с применением подключаемых напрямую дисков хранения, что может быть полезным в различных сценариях и архитектурах. Я прохожусь по Пространствам хранения в своём видео: www.youtube.com/watch?v=x8KlY-aP9oE&feature=share&list=UUpIn7ox7j7bH_OFj7tYouOQ.

Применение множества уровней является великолепной возможностью для виртуализации и она поможет вам получить наивысшую производительность без необходимости наличия для всего решения хранения хранилища высокого уровня.

w3.org/1999/xhtml»> Изменения Пространств хранения Windows Server 2016Windows Server 2016 продолжил эволюцию Пространств хранения и применения этой технологии для разрешения совершенно нового уровня использования

подключаемых напрямую хранилищ: как кластерной хранилище в виде Совместно используемых в кластере томов (CSV, Cluster Shared Volumes).

Windows Server 2016 также вносит различие между SSD (как относительно экономичными хранилищами с флеш- памятью) и NVMe SSD (как обладающими

большими производительностью и стоимостью). Пространства хранения применяют различные типы хранилищ с флеш- памятью автоматически, причём наиболее

оптимальным образом, без какой бы то ни было настройки вручную. Например, при создании некоторого обычного Пространства хранения с применением

Диспетчера сервера в Windows Server 2016, автоматически создаются уровни HDD и SSD, соответственно как стандартный и более быстрый уровни.

При использовании Непосредственно подключаемых Пространств хранения (Storage Spaces Direct) имеется даже ещё большая грануляция (которую я поясню

более подробно в своём следующем разделе Непосредственные Пространства хранения). Кроме того, в Windows Server 2016 дополнительные опции устойчивости теперь являются теперь частью соответствующего мастера Диспетчера сервера

(Server Manager), что отображено на Рисунке 4.5:

Кроме того, в Windows Server 2016 дополнительные опции устойчивости теперь являются теперь частью соответствующего мастера Диспетчера сервера

(Server Manager), что отображено на Рисунке 4.5:

Хотя основным средоточием Пространств хранения Windows Server 2016 и являются Непосредственно подключаемые пространства хранения (Storage Spaces Direct), также имеются и иные изменения вне пределов улучшений в рамках Диспетчера сервера:

-

Исполнение оптимизации данных между имеющимися уровнями выполняется более часто. В Windows Server 2012 R2 такая оптимизация выполнялась один раз в день. В Windows Server 2016 она осуществляется каждые четыре часа, что видно через свойства расписания триггера заданий Оптимизации уровня хранения (Storage Tiers Optimization). Это помогает такой оптимизации лучше соответствовать смещениям рабочих нагрузок. Кроме того, данный оптимизатор применяет приоритезацию для перемещения первыми наиболее важных данных (что означает ещё большие преимущества перемещения между уровнями) в случае, когда он не может выполнить полную оптимизацию в назначенное время.

Реплика хранения

Непосредственные Пространства хранения совместно с Репликой хранения

Хотя протокол Блока серверных сообщений (SMB, Server Message Block) и был доступен в Windows на протяжении длительного времени, его применение было

ограничено обычными сценариями совместного использования файлов, такими как доступ пользователей к их домашним дисководам или совместное владение

файлами, содержащими архивированные данные. Hyper-V давно нуждался в наличии доступа к хранилищу на уровне блоков, то есть чтобы определённый хост

монтировал содержащие виртуальные машины тома, которые могут напрямую подключаться или присоединяться через такие среды как iSCSI или

Fibre Channel. Однако это являлось вызовом для многих контор, в которых применялись для виртуализации протоколы файлового уровня. В частности, VMware

для хранения виртуальных машин использовал NFS, который был доступен во многих решениях NAS, которые обычно намного экономичнее чем решения SAN и

хорошо соответствовали многим средам.

В частности, VMware

для хранения виртуальных машин использовал NFS, который был доступен во многих решениях NAS, которые обычно намного экономичнее чем решения SAN и

хорошо соответствовали многим средам.

Windows Server 2012 внёс большой вклад в SMB, чтобы сделать его готовым решением корпоративного уровня, подходящим для хранения виртуальных машин и прочих рабочих нагрузок корпорации, таких как базы данных сервера SQL. SMB 3 привносит много новой функциональности и улучшений производительности чтобы сделать его практичным выбором для виртуального хранилища.

Изначально я говорил об использовании SMB для хранения пользовательских документов, а теперь, при наличии SMB 3, он будет применяться для хранения критически важных виртуальных машин. Это требует большой подвижки в технологиях надёжности и отработки отказов.

Когда некий пользователь редактирует какой- то документ PowerPoint в совместном ресурсе SMB, части такого документа кэшируются локально и

временами пользователь кликает Save. Если ваш файловый сервер SMB испытывает какую- то проблему — допустим, если он осуществляет перезагрузку или он

помещён в кластер и данный совместный файловый ресурс перемещён на другой узел в кластере — этот пользователь мог бы потерять соответствующий дескриптор

(handle) и блокировку данного файла, однако на самом деле это не имеет никакого значения. Когда в следующий раз данный пользователь нажимает Save,

всё восстанавливается и не происходит ничего страшного.

Если ваш файловый сервер SMB испытывает какую- то проблему — допустим, если он осуществляет перезагрузку или он

помещён в кластер и данный совместный файловый ресурс перемещён на другой узел в кластере — этот пользователь мог бы потерять соответствующий дескриптор

(handle) и блокировку данного файла, однако на самом деле это не имеет никакого значения. Когда в следующий раз данный пользователь нажимает Save,

всё восстанавливается и не происходит ничего страшного.

Теперь рассмотрим Hyper-V, хранящий какую- то виртуальную машину в неком совместном файле SMB, который испытывает какую- то проблему и этот совместно

используемый файл перемещается на другой узел в данном кластере. Вначале данный блок Hyper-V будет ожидать тайм- аут для своего TCP, прежде чем вернётся

реализация первоначального соединения, что может означать паузу в 30 секунд для данной ВМ, однако, кроме того Hyper-V теперь утратил свои дескрипторы

и блокировки на данном VHD, что является гораздо большей проблемой. Всякий раз когда документы пользователя могут применяться на протяжении нескольких часов,

корпоративные службы, такие как виртуальная машина или база данных ожидают, что дескрипторы на файлы будут доступны месяцами непрерывно.

Всякий раз когда документы пользователя могут применяться на протяжении нескольких часов,

корпоративные службы, такие как виртуальная машина или база данных ожидают, что дескрипторы на файлы будут доступны месяцами непрерывно.

Прозрачная отработка отказов SMB

Обычно для файловых служб в кластере некий отдельный узел монтирует определённый LUN (Logical Unit Number, Номер логического устройства), содержащий ту

файловую систему, которая будет совместно использоваться и предлагаться для совместного использования клиентам SMB. Если этот узел отказывает, другой узел в

кластере монтирует соответствующий LUN и предлагает свои совместно используемые файлы, однако соответствующий клиент SMB потерял бы свои дескрипторы и

блокировки. Прозрачная отработка отказов SMB (SMB Transparent Failover) предоставляет защиту от каких- либо отказов узла, делая возможным перемещение

совместного ресурса между узлами совершенно прозрачным образом для своих клиентов SMB и сопровождая все имеющиеся блокировки и дескрипторы, так же как

и само состояние установленного соединения SMB.

Данное состояние такого SMB соединения поддерживается в трёх сущностях: самом клиенте SMB, его сервере SMB, а также на том диске, который содержит эти данные. Прозрачная отработка отказов гарантирует, что имеется достаточный контекст для того, чтобы привнести обратно такое состояние данного соединения SMB на некий альтернативный узел в случае отказа узла, что сделает возможным продолжение работы SMB без наличия риска ошибки.

Важно понимать, что даже при наличии прозрачной отработки отказа SMB всё ещё может иметься некая пауза для ввода/ вывода, так как соответствующий

LUN всё ещё требуется смонтировать на некотором новом узле в имеющемся кластере. Тем не менее, команда отказоустойчивого кластера проделала гигантский

объём работы в отношении оптимизации такого размонтирования и монтирования LUN чтобы гарантировать, что оно никогда не займёт более 25 секунд.

Это звучит как достаточно большое значение времени, но поймите, что это наихудший вариант с большим количеством LUN и десятками тысяч дескрипторов. Для наиболее распространённых случаев это будет пара секунд, а корпоративные службы, такие как Hyper-V и сервер SQL могут обрабатывать некие операции

ввода/ вывода без ошибок, которые в таком наихудшем случае займут до 25 секунд.

Для наиболее распространённых случаев это будет пара секунд, а корпоративные службы, такие как Hyper-V и сервер SQL могут обрабатывать некие операции

ввода/ вывода без ошибок, которые в таком наихудшем случае займут до 25 секунд.

Существует также иная возможность прерывания в вводе/ выводе и того, что такой клиент SMB на самом деле заметит недоступность данного сервера SMB.

В обычном плановом сценарии, таком как перезагрузка узла для внесения исправлений, он уведомит всех клиентов, которые могут иметь активности. Если узел,

однако, завершит операцию неудачно, клиентам не будет выдано никаких уведомлений и, следовательно, данный клиент будет сидеть и ожидать тайм- аута TCP

прежде чем будут предприняты действия для повторного восстановления связи, что является пустой тратой ресурсов. Хотя некий клиент SMB моежет даже и не

подозревать что тот узел, с которым он общается в кластере отвалился, все прочие узлы в этом кластере информируются об этом в пределах секунды благодаря

различным сообщениям IsAlive, которые отправляются между узлами. Такая информированность используется возможностями

службами свидетельств (witness service), которые впервые стали доступными в Windows Server 2012. Такой сервер свидетель позволяет другому узлу в кластере

выступать в роли свидетеля для конкретного клиента SMB и, если соответствующий узел клиента сообщает о падении, данный узел свидетеля уведомляет напрямую

такого клиента SMB, позволяя этому клиенту соединиться с другим узлом, что минимизирует значение прерывания службы до пары секунд. Когда некий клиент

SMB взаимодействует с каким- то сервером SMB, который является частью кластера, такой сервер SMB будет уведомлять всех клиентов о том, что в данном

кластере доступны другие серверы, и такой клиент автоматически запросит один из прочих серверов в этом кластере отработать в качестве соответствующей

службы свидетельства для данного соединения.

Такая информированность используется возможностями

службами свидетельств (witness service), которые впервые стали доступными в Windows Server 2012. Такой сервер свидетель позволяет другому узлу в кластере

выступать в роли свидетеля для конкретного клиента SMB и, если соответствующий узел клиента сообщает о падении, данный узел свидетеля уведомляет напрямую

такого клиента SMB, позволяя этому клиенту соединиться с другим узлом, что минимизирует значение прерывания службы до пары секунд. Когда некий клиент

SMB взаимодействует с каким- то сервером SMB, который является частью кластера, такой сервер SMB будет уведомлять всех клиентов о том, что в данном

кластере доступны другие серверы, и такой клиент автоматически запросит один из прочих серверов в этом кластере отработать в качестве соответствующей

службы свидетельства для данного соединения.

Никакое ручное вмешательство не требуется для получения преимуществ Прозрачного восстановления SMB или соответствующей службы свидетельства. Когда вы

создаёте некий совместный ресурс в отказоустойчивом кластере Windows Server 2012 или выше, Прозрачная отработка отказов SMB включена автоматически.

Когда вы

создаёте некий совместный ресурс в отказоустойчивом кластере Windows Server 2012 или выше, Прозрачная отработка отказов SMB включена автоматически.

Горизонтальное масштабирование SMB

В своём предыдущем разделе я пояснил, что может иметься некая пауза в действиях из- за того, что определённый LUN должен быть перемещён между

узлами в имеющемся кластере файлового сервера, однако эта задержка может быть удалена. Данная проблема проистекает из того факта, что NTFS

является ничего не разделяющей (shared-nothing) файловой системой и не может поддерживать одновременный доступ множества экземпляров операционной

системы без риска разрушения. Данная проблема была решена введением CSV (Cluster Shared Volumes, Совместно используемых томов в кластере) в

Windows Server 2008 R2. CSV позволяет всем узлам в кластере чтение и запись в одном и том же наборе LUN при помощи некоторых искусных технологий,

тем самым удаляя потребность размонтирования и монтирования LUN между имеющимися узлами.

Windows Server 2012 расширил применение CSV на определённый тип файловых серверов, а именно вариант SoFS (Scale-Out File Server, Файлового сервера

Горизонтального масштабирования), который стал новой опцией, доступной в Windows Server 2012 и имеющей целью использование только при совместном

применении данных приложений, таких как базы данных сервера SQL и виртуальные машины Hyper-V. Обычный стиль общеупотребимого файлового сервера всё еще

доступен для незакреплённых за приложениями данных, как это показано на Рисунке 4.13. При выборе данной опции создания некоторого SoFS вы должны

выбрать CSV в качестве своего хранилища в случае когда совместные ресурсы последовательно создаются в рамках данного файлового сервера: данное

хранилище таким образом доступно для всех узлов в этом кластере. Так как данное хранилище для такого совместного ресурса доступно всем узлам в этом

кластере, этот совместный файловый ресурс сам по себе также размещается всеми имеющимися узлами в этом кластере, что теперь означает, что соединения

клиента SMB распределены по всем узлам вместо наличия всего одного. Кроме того, если некий узел падает, нет никакой потребности в работе по перемещению

таких LUN, что предлагает ещё лучшую практику примения и снижает все прерывания в операциях почти до нуля, а это критически важно для тех рабочих

нагрузок прикладных серверов, для которых эти SoFS выступают в качестве цели.

Кроме того, если некий узел падает, нет никакой потребности в работе по перемещению

таких LUN, что предлагает ещё лучшую практику примения и снижает все прерывания в операциях почти до нуля, а это критически важно для тех рабочих

нагрузок прикладных серверов, для которых эти SoFS выступают в качестве цели.

Применение SoFS предлагает и дополнительные преимущества. Обычно, когда создаётся некий файловый сервер общего назначения как часть имеющейся

конфигурации, вы должны присвоить такому новому файловому серверу кластера имя NetBIOS, а также его собственный уникальный IP адрес, так как этот IP

адрес должен размещаться на каком угодно узле в данном кластере, который в данный момент размещает такой файловый сервер. Применяя SoFS, все

узлы в этом кластере предлагают определённую файловую службу, что означает, что не требуется никакой дополнительный IP адрес. Необходимые IP адреса

таких узлов в данном кластере используются посредством настроенной службы DNN (Distributed Network Name, Распределённых сетевых имён).

Все имеющиеся в этом кластере узлы предлагают ту же самую файловую службу и таким образом совместно применяются в данном SoFS. Имеется некое изменение функциональности между Windows Server 2012 и Windows Server 2012 R2. В Windows Server 2012 некий отдельный клиент SMB соединялся только с единственным из имеющихся узлов в каждый определённый момент времени, даже если установлено множество соединений. Когда данный клиент SMB инициирует соединения, он вначале получает список всех имеющихся адресов IP для имеющихся в кластере хостов и указывает один из них для начала своего сеанса SMB. Если затем применяется только этот узел, всякий раз когда такой узел испытывает некую проблему, клиент будет общаться с неким иным узлом. Единственное исключение состоит в том, что данный клиент SMB не взаимодействует с неким вторым узлом когда применяется служба свидетельства, которую я обсуждал ранее. Windows Server 2012 R2 ввёл функциональность установления балансировки, которая имеет два компонента:

-

Обладание имеющимися дисками CSV распределяется равномерно между всеми узлами в данном кластере, что разделяет общую рабочую нагрузку.

-

Соединения SMB выполняют балансировку с тем, чтобы клиенты могли напрямую обращаться к владельцу CSV, предоставляя наиболее оптимальное соединение при использовании собранных в кластер Пространств Хранения (Storage Spaces, такая повторная балансировка не требуется при использовании симметричных хранилищ -таких как подключаемых через Fibre Channel SAN, так как все узлы имеют эквивалентные соединения).

Это означает, что некий отдельный клиент SMB может теперь подключаться ко множеству узлов в кластере через SMB вместо некоторого отдельного узла.

SMB со множеством каналов

В любом решении критически важно избегать каких бы то ни было единых точек отказа, а если SMB применяется для доступа к определённому хранилищу,

содержащему виртуальные машины, необходима надёжность для предотвращения отказов, вызываемых единственным сетевым адаптером, сетевым кабелем, или

сетевым коммутатором. В инфраструктурах хранения применяются такие технологии,как MPIO (multipath I/O, ввод/ вывод со множеством путей) для предоставления

множественности путей к хранилищу, и в точности та же самая идея теперь доступна к применению в SMB с помощью SMB со множеством каналов

(SMB Multichannel).

В инфраструктурах хранения применяются такие технологии,как MPIO (multipath I/O, ввод/ вывод со множеством путей) для предоставления

множественности путей к хранилищу, и в точности та же самая идея теперь доступна к применению в SMB с помощью SMB со множеством каналов

(SMB Multichannel).

SMB со множеством каналов позволяет какому-то клиенту SMB устанавливать множество соединений для отдельного сеанса, предоставляя защищённость от

отказа отдельного соединения а также добавляя производительность. Как и большинство имеющихся функций SMB 3, никакие проводимые вручную шаги не требуются

при использовании SMB со множеством каналов; всё происходит автоматически. При установлении начального соединения SMB, этот клиент SMB отыскивает

такие дополнительные пути для применения. Это было бы очевидно, если бы отслеживали операции копирования файлов, поскольку изначально имеется только

полоса пропускания только одного соединения. Однако если установлено второе соединение и агрегируется полоса пропускания, получаемая пропускная

способность будет удвоена, а затем третье соединение и так далее. В случае, когда какое- то из соединений отваливается, всё ещё остаются прочие

соединения для продолжения непрерывного существования канала SMB.

В случае, когда какое- то из соединений отваливается, всё ещё остаются прочие

соединения для продолжения непрерывного существования канала SMB.

Чтобы увидеть применяется ли SMB со множеством каналов в вашем сервере, воспользуйтесь cmdlet PowerShell Get-SMBConnection,

который покажет все соединения SMB в некотором совместном ресурсе SMB. В следующем примере я вижу, что у меня есть только два соединения с моим

сервером:

PS C:\> get-smbconnection

ServerName ShareName UserName Credential Dialect NumOpens

---------- --------- -------- ---------- ------- --------

savdalsofs.sav... Virtuals NT VIRTUAL ... SAVILLTECH.N... 3.02 4

savdalsofs.sav... Virtuals SAVILLTECH\... SAVILLTECH.N... 3.02 2

Если я исполню cmdlet Get-SmbMultiChannelConnection из своего клиента, он отобразит мне все имеющиеся

доступными пути по тем серверам, которые могут принимать соединения, как это отображено в приводимом далее выводе. Отметим, что на стороне такого

сервера сетевая среда применяет группирование (team) NIC, что означает только один IP адрес, но оно всё ещё может применяться для усиления SMB

со множеством каналов.

Отметим, что на стороне такого

сервера сетевая среда применяет группирование (team) NIC, что означает только один IP адрес, но оно всё ещё может применяться для усиления SMB

со множеством каналов.

PS C:\> get-smbmultichannelconnection

Server Name Selected Client IP Server IP Client Server Interface Capable

Client RSS Client RDMA Index

----------- -------- --------- --------- ------- -------------- -------------- --------------

savdalsofs.... True 10.7.173.101 10.7.173.20 14 15 True False

savdalsofs.... True 10.7.173.23 10.7.173.20 15 15 True False

Чтобы убедиться какой из путей будет применён между выбранными клиентом и сервером я могу взглянуть на свои соединения TCP по удалённому порту 445,

который применяется для SMB. Это подтвердит что я использую оба имеющихся пути с четырьмя подключениями для каждого пути (что является установленным по

умолчанию числом).

Это подтвердит что я использую оба имеющихся пути с четырьмя подключениями для каждого пути (что является установленным по

умолчанию числом).

PS C:\> Get-NetTCPConnection -RemotePort 445

LocalAddress LocalPort RemoteAddress RemotePort State AppliedSetting

------------ --------- --------------- -------- ----- --------------

10.7.173.23 56368 10.7.173.20 445 Established Datacenter

10.7.173.23 49826 10.7.173.20 445 Established Datacenter

10.7.173.23 49825 10.7.173.20 445 Established Datacenter

10.7.173.23 49824 10.7.173.20 445 Established Datacenter

10.7.173.101 49823 10.7.173.20 445 Established Datacenter

10.7.173.101 49822 10.7.173.20 445 Established Datacenter

10.7.173.101 49821 10.7.173.20 445 Established Datacenter

10.7.173.101 49820 10.7.173.20 445 Established Datacenter

Непосредственный SMB

Хотя и имеются прочие технологии SMB, такие как шифрование, Масштабирование принимающей стороной (Receive Side Scaling), VSS для совместных файлов SMB

и прочие, последней функциональностью, которую я бы хотел упомянуть, это Непосредственный SMB (SMB Direct), который позволяет применять в SMB

сетевые адаптеры с возможностью RDMA. Я уже обсуждал RDMA (remote direct memory access, удалённый прямой доступ к памяти) в

Главе 3, Виртуальные сетевые среды, поскольку он относится к сетевым адаптерам и в равной степени важен

для SMB.

Я уже обсуждал RDMA (remote direct memory access, удалённый прямой доступ к памяти) в

Главе 3, Виртуальные сетевые среды, поскольку он относится к сетевым адаптерам и в равной степени важен

для SMB.

При использовании Непосредственного SMB с возможностями RDMA сетевого адаптера, почти не применяются ресурсы процессора сервера. Такой сетевой адаптер указывает некий блок памяти, который содержит все данные, которые требуется отправить в их получателя и затем сама карта берёт в свои руки заботу по отправке с применением максимально возможной скорости и при очень малых задержках. За сценой могут использоваться сетевые адаптеры RDMA с применением iWARP, RDMA over Converged Ethernet (RoCE) или InfniBand, однако это не имеет значения для протокола SMB, который всего лишь пользуется возможностями имеющегося RDMA.

Нет никаких дополнительных требований для применения Непосредственного SMB. Как и всё, что связано с SMB, если такая возможность имеется, она

должна быть предоставлена. Изначально между имеющимися клиентом и сервером устанавливается некое обычное соединение SMB. Отыскивается перечень

всех доступных соединений, что делает возможным применение множества путей, а затем обнаруживаются все имеющиеся возможности предоставленных

сетевых адаптеров. Если выясняется, что и отправитель и получатель поддерживают RDMA, тогда устанавливается некое соединение RDMA и операции SMB

переключаются с TCP на RDMA, причём это делается полностью прозрачно.

Изначально между имеющимися клиентом и сервером устанавливается некое обычное соединение SMB. Отыскивается перечень

всех доступных соединений, что делает возможным применение множества путей, а затем обнаруживаются все имеющиеся возможности предоставленных

сетевых адаптеров. Если выясняется, что и отправитель и получатель поддерживают RDMA, тогда устанавливается некое соединение RDMA и операции SMB

переключаются с TCP на RDMA, причём это делается полностью прозрачно.

Если вы применяете Непосредственный SMB в Windows Server 2012, вы увидите 50 процентное улучшение производительности при применении SMB Direct v2 в Windows Server 2012 R2 для небольших рабочих нагрузок ввода/ вывода, в частности для 8кБ IOPS, которые наиболее распространены в сценариях виртуализации.

Такое улучшение производительности важно, так как SMB применяется в настоящий момент не только для файлового обмена. SMB также используется

миграцией в реальном времени в некоторых конфигурациях с тем, чтобы в частности получить преимущества NIC с возможностями RDMA. Помните, что

не следует применять группирование NIC для сетевых адаптеров с возможностями RDMA, так как группирование NIC

блокирует применение RDMA.

Помните, что

не следует применять группирование NIC для сетевых адаптеров с возможностями RDMA, так как группирование NIC

блокирует применение RDMA.

Как воспользоваться SMB 3 в вашей среде

Если прямо сейчас ваш центр обработки данных располагает всеми хостами виртуализации, подключёнными к SAN верхнего уровня с применением Fibre Channel, скорее всего SMB 3 не окажет воздействия в настоящее время на такую среду. Однако, если не все серверы подключены к SAN, или у вас имеются новые окружения, такие как центры обработки данных или удалённые расположения, в которых нет SAN или которые не будут иметь SAN, однако вы желаете попытаться минимизировать стоимость инфраструктуры карт и коммутаторов Fibre Channel, SMB 3 может помочь.

Если у вас уже имеется SAN, однако в настоящее время нет необходимой инфраструктуры (к примеру, достаточного числа HBA) чтобы соединить все хосты с

этим SAN, тогда вам предоставляется на Рисунке 4. 14 великолепная возможность. Некий Горизонтально масштабируемый Файловый сервер помещается

спереди от имеющегося SAN, который предоставляет доступ к такому хранилищу SAN через SMB 3. Это позволяет применять уже вложенные инвестиции в имеющийся

SAN и его возможностям для применения всем центром обработки данных без требования для всех хостов быть подключёнными напрямую к этому SAN. Чтобы

обеспечить наилучшую производительность, предоставьте по крайней мере столько томов CSV, сколько у вас есть узлов в вашем кластере чтобы сделать

возможной применение балансировки. Для ещё более лучшей подстройки удвойте или утройте общее число томов CSV. Например, если у вас имеется четыре хоста

в вашем кластере SoFS, я бы пожелал иметь по крайней мере восемь томов CSV.

14 великолепная возможность. Некий Горизонтально масштабируемый Файловый сервер помещается

спереди от имеющегося SAN, который предоставляет доступ к такому хранилищу SAN через SMB 3. Это позволяет применять уже вложенные инвестиции в имеющийся

SAN и его возможностям для применения всем центром обработки данных без требования для всех хостов быть подключёнными напрямую к этому SAN. Чтобы

обеспечить наилучшую производительность, предоставьте по крайней мере столько томов CSV, сколько у вас есть узлов в вашем кластере чтобы сделать

возможной применение балансировки. Для ещё более лучшей подстройки удвойте или утройте общее число томов CSV. Например, если у вас имеется четыре хоста

в вашем кластере SoFS, я бы пожелал иметь по крайней мере восемь томов CSV.

Другим вариантом, если у вас нет SAN или вы не желаете применять его в определённых рабочих нагрузках является применение Пространств хранения

(Storage Spaces) в качестве лежащего в основе хранилища. Хотя и было бы возможным иметь отдельный сервер для применения пространств хранения и

размещения хранилища через SMB 3, это было бы плохим проектом из- за введения некой единой точки отказа. Если такой сервер SMB 3 недоступен, также

станет недоступной и все размещённые в этом сервере рабочие нагрузки. Всегда пользуйтесь неким кластером файлового сервера и применяйте

Пространства хранения в кластере, которые бы имели диски хранения в некоторой внешней полке доступными для подключения всеми узлами в этом кластере.

Убедитесь, что для созданных виртуальных дисков имеется в доступности надёжность, скорее всего в виде зеркалирования для лучшей производительности.

Это бы выглядело примерно как показано на Рисунке 4.15.

Хотя и было бы возможным иметь отдельный сервер для применения пространств хранения и

размещения хранилища через SMB 3, это было бы плохим проектом из- за введения некой единой точки отказа. Если такой сервер SMB 3 недоступен, также

станет недоступной и все размещённые в этом сервере рабочие нагрузки. Всегда пользуйтесь неким кластером файлового сервера и применяйте

Пространства хранения в кластере, которые бы имели диски хранения в некоторой внешней полке доступными для подключения всеми узлами в этом кластере.

Убедитесь, что для созданных виртуальных дисков имеется в доступности надёжность, скорее всего в виде зеркалирования для лучшей производительности.

Это бы выглядело примерно как показано на Рисунке 4.15.

SMB в качестве хранилища Hyper-V

использовать SMB 3 в Hyper-V просто. Для полного контроля за имеющимися совместными ресурсами и уровнем файловой системы NTFS требуются учётная

запись компьютера хоста Hyper-V и учётная запись самого кластера (если хосты расположены в некотором кластере). Дополнительно администратор, создающий

или перемещающий все виртуальные машины должен иметь полный контроль на уровне совместных ресурсов и NTFS. Самый простой путь состоит в установке

правильных полномочий с помощью PowerShell, что просто в Windows Server 2012 R2. Это также можно сделать через Диспетчер Отказоустойчивого кластера в

совместных ресурсах горизонтально масштабируемых серверов. Следующая команда создаёт некую папку, а затем предоставляет этому компьютеру учётные записи

для полного контроля со стороны хостов Hyper-V

Дополнительно администратор, создающий

или перемещающий все виртуальные машины должен иметь полный контроль на уровне совместных ресурсов и NTFS. Самый простой путь состоит в установке

правильных полномочий с помощью PowerShell, что просто в Windows Server 2012 R2. Это также можно сделать через Диспетчер Отказоустойчивого кластера в

совместных ресурсах горизонтально масштабируемых серверов. Следующая команда создаёт некую папку, а затем предоставляет этому компьютеру учётные записи

для полного контроля со стороны хостов Hyper-V HV01 и HV02, а также

учётную запись HVCLUS для самого отказоустойчивого кластера, чтобы он также имел полный контроль. Отметим

символ $ после названий учётных записей компьютеров, который следует набирать. Кроме того, ещё и самому

администратору предоставляется полный контроль.

MD G:\VMStore

New-SmbShare -Name VMStore -Path G:\VMStore `

-FullAccess domain\administrator, `

domain\HV01$, domain\HV02$, domain\HVCLUS$

Set-SmbPathAcl -Name VMStore

Отметим, что в Windows Server 2012 cmdlet Set-SmbPathAcl был недоступен и соответствующие полномочия NTFS

приходилось устанавливать вручную, как это показано в следующей команде. Заметим, что это не требуется в

Windows Server 2012 R2, так как cmdlet

Заметим, что это не требуется в

Windows Server 2012 R2, так как cmdlet Set-SmbPathAcl копирует необходимые полномочия совместного ресурса в

файловую систему NTFS.

ICACLS G:\VMStore /Inheritance:R

ICACLS G:\VMStore /Grant ' "domain\administrator:(CI)(OI)F"

ICACLS G:\VMStore /Grant domain\HV01$:(CI)(OI)F

ICACLS G:\VMStore /Grant domain\HV02$:(CI)(OI)F

ICACLS G:\VMStore /Grant domain\HVCLUS$:(CI)(OI)F

Когда необходимые полномочия правильно установлены, определите тот совместный ресурс SMB, который нужен для расположения создаваемой ВМ или как

конечная цель миграции хранилища. Рисунок 4.16 показывает некую виртуальную машину, применяющую заданный совместный ресурс

\\savdalsofs\Virtuals для своего хранилища. Отметим, что не только этот диск хранится в данном хранилище, но

также и файлы конфигурации, файлы контрольной точки, а также файлы подкачки страниц. Имеется возможность применять другие местоположения для таких

различных аксессуаров виртуальной машины.

Имеется возможность применять другие местоположения для таких

различных аксессуаров виртуальной машины.

Ранее я говорил о назначении хранилища определённой виртуальной машине в виде виртуального жёсткого диска, что требует первоначального подключения самого хоста Hyper-V к такому хранилищу с последующим созданием в нём файлов VHDX. Существует тем не менее и иной способ предоставления хранилищ виртуальным машинам.

iSCSI является популярной альтернативой соединениям Fibre Channel, которые делают возможными подключения блочного уровня к хранилищу SAN

при помощи имеющейся сетевой инфраструктуры вместо требования целиком отдельной инфраструктуры (карт, кабелей, коммутаторов) исключительно

под хранилище. iSCSI работает посредством обработки традиционных команд SCSI поверх сетевых сред IP. Хотя и имеется возможность исполнения

iSCSI поверх обычной сетевой среды, если iSCSI применяется в качестве первичного сетевого транспорта, более распространённым является

наличие выделенного сетевого соединения для iSCSI чтобы обеспечить требуемую полосу пропускания или в идеале применять сетевые соединения более

крупного масштаба, такие как 10Gbps и использовать QoS чтобы гарантировать что iSCSI получит необходимый объём полосы пропускания.

В добавление к использованию iSCSI в Hyper-V для доступа к хранилищу, он также может использоваться внутри виртуальных машин как средство

предоставления хранилища, которое доступно самой виртуальной машине. Оно включает также хранилище, которое может быть доступно для соединения

со множеством виртуальных машин, что именуется как совместное хранилище shared

storage, что требуется во множестве сценариев,в которых внутри виртуальных машин реализуются кластеры, именуемые

гостевыми кластерами (guest clustering). Если вы намереваетесь

применять iSCSI внутри виртуальных машин, будет хорошей идеей иметь выделенную сетевую среду под iSCSI. Это требует создания отдельного

виртуального коммутатора в хостах Hyper-V, связываемых с сетевыми адаптерами, подключаемыми к тем адаптерам, которые выделяются под iSCSI, а затем

создавать в виртуальной машине некий дополнительный сетевой адаптер, подключаемый кэтому виртуальному коммутатору. Если обсуждаемое взаимодействие

iSCSI является важным в ваших делах, вы можете пожелать реализовать избыточные соединения. Это выполняется путём создания множества виртуальных

коммутаторов, подключаемых к различным сетевым адаптерам, созданием множества виртуальных сетевых адаптеров в таких виртуальных машинах (подключаемых

к создаваемым виртуальным коммутаторам), а затем использования MPIO внутри такой виртуальной машины. Я обсужу более подробно MPIO в разделе

Основы виртуального Fibre Channel. Не применяйте

группирование (teaming) NIC совместно с iSCSI, так как оно не поддерживается за исключением единственного сценария.

Если обсуждаемое взаимодействие

iSCSI является важным в ваших делах, вы можете пожелать реализовать избыточные соединения. Это выполняется путём создания множества виртуальных

коммутаторов, подключаемых к различным сетевым адаптерам, созданием множества виртуальных сетевых адаптеров в таких виртуальных машинах (подключаемых

к создаваемым виртуальным коммутаторам), а затем использования MPIO внутри такой виртуальной машины. Я обсужу более подробно MPIO в разделе

Основы виртуального Fibre Channel. Не применяйте

группирование (teaming) NIC совместно с iSCSI, так как оно не поддерживается за исключением единственного сценария.

Если у вас имеется сценарий совместного использования NIC (описанный в Главе 3), который

применяет различные сетевые адаптеры, которые собраны в группу при помощи решения группирования NIC Windows Server (причём это

должно быть решение группирования NIC, осуществляемое поставкой Windows в его установке), а эта группа NIC

затем имеет множество виртуальных сетевых адаптеров, создаваемых на уровне хоста для различных целей, одной из которых является применение iSCSI,

такое группирование NIC поддерживается. Но это единственный раз, когда оно может применяться под iSCSI.

Если у вас имеются выделенные под iSCSI сетевые адаптеры, тогда применяйте MPIO.

Но это единственный раз, когда оно может применяться под iSCSI.

Если у вас имеются выделенные под iSCSI сетевые адаптеры, тогда применяйте MPIO.