Windows 10 не видит внешний жесткий диск – что делать?

За счет высокой скорости и портативности внешние жесткие диски удобны для быстрого обмена большими объемами данных между компьютерами пользователей, не подключенными к одной локальной сети. Несмотря на то, что операционные системы и программная поддержка устройств часто обновляется, есть много случаев, когда компьютер не может его обнаружить. То есть Windows не отображает жесткий внешний диск в Проводнике, даже когда он виден в Диспетчере устройств. Эта проблема существует уже давно и есть много решений, позволяющих ее устранить.

Основные моменты

Иногда пользователи не могут получить доступ к внешнему диску по простым причинам. Потому в первую очередь выполните следующие инструкции:

- Часто проблема возникает при подключении к портам USB, расположенных на передней панели компьютера. Попробуйте подсоединить его к порту на задней панели.

- Подключение может не состоятся из-за поврежденного кабеля USB. Замените кабель и повторите попытку.

- Осмотрите накопитель на наличие физических повреждений.

- Если видите внешний диск в разделе Устройства и принтера, а в Диспетчере устройств он отсутствует, запустите процедуру переустановки драйвера путем удаления и последующей установки, которая автоматически запускается в ходе перезагрузки компьютера.

Обновление драйвера

Если драйвера устарели или повреждены, то могут возникнуть проблемы с доступом. Для ее решения обновите контроллер дискового пространства и съемный накопитель.

Перейдите в «Диспетчер устройств» командой devmgmt.msc из диалогового окна Win + R.

Разверните вкладку Дисковые устройства, правым щелчком мыши по внешнему жесткому диску разверните контекстное меню и выберите пункт «Обновить».

Проверьте доступ к интернету и выберите первый вариант автоматического поиска.

При обнаружении свежей версии, она будет автоматически установлена.

Затем этим способом обновите оборудование на вкладке Контроллеров запоминающих устройств, в частности, контроллера дискового пространства.

После перезагрузки компьютера подключите внешний жесткий диск и проверьте, видит ли его Windows.

Удаление драйвера

Если не удалось устранить проблему предыдущим способом, попробуйте переустановить драйвер. Для этого сначала удалите его, а затем обновите конфигурацию оборудования. В этом случае Windows при обнаружении оборудования, драйверы которого еще не установлены, инициирует их автоматическую установку.

Откройте Диспетчер устройств, как указано в первом решении. Раскройте вкладку Дисковые устройства, щелкните правой кнопкой на внешнем носителе и выберите «Удалить».

Затем разверните вкладку Контроллеры USB. Чтобы узнать к какому USB контроллеру подключен съемный носитель, щелчком мыши выделите Корневой USB концентратор. В меню Вид отметьте «Устройства по подключению».

Щелкните правой кнопкой на контроллер, к которому подключен накопитель, и выберите «Удалить».

После удаления перейдите в меню Действие и обновите конфигурацию оборудования. При обнаружении оборудования без драйверов, Windows автоматически их установит.

Теперь подключите съемный накопитель и проверьте, видит ли его система.

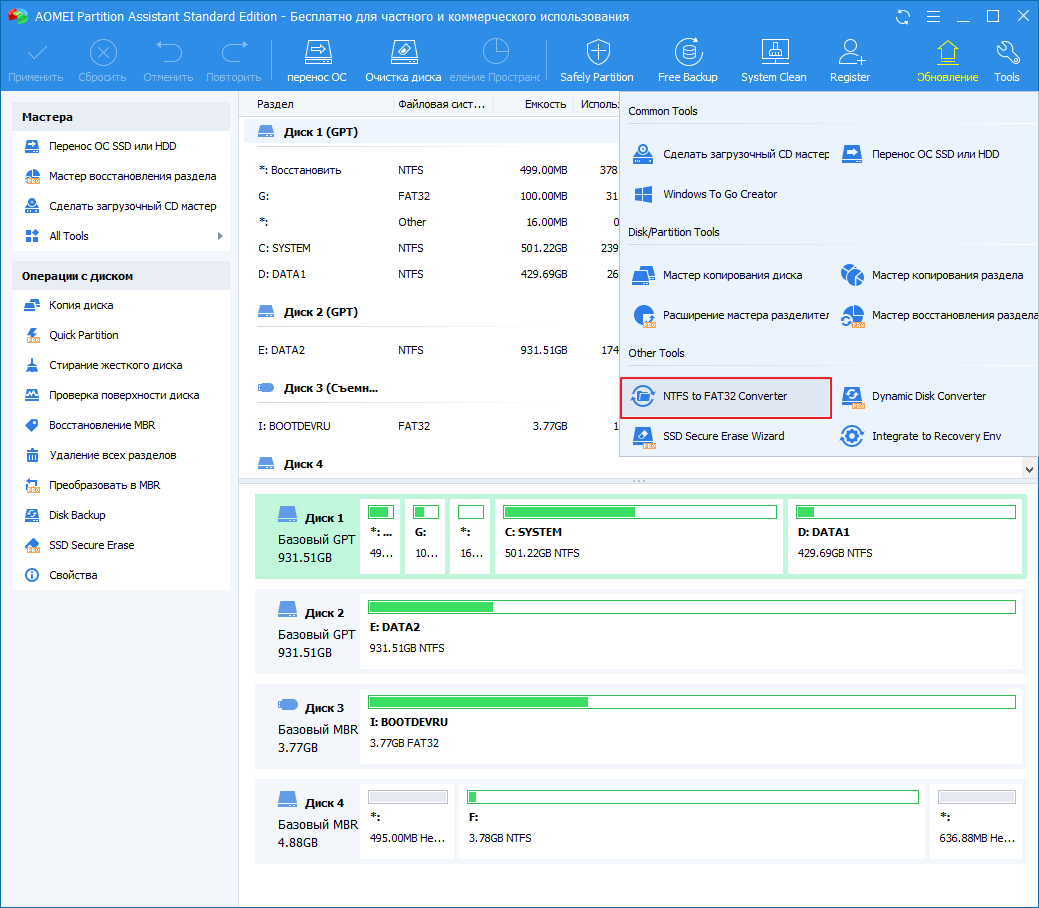

Изменение буквы диска

При подключении может возникнуть ситуация, когда буква внешнего жесткого диска конфликтует с той, которая уже зарезервирована системой для другого накопителя. В этом случае попробуйте ее изменить.

Для начала выключите компьютер и подключите съемный носитель. Если он препятствует загрузке системы, в настройках BIOS установите приоритет на загрузку с системного раздела с Windows.

В диалоговом окне Win + R выполните команду diskmgmt.msc.

Щелкните правой кнопкой мыши на съемном носителе и выберите «Изменить букву диска и пути».

Щелкните на кнопку «Добавить» (при пустом поле) или «Изменить».

В следующем окне щелкните на раскрывающий список и укажите новую букву. Примените изменения на «ОК».

Теперь подсоедините носитель и проверьте, если ли доступ к содержимому.

Включение скрытых или пустых дисков

В некоторых конфигурациях Windows не видит съемные носители из-за включенной опции, которая скрывает все пустые диски из Проводника. Чтобы ее отключить, следуйте инструкции.

Откройте командную строку от имени администратора с помощью системного поиска.

В консоли выполните команду:

set devmgr_show_nonpresent_devices=1

Сверните окно и перейдите в «Диспетчер устройств» командой devmgmt.msc из окна Win +R.

В меню Вид отметьте пункт «Показать скрытые устройства». Если есть возможность, задействуйте скрытое оборудование.

Если внешний жесткий диск не виден в Проводнике, выполните следующие действия:

В проводнике кликните на вкладку Вид и перейдите в Параметры – Изменить папку и параметры поиска.

Снимите флажок с опции скрывать пустые диски. Примените изменения и выйдите.

Контроллеры запоминающих устройств Windows 10 – info-effect.ru

На чтение 2 мин. Опубликовано

Привет ! Мы продолжаем разбирать операционную систему Windows 10 ! Сегодня вы узнаете как настроить параметры контроллеров запоминающих устройств на компьютере Windows 10. Вы сможете узнать состояния устройств, тип устройств. Сможете обновить драйвер устройства. Вы сможете узнать значения свойств устройств. Вы сможете узнать события устройств и т.д.

Чтобы открыть параметры устройства, внизу экрана слева откройте меню “Пуск”. В открывшемся окне нажмите на вкладку или значок “Параметры”.

Далее, на странице “Параметры” нажмите на вкладку “Устройства”.

Далее, на странице “Устройства”, внизу страницы, нажмите на вкладку “Диспетчер устройств”.

Далее, на странице “Диспетчер устройств” нажмите два раза на вкладку “Контроллеры запоминающих устройств”. У вас откроются вложения устройства. Нажмите два раза по вкладке устройства, чтобы открыть его свойства и параметры. Вам могут быть доступны следующие устройства:

– HaoZip Virtual Bus.

– Microsoft iSCSI инициатор.

– Контроллер дискового пространства (Microsoft).

Далее, в параметрах устройства вы можете настроить:

Общие:

– Вы можете узнать тип устройства.

– Изготовителя устройства.

– Размещение устройства.

– Состояние устройства.

Драйвер:

– Вы можете узнать поставщика драйвера.

– Дату разработки драйвера.

– Версию драйвера.

– Цифровую подпись.

– Сведения о файлах драйвера.

– Вы можете обновить драйвер.

– Вы можете откатить драйвер.

– Вы можете отключить устройство.

– Можно удалить драйвер.

Сведения:

– Вы можете узнать значения свойств устройства.

– Выберите свойство и вам автоматически покажут его значение.

– Например, вы можете узнать путь к экземпляру устройства, ИД оборудования, класс, имя INF устройства и т.д.

События:

– Вы можете узнать события, которые происходили с устройством.

– Вы можете узнать дату и время события.

– Вы можете узнать сведения событий.

– Можно посмотреть все события.

– В конце нажмите на кнопку – OK.

Остались вопросы ? Напиши комментарий ! Удачи !

| Полю | Сведения | Возможные значения |

| Резервное питание от аккумулятора | Модуль резервного питания от аккумулятора обнаруживается во время публикации, а результаты выводятся здесь. | Удаление Представить Примечание. это поле не подлежит изменению пользователем. |

| Объем оперативной памяти | ОПЕРАТИВная память кэш-памяти обнаруживается во время публикации, а результаты выводятся здесь. | 64M до 1 ГБ Примечание. это поле не подлежит изменению пользователем. |

| Режим кластера | Если адаптер используется в кластере, в этом поле должно быть указано значение Enabled (включено ). | Невозможно Пользу |

| Идентификатор инициатора | Если этот адаптер не является основным адаптером, используемым в кластере, в этом поле следует установить требуемый идентификатор SCSI. | от 1 до 30 7:00 |

| Частота перестроения | Это поле позволяет определить приоритет операции перестроения. Этот параметр позволяет выбрать количество системных ресурсов, предназначенных для перестроения неисправных дисковых накопителей. Более высокая процентная доля ускоряет работу с дисками, но может привести к ухудшению производительности системы. | от 0 до 100 составляет Примечание: Установка коэффициента перестроения равным 0 приведет к тому, что массив не будет перестроен. |

| Решение Flex RAID Поверфаил | Позволяет продолжить процесс реконструкции, когда система перезапускается после сбоя питания. Эта функция использует 2 МБ свободного пространства на логическом диске для перестроения и отслеживания процессов реконструкции. | Невозможно Пользу |

| Контроль сигнала | Это поле позволяет определить, как действует звуковая сигнализация. Возможные значения здесь отключены, и контроллер не введет состояние тревоги, активировано, где контроллер введет состояние тревоги и аудиблиное оповещение, и тишина, где контроллер введет состояние тревоги, но не аудибли оповещение. | Невозможно Пользу Действия |

| BIOS адаптера | Это поле позволяет определить, загружен ли дополнительно-ROM во время тестирования системы при включении BIOS. Если эта функция отключена, система управления BIOS адаптера не видна во время процедуры POST. Если подключенный массив является загрузочным томом, это поле должно быть активировано. | Невозможно Пользу |

| Установить заводские настройки по умолчанию | Это поле позволяет вернуть свойства адаптера в первоначальные заводские настройки. Конфигурация массива остается неизменной. | Нет Да |

| Алгоритм приведения | Приведение к диску означает способность контроллера определить размер подключенных физических дисков, а затем привести к увеличению объемов дискового пространства, доступного на минимальном накопителе. Приведение накопителя, реализованное в этих RAID-контроллерах Intel®, позволяет выбрать зарезервированное пространство для компенсации небольшого размера диска, который может быть добавлен позже. Этот параметр позволяет использовать 16 МБ, 256 МБ и емкость жесткого диска в 1 ГБ, чтобы оставаться неиспользуемыми. | Удаление 128-подходное 1-е способ |

| BIOS прекращает работу при возникновении ошибки | Это поле позволяет определить поведение установленной системы при возникновении ошибки RAID при ВКЛЮЧЕНии BIOS. Возможны значения, прикотором система прекращает процесс POST, когда обнаруживаются ошибки RAID, и в этом случае, когда процедура POST в BIOSпродолжает работу после любых ошибок RAID. | Нет Вход |

| BIOS отображает сообщения | Это поле позволяет определить видимость сообщений об ошибках RAID. Возможны значения, вкоторых сообщения об ошибках выводятся в BIOS POST и выключаются, где сообщения об ошибках отображаются только в пользовательском интерфейсе. | Нет Вход |

| BIOS Конфигаутоселектион | Это поле позволяет устранять несоответствующие конфигурации RAID, определяя, где находилась конфигурация RAID. Среди возможных значений — это пользователь, в котором конфигурация RAID строится на основе конфигурации, настроенной в течение текущего сеанса пользовательского интерфейса, NVRAM, где конфигурация RAID строится на базе памяти адаптера и диска, где конфигурация RAID взята из конфигурации on disk. | Дисковод ПАМЯТИ Описан |

| Параметры спинуп | Это поле позволяет определить, сколько жестких дисков одновременно вращается в один момент времени. Задание для этого поля значения, которое отличается от «авто», приведет к ускорению передачи данных, но может потребоваться в системах с большим количеством накопителей, где эти накопители постоянно встречаются. | Автоматически 2 за 6 сек. 4 за 6 сек. |

| Быстрая инициализация | Инициализирует логический диск, записывая нули в первый сектор логического диска. Быстрая инициализация завершится через 3 секунды. Стандартная инициализация записывает нули во весь логический диск и занимает больше времени. | Невозможно Пользу |

| Задержка PCI, провод | Это поле позволяет управлять стандартной функцией PCI 2,1. Все возможные значения отключены, и контроллер не может освободить шину PCI до завершения транзакции и включения, где шина PCI может быть освобождена для других устройств в процессе выполнения операции контроллера. | Невозможно Пользу |

| Автоматическая перестроение | Включает встроенное по для запуска операции перестроения, когда неисправный физический диск заменяется другим диском в том же разъеме. Эта функция отличается от функции горячего резервирования. Диск горячего резервирования автоматически используется системой для перестроения массива без какого-либо вмешательства оператора. Напротив, функция Auto rebuilding позволяет перестраивать массив только после замены неисправного накопителя. Диск горячего резервирования автоматически используется системой для перестроения массива без какого-либо вмешательства оператора. Напротив, функция Auto rebuilding позволяет перестраивать массив только после замены неисправного накопителя. | Невозможно Пользу |

| Режим эмуляции класса | Тип BIOS адаптера определяется в POST и отображается здесь. | Массовая система хранения Примечание. это поле не подлежит изменению пользователем. |

Как устроен Storage Spaces

Storage Spaces в Windows Server 2012 R2Как устроен Storage Spaces

Storage Spaces

Термины

- Storage pool (пул хранения) — набор физических дисков. В одном пуле могут находится диски, отличающиеся по объёму, производительности и интерфейсу подключения.

- Virtual disk (виртуальный диск) — термин для определения логический том в Storage Spaces. Для создания виртуального диска используется ёмкость выбранного дискового пула. При этом доступны несколько вариантов отказоустойчивости (их можно комбинировать в пределах одного пула), большинство из которых являются аналогами традиционных RAID-массивов различных уровней.

- Simple (простой) — аналог RAID-0. Поток данных разбивается на страйпы (по умолчанию размером в 256КиБ), которые распределяются по дискам в пуле.

- Mirror (зеркальный): для каждого страйпа в зеркальном виртуальном диске записывается дополнительно одна (двойное зеркало, 2-way mirror) или две (тройное зеркало, 3-way mirror) копии. Аналогом в плане использования ёмкости дисков для двойного зеркала является RAID-10 (или 1E для нечётного числа дисков). Зеркальный ВД защищён от потери одного или двух дисков соответственно.

- Parity (виртуальный диск с контролем чётности): запись страйпов на диски чередуется с записью контрольной суммы. В Windows Server 2012 R2 появились диски с двойной чётностью (dual parity), в которых дополнительно пишется вторая контрольная сумма. Как и аналогичные RAID-5 и RAID-6 ВД с контролем чётности допускают потерю одного или двух дисков соответственно и обеспечивают минимальную потерю дискового пространства (-1 или -2 диска соответственно). Традиционным недостатком любых реализаций томов с контрольными суммами является низкая производительность на запись из-за необходимости модификации всего полного страйпа вместе с контрольными суммами. Отсутствие фиксированного размещения страйпов в Storage Spaces и RAM-кэша на контроллере (используются обычные HBA) усугубляет данную проблему, сравнение производительности ВД single parity и dual parity с RAID-5 и RAID-6 будет ниже.

- Simple (простой) — аналог RAID-0. Поток данных разбивается на страйпы (по умолчанию размером в 256КиБ), которые распределяются по дискам в пуле.

- В Windows Server 2012 R2 появился функционал enclosure awareness: при размещении страйпов учитывается размещение дисков по различным дисковым полкам (SAS JBOD’ам) для получения отказоустойчивости на уровне дисковых полок. Например, ВД с двойным зеркалированием (2-way mirror), размещенный на трёх дисковых полках, допускает потерю одной дисковой полки целиком.

-

Параллельность распределения страйпов в виртуальном диске определяется числом т.

н. столбцов (columns). Для получения максимальной производительности число столбцов для виртуальных дисков с уровнем отказоустойчивости simple и parity должно соответствовать количеству физических дисков, но в настройках по умолчанию максимальное число столбцов, например, для simple равно 8. Это связано с особенностями механизма расширения ёмкости пула: для оптимального использования ёмкости число добавляемых дисков должно соответствовать максимальному числу столбцов, которое используется виртуальными дисками, а для зеркальных дисков — числу столбцов * числу копий страйпа (2 для 2-way mirror, 3 для 3-way mirror).

н. столбцов (columns). Для получения максимальной производительности число столбцов для виртуальных дисков с уровнем отказоустойчивости simple и parity должно соответствовать количеству физических дисков, но в настройках по умолчанию максимальное число столбцов, например, для simple равно 8. Это связано с особенностями механизма расширения ёмкости пула: для оптимального использования ёмкости число добавляемых дисков должно соответствовать максимальному числу столбцов, которое используется виртуальными дисками, а для зеркальных дисков — числу столбцов * числу копий страйпа (2 для 2-way mirror, 3 для 3-way mirror).

- Storage tiers (ярусное хранение данных). В Windows Server 2012 R2 появилась поддержка 2-ярусного (SSD и HDD) размещения данных на виртуальных дисках Storage Spaces. Приоретизация доступа к быстрому ярусу из SSD возможна путём управления ёмкостью (при создании ВД указываются комбинация объёмов SSD и HDD ярусов) либо на файловом уровне: необходимый файл можно привязать к SSD-ярусу для обеспечения гарантированной производительнности.

- Write-back cache (кэш на запись). Для компенсации низкой производительности на случайную запись небольшая часть SSD в пуле используется для кэширования записи. При этом оставшаяся часть ёмкости SSD может быть использована для ярусного хранения.

Ограничения

Количество дисков и ёмкость:

- До 240 дисков одном пуле (в Windows Server 2012R2, ранее — до 160-ти), но пулов может быть несколько.

- До 80-ти дисков в кластеризованном пуле, до 4-х пулов на кластер.

- До 64-х виртуальных дисков в одном пуле.

- Общая ёмкость пула — до 480ТиБ.

| Тип ВД | Минимальное число столбцов | Соотношение столбцы/диски | Минимальное число дисков | Максимальное число столбцов |

| Simple (простой) | 1 | 1:1 | 1 | - |

| Two-way mirror (двойное зеркало) | 1 | 1:2 | 2 | - |

| Three-way mirror (тройное зеркало) | 1 | 1:3 | 5 | - |

| Single parity (одиночная чётность) | 3 | 1:1 | 3 | 8 |

| Dual parity (двойная чётность) | 7 | 1:1 | 7 | 17 |

Прочее

- Виртуальный диск Storage Spaces не может использоваться в качестве загрузочного.

- Для Storage Spaces можно использовать только диски с интерфейсами SAS, SATA и USB. Тома, презентуемые RAID-контроллерами; тома iSCSI, FC и прочие не поддерживаются.

Требования при использовании в кластере

- Нельзя использовать «тонкие» диски, допускается только фиксированное выделение ёмкости (fixed provisioning).

- Минимальное количество дисков для двойного зеркала — 3, для тройного зеркала — 5.

- В кластере можно использовать ВД с Parity, но только начиная с Windows Storage Server 2012 R2

- Используемые диски — только SAS с поддержкой SPC (SCSI persistent reservation). Многие ранние SAS-диски не поддердивают SPC. Аналогичное требование существует и для LSI Syncro CS.

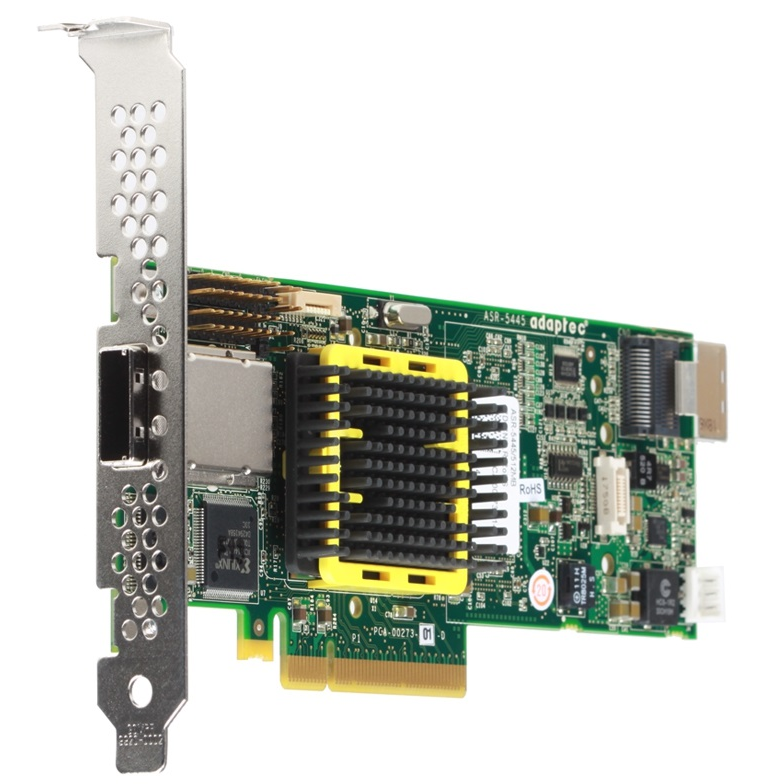

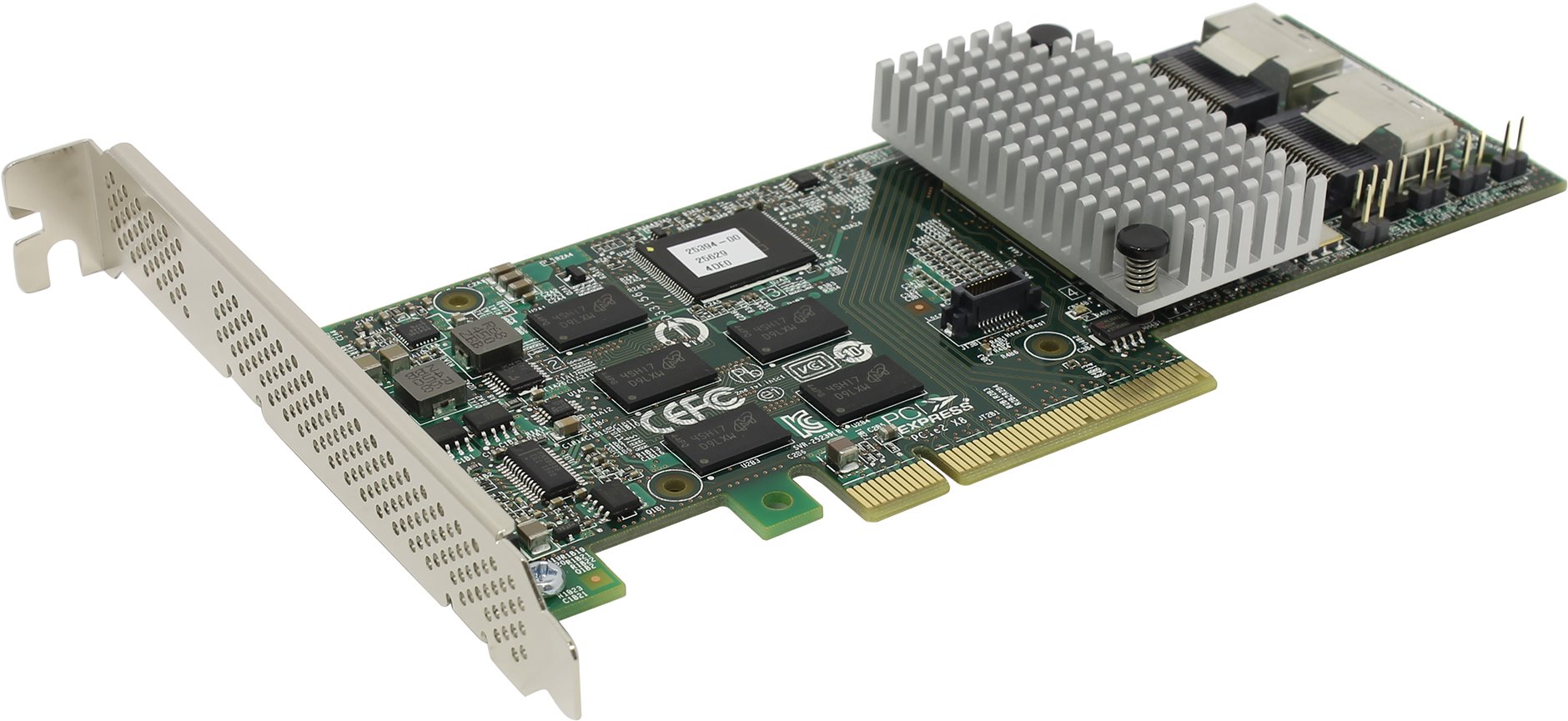

Storage Spaces в кластерах

Одна из самых востребованных возможностей Storage Spaces — использование в failover-кластере Windows. Архитектура решения предельно проста: требуются диски SAS (см. дополнительные требования к дискам и организации томов), SAS JBOD (дисковая полка) с двумя SAS-экспандерами и минимум двумя разъемами для подключения к каждому из экспандеров (для двухузлового кластера). На серверах в качестве контроллеров используются обычные SAS HBA. Мы рекомендуем LSI (любые SAS2 и SAS3 HBA с внешними портами, например LSI 9207-8e), но можно использовать и Adaptec серий 6H и 7H.

Минимальной конфигурация выглядит так: два сервера, в каждом из них двухпортовый SAS HBA с подключением к 2-экспандерному SAS JBOD’у на базе корпуса Supermicro и SAS диски.

Для использования в качестве SAS JBOD’а можно использовать любой корпус Supermicro с двумя экспандерами (E26 или E2C в наименовании для SAS2 и SAS3 соответственно). Каждый экспандер в корпусах Supermicro имеет минимум два разъема x4 SAS (SFF-8087 или SFF-8643), которые можно использовать в качестве входов. При наличии третьего разъема его можно использовать для каскадирования (подключения дополнительных дисковых полок) или для построения топологии с тремя узлами в кластере.

Существуют варианты в одном корпусе, т.н. Cluster-in-a-box (CiB): готовые комплекты SSG-6037B-CIB032 и SSG-2027B-CIB020H на базе Supermicro Storage Bridge Bay с предустановленным Windows Storage Server 2012 R2 Standard, которые отлично подходят для построения отказоустойчивых файловых и/или iSCSI серверов:

Производительность

Решение на базе Storage Spaces может масштабироваться до более чем миллиона IOPS при использовании SSD и зеркальных томов. Но производительность на запись в Parity и Dual Parity по-прежнему оставляет желать лучшего, и такие конфигурации без write-back кэша на SSD подходят лишь для узкого круга задач с преимущественной нагрузкой на чтение.

Всестороннее исследование производительности Storage Spaces в разных конфигурациях было проведено компанией Fujitsu. В нашей тестовой лаборатории мы повторили некоторые из этих тестов, дополнив измерение IOPS и пропускной способности значениями средней и максимальной задержек.

Условия тестирования

- Два процессора E5640

- 8GB RAM

- Системная плата Supermicro X8DTL-iF

- Контроллер Adaptec 6805 (тесты с аппаратным RAID), кэш на чтение включен, кэш на запись включен

- Контроллер LSI 9211-8i (тесты со Storage Spaces, прошивка P19 IT

- Диски HGST HUA723030ALA640 (3ТБ 7200об/мин SATA3): 12шт для тестов RAID-10 vs Storage Spaces 2-way mirror и 13шт для тестов RAID-6 vs Storage Spaces dual parity

- 2шт SSD Intel 710 100ГБ для тестов с tiering’ом и write-back кэшом

- Microsoft Windows Server 2012 R2 Standard

- Для генерации нагрузки применялся FIO версии 2.1.12

1. Для всех замеров использовался тестовый файл объёмом 100ГиБ, кроме тестов с ярусным хранением, где использовался файл объёмом 32ГиБ.

1. Для всех замеров использовался тестовый файл объёмом 100ГиБ, кроме тестов с ярусным хранением, где использовался файл объёмом 32ГиБ.Для наглядности использовались шаблоны аналогичные использованным в тестах от Fujitsu:

| Шаблон | Доступ | Чтение | Запись | Размер блока, КиБ |

| File copy | случайный | 50% | 50% | 64 |

| File server | случайный | 67% | 33% | 64 |

| Database | случайный | 67% | 33% | 8 |

| Streaming | последовательный | 100% | 0% | 64 |

| Restore | последовательный | 0% | 100% | 64 |

Результаты

RAID-10 vs Storage Spaces 2-way mirror

Сравнивались: RAID-10 из 12-ти дисков на контроллере Adaptec 6805, 2-way mirror из 12-ти дисков (6 столбцов), 2-way mirror из 12-ти дисков с 2ГиБ write-back кэшом на двух SSD Intel 710 и ярусным хранением — SSD-tier’ом из тех же объёмом в 40ГБ (40ГБ SSD + 200ГБ HDD).

Шаблоны Database (IOPS), File copy, File Server (пропускная способность). Для шаблона Database используется логарифмическая шкала. По графикам видно, что 2-way mirror заметно уступает в производительности традиционному аппаратному RAID-10: в два с лишним раза на шаблонах Database и File copy, примерно в 1,5 раза на шаблоне File Server. Выравнивание результатов с ростом глубины очереди больше 16-ти нельзя рассматривать с точки зрения практического использования из-за неприемлемого роста задержек (графики ниже). Серьезный рост производительности обеспечивает использование SSD в качесте кэша на запись и быстрого яруса. Всего пара даже устаревших на сегодняшний день Intel 710 поднимает производительность на случайном доступе малыми блоками на порядок. Есть смысл использовать такое сочетание не только для OLTP, но и для нагруженных файловых серверов.

Серьезный рост производительности обеспечивает использование SSD в качесте кэша на запись и быстрого яруса. Всего пара даже устаревших на сегодняшний день Intel 710 поднимает производительность на случайном доступе малыми блоками на порядок. Есть смысл использовать такое сочетание не только для OLTP, но и для нагруженных файловых серверов.

RAID-6 vs Storage Spaces dual parity

Сравнивались: RAID-6 из 13-ти дисков на контроллере Adaptec 6805 и Dual Parity из 13-ти дисков (13 столбцов). К сожалению, у нас не оказалось минимально требуемого для использования в таком пуле количества SSD аналогичных использованным в первой серии тестов — для Dual Parity их нужно минимум три. Но соответствующее сравнение производительности с SSD tier’ом и кэшированием записи есть в вышеупомянутом исследовании Fujitsu.

Шаблоны Database (IOPS), File copy, File Server (пропускная способность). Storage Spaces с Dual Parity существенно отстаёт от аппаратного RAID во всех сценариях со случайным доступом. Это не удивительно с учётом того, что в распоряжении Adaptec 6805 есть 512МБ RAM-кэша, что позволяет существенно оптимизировать неудобный для RAID-6 доступ на случайную запись. Среди тестов, проведённых Fujitsu, есть вариант «RAID-6 8xHDD против Dual Parity 8xHDD + 1ГБ WB кэша на 3xSSD» — на всех трёх шаблонах производительность при добавлении WB-кэша на SSD не уступает аппаратному RAID, причём без использования ярусного хранения.

Шаблоны Database, File copy, File Server: средняя задержка. Шаблоны Database, File copy, File Server: максимальная задержка. Ситуация аналогична предыдущей серии тестов с зеркальным Storage Spaces. При более высокой средней задержке Storage Spaces демонстрирует более стабильные значения — максимумы при небольшой глубине очереди меньше на шаблонах Database и File copy. Шаблоны Streaming, Restore: пропускная способность. Dual Parity хорошо справляется с чтением, но с последовательной записью наблюдается давно известная катастрофическая ситуация с отставанием более чем на порядок. Использование даже большого по объёму write-back кэша (можно выделить диски целиком, присвоив диску Usage=Journal) на нескольких SSD может на какое-то время компенсировать относительно кратковременные нагрузки на запись, но при непрерывной записи (например, при использовании в системе видеонаблюдения) кэш рано или поздно будет заполнен. Шаблоны Streaming, Restore: средняя задержка. Для шаблона Restore используется логарифмическая шкала. Шаблоны Streaming, Restore: максимальная задержка (логарифмическая шкала).Преимущества и недостатки Storage Spaces

Преимущества

- Снижение затрат на оборудование.

Для простых проектов с одиночным сервером: SAS HBA или чипсетный контроллер вместо аппаратного RAID-контроллера; возможность использовать недорогие диски SATA, формально не совместимые с аппаратными RAID (например, WD Red) вместо дисков nearline класса.

Для проектов с одиночной неотказоустойчивой СХД и большими требованиями к плотности размщениния дисков можно использовать такие платформы (72 диска в 4U, до 432ТБ сырой ёмкости при использовании 6ТБ дисков):

Для кластерных решений: простые дисковые полки (SAS JBOD’ы) вместо дорогостоящих СХД.

- Высокая производительность. Решение на базе Storage Spaces и SSD легко масштабируется по пропускной способности и IOPS путём добавления дисковых полок и HBA вплоть до нескольких миллионов IOPS и десятков ГБ/с. Сравнительно невысокая производительность обычных HDD может быть компенсирована применением ярусного хранения с размещением «горячих» данных на SSD и/или использованием SSD для кэширования операций записи.

Использование tiering’а (ярусного хранения) в сочетании с кэширование записи на SSD в Storage Spaces в большинстве случаев работает эффективнее, обходится дешевле и имеет большие пределы масштабирования в сравнении с реализацией SSD кэша на аппаратных RAID-контроллерах (например, LSI CacheCade или Adaptec MaxCache).

- Гибкое использование дискового пространства. В Storage Spaces можно комбинировать на одной дисковой группе (в одном пуле) тома с любым уровнем отказоустойчивости, при добавлении в пул SSD — с любым соотношением ёмкости между HDD- и SSD-ярусами и/или ёмкостью write-back кэша.

Для всех видов томов, за исключением использования в кластере, томов с ярусным хранением и томов Dual Parity поддерживается Thin Provisiong (тонкое выделение ресурсов) — это позволяет выделять ёмкость только по мере реального использования.

Недостатки

- Низкая производительность на запись при использовании обычных HDD, особенно в Parity и Dual Parity

Определенный тип нагрузки на запись (случайный доступ небольшими блоками, сосредоточенный в определённой области) может быть легко компенсирован добавлением SSD в качестве быстрого яруса и кэша на запись.

Но продолжительную линейную нагрузку на запись компенсировать не получится, так что рекомендовать использование Storage Spaces, например, для видеонаоблюдения нельзя.

Но продолжительную линейную нагрузку на запись компенсировать не получится, так что рекомендовать использование Storage Spaces, например, для видеонаоблюдения нельзя.

Для бюджетных кластерных решений под Windows (с похожей архитектурой на базе SAS JBOD) с высокой нагрузкой на запись мы советуем использовать вместо Storage Spaces специальные RAID-контроллеры LSI Syncro CS.

- Ограниченное масштабирование кластера. Для использования Storage Spaces в кластере необходим совместный доступ к дискам через дисковую полку с двумя SAS-экспандерами (SAS JBOD). SAS JBOD не является отдельной самостоятельной СХД, поэтому кластер с использованием Storage Spaces может состоять максимум из 4-х узлов (необходим специальный SAS JBOD с 4-мя входами на каждый экспандер), а в типовых конфигурациях с SAS JBOD Supermicro — максимом из 3-х узлов (или 2-х при необходимости подключать дополнительные JBOD’ы каскадом).

Советы по оптимальному использованию Storage Spaces

- При использовании в кластере используйте только SAS HDD и SSD, избегайте использования SATA дисков с дополнительными интерпозерами.

- При создании виртульных дисков учитывайте число т.н. столбцов. Данный параметр может очень сильно влиять на производительность. Нестандартное число столбцов можно задать только при использовании PowerShell. Использование большего числа столбцов повышает производительность, но накладывает ограничение на добавление дисков в пул.

Пример (виртуальный диск Dual Parity, 13 столбцов, 1000ГиБ, Fixed Provisioning):

New-VirtualDisk -StoragePoolFriendlyName Pool1 -FriendlyName VD02 -ResiliencySettingName Parity -NumberOfColumns 13 -PhysicalDiskRedundancy 2 -Size 1000GB -ProvisioningType Fixed - Избегайте использования виртуальных дисков Parity и Dual Parity при наличии большой нагрузки на запись и/или случайного доступа малыми блоками.

- Одним из самых востребованных на сегодня решений является небольшой 2-узловой кластер для Hyper-V. Из-за конкурентного обращения нескольких ВМ достаточно высокий процент нагрузки на дисковую подсистему будет состоять из случайного доступа. При расчёте дисковой подсистемы планируйте использование зеркальных виртуальных дисков (2-way mirror — стандартное двойное зеркалирование, для особых сценариев можно использовать тройное), производительность Parity и Dual Parity будет достаточно только для архивных данных. Планируйте использование минимум двух SSD для tiering’а и кэширования записи.

- Избегайте добавления дисков с разной производительностью (например, HDD 7200 и 10000 об/мин) в общий пул либо создавайте виртуальные диски только из HDD с одинаковой производительностью, выбирая их вручную в GUI или через параметр

-PhysicalDisksToUseпри создании через PowerShell. Диски SSD должны быть либо вынесены в отдельный пул, либо использоваться совместно с HDD только в качестве быстрого яруса и/или write-back кэша.

Ссылки

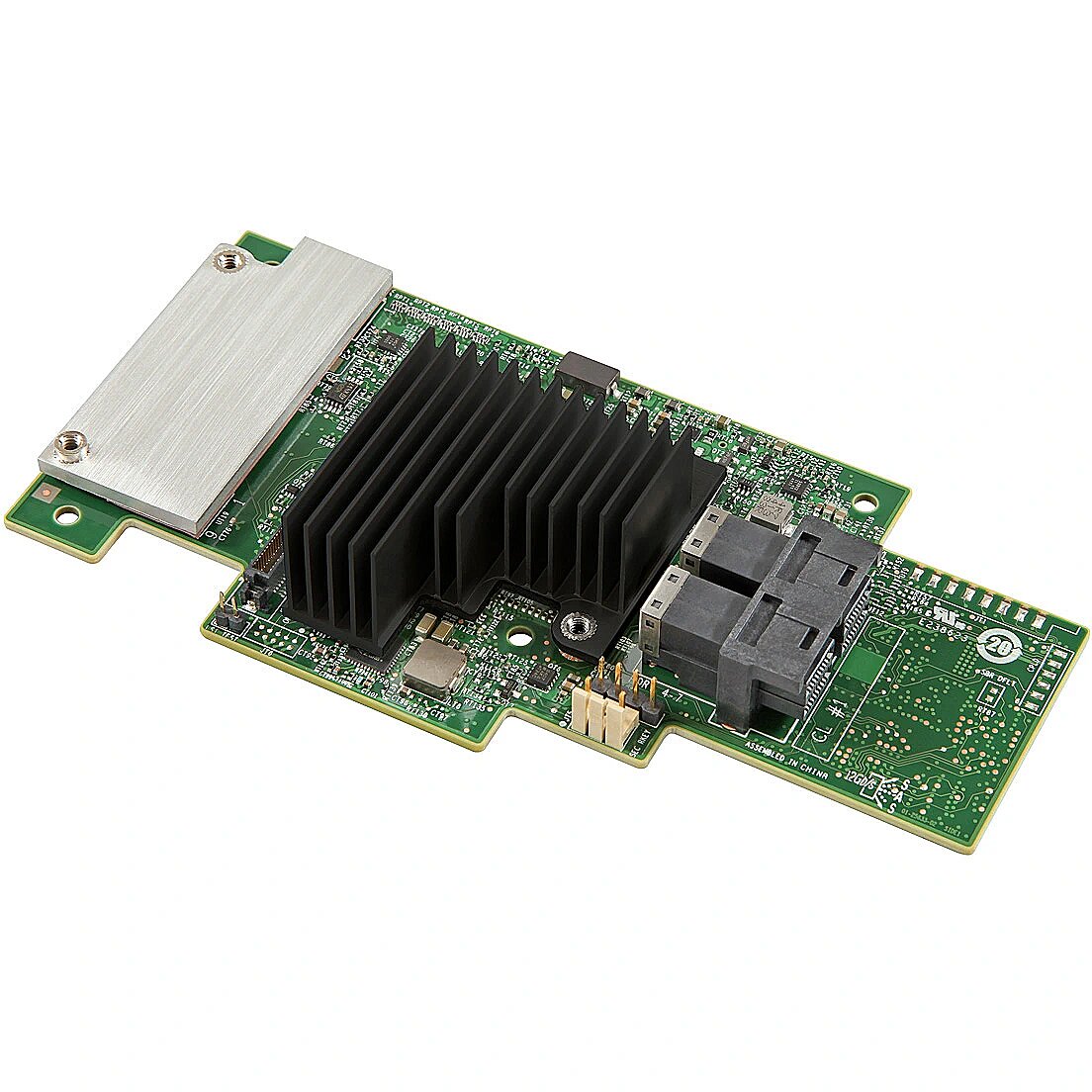

Дисковые контроллеры: предназначение и ключевые особенности

В этой статье речь пойдет о дисковых контроллерах и их вариациях.Сложность выбора заключается в том, что кроме того, что контроллеры бывают с интерфейсами SATA и SAS, так они еще выпускаются в трех вариантах функционала: RAID-контроллер, HBA и Expander. Давайте разбираться.

Рассмотрим тиры интерфейсов

SATA – наследник или следующая ступень развития IDE интерфейса и расшифровываемый как Serial Advanced Technology Attachment (последовательная технология подключения). К слову, IDE после появления SATA, сначала переименовали в ATA, а затем в PATA — Parallel Advanced Technology Attachment (параллельная технология подключения). Так же SATA и унаследовал свой сегмент применения — домашние-офисный сегмент. Не полностью, конечно, есть и энтерпрайз sata диски, но общее позиционирование интерфейса – все-таки ближе к рядовому потребителю, чем к корпоративному.

SAS – тоже наследник прошедшего поколения, но полностью корпоративного сектора. При этом своим появлением он не заставил никого переименовываться, а уже в своем имени несет наследственность «родителя» и расшифровывается как Serial Attached SCSI.

Остановимся немного на втором типе интерфейса, поскольку он для нас более профильный и в отличии от домашнего сегмента обладает рядом интересных особенностей.

Обратная совместимость с SATA: к любому SAS устройству можно подключить SATA диск, так что не стоит волноваться о доступности информации на SATA дисках, если в систему планируется добавить SAS контроллер. Главное не подключайте к контроллеру мобильные и домашние диски из-за их особенности определения времени наработки.

Дело в том, что по умолчанию SAS-контроллер все время будет держать диск в активном состоянии — посылать нулевые и контрольные пакеты и в случае превышения времени ответа помечать диск, как неисправный.

Работа по MAC-адресу: в отличии от SATA диска, SAS диски имеют каждый свой персональный mac-адрес, как любая сетевая карта. Связанно это с объемом дисков в одной связанной системе: SAS контроллер способен оперировать 16384 устройствами.

Если вы собрали два массива из четырех SATA дисков силами домашней материнской платы или простого SATA контроллера, а затем поменяли местами диски из разных массивов – система закономерно отрапортует вам о разрушении обоих массивов.

В случае с SATA система оперирует только адресным портами нахождением диска относительно контроллера, т.е. диски 00 и 01 это первый массив, а 02 и 03 это второй. Касаемо же SAS структуры — контроллер всегда оперирует адресом самого диска, а не его расположением относительно порта контроллера.

Так что, даже если вы переставите диск не только в соседний разъем, а вообще в соседнюю дисковую полку, подключенную к этому же контроллеру, с точки зрения системы вообще не произойдет ничего внештатного. Все диски доступны, все работает штатно.

Что же касается типов контроллеров по функционалу:

Начнем с самого простого по функциональности – SAS Expander (экспандер)

Это не совсем контроллер в типичном понимании этого слова. Задача экспандера – расширение дисковой подсистемы. Действует он аналогично обычному разветвителю, позволяет подключить к контроллеру дополнительные диски.

Задача экспандера – расширение дисковой подсистемы. Действует он аналогично обычному разветвителю, позволяет подключить к контроллеру дополнительные диски.

При этом хоть и занимая 1 единицу адресного пространства в топологии, но обеспечивая прозрачность подключения. Другими словами, экспандеру не нужны драйвера, только питание. Ни каких настроек у экспандера нет и никакого управления дисками не предусматривается.

Еще одна тонкость, у экспандера нет входящих, исходящих и приоритетных портов. А из-за того, что SAS-контроллеры работают адресно, можно не бояться петель и параллельных подключений, на топологии, функционале и скорости это никак не скажется.

Вторая важная особенность, через экспандер можно подключать SATA диски к SAS контроллеру, а вот к SATA контроллеру не получится, т.к. сам экспандер является SAS-устройством.

SAS HBA – он же Host Bus Adapter (Адаптер главной шины)

Как и экспандер выполняет задачу по расширению дисковой подсистемы, но в отличие от него осуществляет подключение к системе SAS устройств, если изначально система не располагает этим интерфейсом. Как и в случае со SCSI, SAS интерфейс используется не только дисками, но и внешними устройствами, например, ленточными библиотеками, стримерами или дисковыми полками.

В отличие от экспандера HBA работает через драйвер и может предлагать простейший функционал по настройке подключенного массива дисков, как правило это объединение дисков в 0, 1, 10 уровень или организацию JBOD, когда данные пишутся последовательно на все доступные диски. С точки зрения системы JBOD — это просто один диск, размер которого увеличивается, когда к HBA подключается новый диск и назначается входящим в данную группу.

SAS RAID – самый «продвинутый» вариант контроллера. Он обладает возможностями всех вышеперечисленных типов, но имеет высокопроизводительный процессор для выполнения более сложных операций. Рейд контроллер конечно же, как и HBA, требует установку драйвера.

Так же, как и HBA, может объединять диски в 0, 1, 10, JBOD массивы, но в отличии от HBA способен работать с массивами 5, 6, 50 и 60 уровней и обеспечивать на порядок большую производительность на операциях ввода/вывода.

К сожалению, в отличии от предыдущих «собратьев», хоть рейд контроллер и несет на себе только пассивный радиатор, но он строго нуждается в обдуве. Как и говорилось в статье о режимах эксплуатации, если устройство не имеет активного охлаждения, это не значит, что ему не нужен обдув.

Дисковые пространства в Windows 8.1 и 10

Привет, друзья. У нас на сайте есть небольшая коллекция статей, посвящённая реализации на компьютере RAID-массива. В этих статьях мы рассматривали, как настроить аппаратный RAID средствами материнских плат и программный RAID средствами штатной технологии динамических дисков Windows. Но как-то я упустил из виду другую штатную технологию реализации программного RAID в среде Windows – технологию дисковых пространств. А эта технология появилась ещё в версии Windows 8 и перекочевала в Windows 8.1 и 10. Технология дисковых пространств являет собой современную альтернативу динамическим дискам и позволяет использовать для RAID-массива отказоустойчивую файловую систему ReFS. Давайте, друзья, разберёмся в функционале дисковых пространств Windows 8.1 и 10 и создадим отказоустойчивый RAID-массив с ReFS.Дисковые пространства вWindows 8.1 и 10 — программный RAID с поддержкой файловой системы ReFS

Что такое дисковые пространства в системах Windows 8.1 и 10

Итак, штатная функция реализации программного RAID – дисковые пространства. Она позволяет создавать пользовательские разделы диска с конфигурациями:

RAID 0 (удвоенная производительность),

RAID 1 (отказоустойчивость),

RAID 1E (повышенная отказоустойчивость + удвоенная производительность),

RAID 5 (отказоустойчивость + удвоенная производительность, но только при чтении данных).

С этой технологией можно использовать как внутренние жёсткие диски, так и внешние, подключаемые по USB. В отличие от технологии динамических дисков, которая позволяет применять конфигурации RAID для системного раздела Windows, технология дисковых пространств предусматривается только для несистемных разделов, где хранятся наши пользовательские данные.

С этой технологией можно использовать как внутренние жёсткие диски, так и внешние, подключаемые по USB. В отличие от технологии динамических дисков, которая позволяет применять конфигурации RAID для системного раздела Windows, технология дисковых пространств предусматривается только для несистемных разделов, где хранятся наши пользовательские данные.Для диска С, друзья, использовать дисковое пространство нельзя. Да и не нужно это, ну сами посудите, зачем? Зеркалируй, не зеркалируй Windows, а всё равно нужно периодически делать её бэкапы, чтобы иметь возможность откатиться при системном сбое или иных неполадках. И что проку от упавшей системы на диске-зеркале? Просто не нужно хранить на диске С личные данные, а если они хранятся в папках профиля типа «Видео», «Изображения», «Документы» и т.п., то для этих папок в их свойствах можно сменить расположение и указать таковое на несистемных разделах. В качестве которых, кстати, можно использовать и разделы, сформированные с использованием технологии дисковых пространств.

Важно: для постановки в пул и создания впоследствии дискового пространства нужны чистые жёсткие диски или с ненужными данными. Все диски очищаются от данных, и созданное из этих дисков пространство форматируется как обычный новый раздел диска. Т.е., друзья, если вы создадите пул, всё данные, хранящиеся на дисках, поставленных в этот пул, будут удалены. Учтите этот момент.

Ну а теперь давайте посмотрим, как работает технология дисковых пространств на примере создания отказоустойчивого дискового пространства с конфигурацией RAID 1 и файловой системой ReFS. Вот, как видим в управлении дисками Windows, у меня есть диск 0 с операционной системой. И есть ещё два диска – Диск 1 и Диск 2, они примерно одинакового объёма: один 60 Гб, другой – 70 Гб. Поставим их работать в паре.

Создание дискового пространства

В панели управления Windows 8.1 или 10 в поле поиска вписываем запрос «дисковые пространства». И запускаем эту системную функцию.

Непосредственно на страничке этой функции жмём «Создать новый пул и дисковое пространство».

Друзья, кто не знает, пул носителей – это связка определённых жёстких дисков, объединённых единой политикой управления. Пул являет собой основу дискового пространства, т.е. RAID-массива. Добавленные в пул жёсткие диски больше не будут доступны для использования их пространства в отдельности, только в рамках сконфигурированного массива. И вот нам нужно создать пул носителей, добавив в него минимум два жёстких диска. В пул не может быть добавлен диск, на котором установлена используемая Windows. Добавляем и жмём «Создать пул».

Пул готов. Теперь создаём дисковое пространство. Как упоминалось, мы будем создавать отказоустойчивый массив с конфигурацией RAID 1 с файловой системой ReFS. И вот в форме создания дискового пространства указываем эту файловую систему, тип устойчивости выбираем «Двухстороннее зеркало». При таком раскладе все наши данные будут во время записи дублироваться на диск-зеркало, и, если основной диск выйдет из строя, наши данные останутся целыми и невредимыми на диске-зеркале. А мы потом в пару ему поставим заменённый рабочий диск. Размер дискового пространства я оставляю по умолчанию, он указан верно — с учётом ёмкости меньшего из дисков, а он у меня, напомню, 60 Гб, и из них доступными являются 58,7 Гб. По итогу жмём «Создать дисковое пространство».

Вот, собственно, и всё. В управлении дисками физические диски, ранее отображаемые как Диск 1 и Диск 2, больше не видны. Вместо них теперь есть новый диск, отображаемый как Диск 3, и это то самое дисковое пространство с файловой системой ReFS, которое мы только что создали.

Теперь можем приступать к наполнению этого дискового пространства данными. В проводнике оно ничем не будет отличаться от обычного пользовательского раздела диска.

В свойствах дискового пространства сможем проводить те же самые операции, что и с обычными разделами диска или съёмными устройствами информации. Например, можем переименовать его.

Управление дисковым пространством и пулом носителей

После создания пула носителей и первого дискового пространства в разделе функции дисковых пространств в панели управления теперь будет среда управления всем этим. Чтобы управление было доступно, нужно с правами администратора нажать кнопку «Изменить параметры». Правда, что пулом, что дисковым пространством сильно не поуправляешь, немногое что нам доступно для изменения.

Дисковые пространства управляются во вкладке с названием, соответственно, «Дисковые пространства». И, нажав опцию «Изменить», мы сможем переименовать пространство, установить иную букву и выставить иной размер. Для пула носителей доступны функции переименования, добавления дисков, создания новых дисковых пространств. В отдельной вкладке «Физические диски» отображаются, соответственно, жёсткие диски пула. Для них доступны функции переименования и удаления из пула в отдельных случаях (если это возможно без вреда для существования самого дискового пространства, а, соответственно, и для хранящихся на нём данных).

Если дисковое пространство станет ненужным, можем его удалить, предварительно сохранив куда-нибудь ценные данные.

Создание нескольких дисковых пространств на базе одного пула

Друзья, выше мы создали на базе нашего пула дисковое пространство с выделением в единый раздел всей ёмкости меньшего из дисков пула. Потом мы его удалили. А теперь давайте создадим на базе этого же пула тот же RAID 1, только теперь распределим пространство по разным разделам диска.

В разделе функции дисковых пространств в панели управления жмём «Создать дисковое пространство».

Выставляем файловую систему ReFS, тип устойчивости «Двухстороннее зеркало». А в графе размера указываем не весь, а лишь часть объёма жёсткого диска пула, что с меньшим объёмом. Если у меня это диск на 60 Гб, то я сделаю первое пространство, например, на 40 Гб. Жмём «Создать дисковое пространство».

Далее снова жмём «Создать дисковое пространство».

Снова указываем ReFS в качестве файловой системы, снова указываем тип устойчивости «Двустороннее зеркало». А размер теперь выставляем тот, что остался после создания первого пространства. В моём случае это будет разница между общим объёмом диска на 60 Гб и первым пространством на 40 Гб – 20 Гб. Этот размер я и указываю. Жмём «Создать дисковое пространство».

Ну вот и всё. Смотрим карту в управлении дисками Windows. У нас по-прежнему отсутствуют Диск 1 и Диск 2, но есть два новых диска – Диск 3 и Диск 4, появившихся благодаря технологии дисковых пространств.

Конфигурации RAID (типы устойчивости)

Друзья, мы с вами рассмотрели, как создавать в Windows 8.1 и 10 дисковые пространства на примере конфигурации RAID 1, именуемого в системной функции как тип устойчивости «Двустороннее зеркало». Таких типов устойчивости, т.е. конфигураций RAID в технологии дисковых пространств предусматривается всего четыре. А какие три остальные?

Тип устойчивости «Простой тип» — это конфигурация RAID 0, когда два или более жёстких диска работают с удвоенной скоростью обработки данных. Эта конфигурация не является отказоустойчивой.

Тип устойчивости «Трёхстороннее зеркало» — это конфигурация RAID 1E, требующая наличия в пуле не менее пяти жёстких дисков. Это и отказоустойчивая конфигурация, и обеспечивающая удвоенную производительность при обработке данных. Это самый надёжный из всех предлагаемых тип отказоустойчивости, ведь данные хранятся в экземплярах аж на трёх дисках.

Тип устойчивости «Чётность» — это конфигурация RAID 5, требующая постановки в пул не менее трёх жёстких дисков. Обеспечивает отказоустойчивость за счёт зеркала и увеличивает производительность при чтении данных.

Метки к статье: RAID Жёсткий диск Системные функции Windows 10 Windows 8.1

Контроллер дискового пространства (Майкрософт) Driver Download For Windows OS

(3 stars by 87 users)

The drivers provided on this page are for Контроллер дискового пространства (Майкрософт), and most of them are for Windows operating system. Before downloading the driver, please confirm the version number of the operating system installed on the computer where the driver will be installed. If the system version number does not meet the driver requirements, it may cause some unexpected problems. In the case of determining the operating system version number, it is recommended to download the 5-star driver first.

Before downloading the driver, please confirm the version number of the operating system installed on the computer where the driver will be installed. If the system version number does not meet the driver requirements, it may cause some unexpected problems. In the case of determining the operating system version number, it is recommended to download the 5-star driver first.

In addition, as long as your downloaded driver version can make the system work normally and stably, you don’t have to excessively pursue the latest version of the driver. This is because the new version of the driver is to solve some BUGs in extreme cases, or to improve a little bit of hardware performance, but it may also bring some new unpredictable problems.

Drivers Download

For Windows OS

Type

Version

Size

Download

Windows 8 Pro

6.2.9200.16731

281.31 KB

Windows 10 Enterprise

Windows 10 Home

Windows 10 Professional

Windows Server 2019 Standard

10.0.17763.529

830.88 KB

Windows 7 Professional Service Pack 1Windows 7 Enterprise Service Pack 1

Windows 7 Ultimate Service Pack 1

Windows Server 2008 R2 Enterprise Service Pack 1

Windows 7 Home Premium

Windows 10 Enterprise

Windows 10 Home

Windows 8.1

Windows 8.1 Professional

Windows 10 Enterprise

SCSIAdapter10.0.18362.449

844.81 KB

Windows 7 Professional Service Pack 1Windows 7 Enterprise Service Pack 1

Windows 7 Ultimate Service Pack 1

Windows Server 2008 R2 Enterprise Service Pack 1

Windows 7 Home Premium

Windows 10 Enterprise

Windows 10 Home

Windows 10 Enterprise

SCSIAdapter10.0.18362.1

844.59 KB

Windows XP Service Pack 3

10.0.18362.1

2.77 KB

SCSIAdapter10.0.16299.1059

730.18 KB

Windows 10 EnterpriseWindows 10 Home

Windows 10 Enterprise

SCSIAdapter10.0.18362. 449

449

654.3 KB

SCSIAdapter10.0.19041.388

875.88 KB

Windows 8.1Windows 8.1 Professional

Windows 10 Enterprise

SCSIAdapter6.3.9600.18573

415.81 KB

Windows 10 Enterprise

Windows 10 Home

Windows 10 Professional

Windows Server 2019 Standard

10.0.17763.864

849.1 KB

Driver Files

\spaceport.sys …596 K

\spaceport.inf …3 K

\spacedump.sys …170 K

How to Find Drivers for Unknown Devices in Windows?

For «unknown device» without driver installed, how to find the correct driver for this type of device? You can find the driver as follows. This is a simple and effective method. <Teach You How To Find Drivers For Unknown Devices In Your System>Use the search function at the top to find the driver you need

Many hardware names are usually named after the chip model, and each chip model has its own dedicated driver, so as long as you know the chip model used by the hardware, you can find the right driver. For example, if your graphics card is named: «AMD Radeon RX 580», while actually the core chip model used is: «Radeon RX 580», then enter «Radeon RX 580» or «RX 580» to find the driver.

If you have a laptop or an all-in-one PC, you can also use the product name to search, and then go to the download page which has all the drivers for this machine (including: graphics card, network card, sound card, etc.). For example, if your laptop product name is: «Dell A6-9220e Inspiron Flagship», then type «Dell A6-9220e» to find all the drivers for this laptop.

Search steps:1. Enter a keyword in the input box and click the «Search» button

2. In the query results, find the driver file you need, and click the download button

• Can’t find the required driver files?

• Don’t know how to find driver files?

• Unable to download driver files due to unstable network?

You can try using this driver file finder. The method of use is very simple. The program will automatically list all the driver files available for your current system. You can install drivers for devices that do not have drivers installed, and you can also upgrade drivers to the latest driver version for devices that have already installed drivers. Click here to download the driver finder.

The method of use is very simple. The program will automatically list all the driver files available for your current system. You can install drivers for devices that do not have drivers installed, and you can also upgrade drivers to the latest driver version for devices that have already installed drivers. Click here to download the driver finder.

Как освободить место на жестком диске на сервере приложений контроллера (диск заполняется)

Задача

Заказчик заметил, что жесткий диск (например, C :), на котором установлено программное обеспечение сервера контроллера (на сервере приложений контроллера), заполняется.

- Клиент попытался удалить все «известные» файлы, которые, как он уверен, можно безопасно удалить

- Заказчик не может увеличить размер жесткого диска.

=> Есть ли какие-нибудь типичные большие файлы / папки, которые можно легко удалить, чтобы освободить место?

Признак

Жесткий диск сервера приложений контроллера заполнен.

Причина

Существует несколько известных причин использования жесткого диска сервера приложений контроллера, связанных с контроллером:

- Сценарий № 1 — Файлы резервных копий (из предыдущих обновлений исправлений) не удаляются позже

- По умолчанию , во время патча (обновления) старые файлы сервера Controller (которые должны быть заменены новыми) копируются в подпапку здесь: C: \ Program Files \ ibm \ cognos \ ccr_64 \ bkp

- Эти файлы необходимы только в том случае (что маловероятно), когда заказчик хочет понизить версию своего программного исправления (позднее).

- Сценарий № 2 — файлы аварийного дампа Cognos BI («heapdump» и «javacore»)

- ‘Heapdump’ и ‘javacore’) представляют собой файлы аварийного дампа, созданные виртуальной машиной Java (JVM) это обеспечивает некоторые функции контроллера

- Если JVM неожиданно аварийно завершает работу, создаются эти файлы.

- Дополнительные сведения см. в отдельном документе IBM Technote № 1961469 .

Решение проблемы

Сценарий № 1

Если вы уверены, что не хотите «понижать» версию программного обеспечения контроллера, вы можете безопасно удалить подпапки резервных копий (под « bkp »).

- СОВЕТ: По умолчанию они расположены здесь: C: \ Program Files \ ibm \ cognos \ ccr_64 \ bkp

Сценарий № 2

Эти файлы можно просто удалить.

- Подробнее см. Отдельный IBM Technote № 1961469 .

[{«Подразделение»: {«код»: «BU053», «ярлык»: «Облачная платформа и платформа данных»}, «Продукт»: {«код»: «SS9S6B», «ярлык»: «Контроллер Cognos»} , «Компонент»: «», «Платформа»: [{«code»: «PF033», «label»: «Windows»}], «Версия»: «10.3.1 «,» Редакция «:» «,» Сфера деятельности «: {» code «:» LOB10 «,» label «:» Данные и AI «}}]

Освободите место на диске для генераторов нагрузки — внимание к качеству

Среды LoadRunner и Performance Center включают машины, известные как генераторы нагрузки, сокращенно LG. Часто к нам обращаются пользователи с проблемами, связанными с дисковым пространством. Вот несколько рекомендаций, которые помогут избежать нехватки места на диске LG.Я также расскажу о том, как освободить место на диске. Рекомендуемое дисковое пространство на машине, обозначенной как генератор нагрузки, должно составлять не менее 50 ГБ свободного места.

Часто к нам обращаются пользователи с проблемами, связанными с дисковым пространством. Вот несколько рекомендаций, которые помогут избежать нехватки места на диске LG.Я также расскажу о том, как освободить место на диске. Рекомендуемое дисковое пространство на машине, обозначенной как генератор нагрузки, должно составлять не менее 50 ГБ свободного места.

Лучше всего всегда сопоставлять результаты тестов. Если результаты теста не сопоставлены, они останутся в генераторе нагрузки. Наиболее частая причина того, что результаты не сопоставляются, — это запуск дымового теста в LoadRunner или Performance Center. Эти результаты тестирования будут накапливаться со временем и начнут влиять на объем свободного дискового пространства, особенно в более крупной тестирующей организации.

Для среды LoadRunner не существует автоматизированного метода, который очищал бы результаты от генератора нагрузки. Всякий раз, когда тест запускается в контроллере, результаты всегда должны быть сопоставлены и сохранены в указанном месте на контроллере (Контроллер-> Результаты-> Настройки результатов).

В Performance Center, если результаты успешно сопоставлены, они удаляются с компьютеров с генераторами нагрузки и контроллерами и сохраняются в файлах RawResult.zip в репозитории файлов ALM-PC.Для результатов, которые не сопоставлены, в ALM есть задача обслуживания, которая удаляет старые тестовые данные из генераторов нагрузки. Задача обслуживания находится в Lab Management. По умолчанию параметр настроен на проверку каждые 360 минут и удаление всех тестовых данных старше 90 дней. При необходимости этот параметр можно изменить в Lab Management.

Если вам нужно освободить дисковое пространство на машине, которая обозначена как генератор нагрузки, ниже приведен список действий, которые можно выполнить как при автономной установке LG, так и при установке хоста ПК, а также шаги для действий, специфичных для данной тип установки.

Действия для установки автономного генератора нагрузки или установки на ПК:

1. Очистить журнал событий Windows

Очистить журнал событий Windows

2. Дефрагментировать жесткие диски

3. На виртуальных серверах очистить все неиспользуемое пространство, освобожденное в процессе дефрагментации, а затем сжать виртуальные жесткие диски.

4. Удалите ненужное программное обеспечение

Для установки автономных генераторов нагрузки:

1. Очистите временные папки — не удаляйте никакие файлы программного обеспечения HPE, если вы не уверены — НЕ УДАЛЯЙТЕ

а.Чтобы точно определить, где находятся временные файлы, выполните следующие действия:

и. Войдите в каждый LG, используя свою учетную запись администратора, перейдите в Панель управления \ Все элементы панели управления \ Система \ Дополнительные системные настройки и нажмите кнопку «Переменные среды»

.ii. Здесь вы увидите, где находятся следующие временные папки (TEMP и TMP), которые можно удалить

1. Пользовательские переменные для (Имя учетной записи администратора)

2. Системные переменные

Для установок на ПК:

1.С помощью настольного клиента ALM в каждом проекте убедитесь, что все тестовые прогоны были сопоставлены

2. Очистите папки Temp — не удаляйте никакие файлы программного обеспечения HPE, если вы не уверены — НЕ УДАЛЯЙТЕ

а. Чтобы точно определить, где находятся временные файлы, выполните следующие действия:

и. Войдите в каждый LG, используя системную учетную запись пользователя (IUSR_METRO или аналогичную учетную запись служб), перейдите в Панель управления \ Все элементы панели управления \ Система \ Дополнительные системные настройки и нажмите кнопку «Переменные среды»

.ii.Здесь вы увидите, где находятся следующие временные папки (TEMP и TMP), которые можно удалить

1. Пользовательские переменные для IUSR_METRO

2. Системные переменные

3. Перейдите в папку% RootDrive% \ Program Files (x86) \ HP \ Performance Center Host \ orchidtmp, заархивируйте папку orchidtmp и сохраните ее на общий диск, чтобы сохранить журналы и все несобранные результаты тестов.

а. Папку orchidtmp можно удалить, и Performance Center заново создаст эту папку при следующем использовании машины для тестового запуска

4.Перейдите в% RootDrive%: \ Program Files (x86) \ HP \ Performance Center Host \ Temp, удалите содержимое папки TEMP

Как упоминалось ранее, рекомендуемое дисковое пространство на машине, назначенной как генератор нагрузки, должно составлять не менее 50 ГБ свободного места после установки программного обеспечения HPE. Эта рекомендация резервирует достаточно места в большинстве случаев для размещения временных результатов. Однако в реальном мире может потребоваться обслуживание с использованием передовых методов и регулярных задач по удалению, чтобы ваша среда нагрузочного тестирования работала оптимально.

Автор Брайан Смит, 29 августа 2017 г. / Micro Focus LoadRunner, Центр производительности Micro FocusМониторинг свободного дискового пространства с помощью Netwrix Disk Space Monitor

Следите за дисковым пространством на сервере, чтобы убедиться, что Постоянная доступность сервера

Netwrix Disk Space Monitor автоматически отслеживает нехватку дискового пространства на нескольких серверах. Это бесплатно дисковое пространство инструмент мониторинга держит вас в курсе того, какие серверы приближаются к условиям нехватки места на диске, чтобы вы может предотвратить простои сервера и непредвиденные сбои.

Мониторинг нескольких серверов одновременно

Позволяет легко проверять дисковое пространство на рабочих станциях, контроллерах домена, файловых серверах, SharePoint серверы, серверы Exchange, серверы баз данных и многое другое.

Всегда знайте, сколько свободного места у вас осталось

Отправляет ежедневные отчеты о свободном дисковом пространстве на указанных серверах и каждый раз мгновенно предупреждает вас

Свобода

пространство опускается ниже указанного вами порога.

Снизить риск недоступности сервера

Помогает снизить риск простоя сервера и ошибок, вызванных нехваткой свободного места на диске. на ваших серверах.

Забудьте о ручных процессах

Упрощает мониторинг, избавляя от необходимости создавать, поддерживать и запускать несколько настраиваемых PowerShell. скрипты.

Легко настроить инструмент

Требует минимальных затрат времени и усилий на установку и очень проста в использовании.

Получи это бесплатно

Не имеет срока годности, поэтому вы можете быть уверены, что он будет рядом с вами, когда он вам больше всего понадобится.

Недостаточно памяти для обновления контроллера — Vera

При обновлении контроллера Vera вы можете увидеть сообщение о том, что недостаточно места. Эти шаги могут помочь.

Во время обновления программного обеспечения вы можете увидеть сообщение о том, что обновление не может быть установлено, поскольку для него требуется больше места, чем у вас есть на вашем контроллере. Если вы видите это сообщение, вы можете обновить свое устройство несколькими способами:

Как обновить контроллер при недостатке памяти для новой прошивки

- Примечание. Эти инструкции предназначены для владельцев устаревших моделей контроллеров Vera (VeraLite или Vera 3), которые хотят обновить прошивку UI7 до последней версии, но получили сообщение «Недостаточно памяти».

- Для этой процедуры вам понадобится компьютер с небольшим объемом свободного места на жестком диске (или вы можете подключить к компьютеру флэш-накопитель или внешний диск). Мы будем использовать диск компьютера (или внешний диск) для резервного копирования ваших существующих файлов, и этот процесс должен освободить достаточно памяти в вашем контроллере Vera, чтобы соответствовать более новой версии прошивки UI7.

- По сути, вы будете делать резервную копию, затем очищать память вашего контроллера, затем устанавливать новое программное обеспечение, как если бы контроллер был совершенно новым, а затем восстанавливать настройки системы с помощью новой прошивки.

- Вам следует выполнять эту процедуру только в том случае, если в вашем контроллере Vera в настоящее время недостаточно памяти для обновления прошивки.

Сначала создайте резервную копию всего на вашем VeraLite или Vera 3, чтобы сохранить на вашем компьютере

- Используя компьютер и браузер, войдите в свою панель управления Vera со страницы нашего портала https://home.getvera.com/, используя свое имя пользователя и пароль. Выберите свой контроллер VeraLite / Vera3.

- В меню Vera Dashboard слева щелкните Settings и выберите Backup , а затем нажмите кнопку Create backup , как показано ниже.

- Откроется новая страница. Сначала нажмите кнопку Backup Z-Wave Network , чтобы создать резервную копию вашей Z-Wave сети. Вам следует подождать около 20 минут, чтобы убедиться, что резервное копирование завершено (так как это может занять много времени, чтобы идентифицировать и создать резервную копию всех устройств Z-Wave в вашей системе).

- Затем нажмите кнопку Создать резервную копию , чтобы сохранить файл на свой компьютер. Важно: запишите папку или каталог, в котором компьютер сохраняет этот файл, так как он вам понадобится позже.

(Или, если вы предпочитаете сохранить резервную копию на флэш-накопителе, укажите его в качестве местоположения файла.)

(Или, если вы предпочитаете сохранить резервную копию на флэш-накопителе, укажите его в качестве местоположения файла.)ПРИМЕЧАНИЕ. ДАННЫЕ И ДАННЫЕ 2 ПЛАГИН ИЗВЕСТНО, ДЛЯ ХРАНЕНИЯ ДАННЫХ. РАСПОЛОЖЕНИЕ НА КОНТРОЛЛЕРЕ НЕ ПО УМОЛЧАНИЮ И ДАННЫЕ БУДУТ УТЕРЯНЫ. ПОЖАЛУЙСТА, НЕ СОБЛЮДАЙТЕ ДАННУЮ ПРОЦЕДУРУ, ЕСЛИ ВЫ ДЕЙСТВУЕТЕ НА ЭТИ ПЛАГИНЫ.

- Вернитесь в «Настройки» -> «Прошивка» и продолжите (или начните) процесс обновления.

- Обязательно выберите Восстановить заводское состояние по умолчанию . (На шаге 4 все настройки конфигурации уже должны быть сохранены на вашем компьютере)

- Используя тот же компьютер и браузер , снова войдите под своим именем пользователя и паролем на страницу нашего портала https://home.getvera.com/.

- Выберите «Мне нужно настроить новую Vera» (даже если она не новая) и продолжите начальную настройку, снова присвоив контроллеру VeraLite / Vera3 имя (дайте ему то же имя, которое вы использовали ранее).

- Когда появится панель Vera Dashboard, щелкните меню Settings и выберите Backup .

- Либо перетащите файл резервной копии в область загрузки (с помощью файлового браузера, такого как Windows Explorer или Mac Finder), ЛИБО нажмите кнопку «Загрузить», перейдите в папку с файлом резервной копии и выберите его.

- Отметьте опцию Restore Z-Wave network , чтобы включить сеть Z-Wave от VeraLite или Vera3.

- Нажмите кнопку Восстановить , чтобы начать перенос на VeraLite или Vera3.

- Подождите. Процесс восстановления займет пару минут, в течение которых VeraLite или Vera3 перезагрузится. Когда процесс будет завершен, все светодиодные индикаторы на вашем VeraLite или Vera3 загорятся, и вы обновите Vera со всеми восстановленными настройками.

- Рекомендуется проверить, все ли ваши устройства взаимодействуют с контроллером Vera. Для некоторых устройств с батарейным питанием Z-wave вам может потребоваться «разбудить» их вручную, активировав их (например, открыв окно, чтобы «разбудить» оконный датчик, или нажав кнопку управления на устройстве.)

MAAS | Требования MAAS (snap / 2.9 / UI)

Минимальные требования к машинам, на которых выполняется MAAS, сильно различаются в зависимости от местной реализации и использования. Ниже вы найдете оценки ресурсов, основанные на компонентах MAAS и операционной системе (Ubuntu Server). Мы рассматриваем как тестовую конфигурацию (для подтверждения концепции), так и производственную среду.

У вас могут возникнуть два вопроса:

- Каковы требования к тестовой среде?

- Каковы требования к производственной среде?

Вот экспериментальный сценарий со всеми компонентами MAAS, установленными на одном хосте.Этот сценарий предполагает два полных набора образов (два последних выпуска Ubuntu LTS) для одной архитектуры (amd64).

| Память (МБ) | ЦП (ГГц) | Диск (ГБ) | |

|---|---|---|---|

| Контроллер региона (без PostgreSQL) | 512 | 0,5 | 5 |

| PostgreSQL | 512 | 0,5 | 5 |

| Контроллер стойки | 512 | 0.5 | 5 |

| Сервер Ubuntu (включая журналы) | 512 | 0,5 | 5 |

На основании этой таблицы приблизительные требования для этого сценария: 2 ГБ памяти, ЦП 2 ГГц и 20 ГБ дискового пространства.

Вот рабочий сценарий, предназначенный для обработки большого количества устойчивых клиентских подключений. Этот сценарий реализует как высокую доступность (регион и стойка), так и балансировку нагрузки (регион). MAAS резервирует дополнительное пространство для образов (базы данных и контроллера стойки), в то время как для некоторых образов, например для Microsoft Windows, может потребоваться гораздо больше места — так что планируйте соответственно.

MAAS резервирует дополнительное пространство для образов (базы данных и контроллера стойки), в то время как для некоторых образов, например для Microsoft Windows, может потребоваться гораздо больше места — так что планируйте соответственно.

| Память (МБ) | ЦП (ГГц) | Диск (ГБ) | |

|---|---|---|---|

| Контроллер региона (без PostgreSQL) | 2048 | 2,0 | 5 |

| PostgreSQL | 2048 | 2,0 | 20 |

| Контроллер стойки | 2048 | 2,0 | 20 |

| Сервер Ubuntu (включая журналы) | 512 | 0.5 | 5 |

Итак, исходя из вышеизложенного, приблизительные требования для этого сценария:

- Контроллер региона (включая PostgreSQL), установленный на одном хосте, с 4,5 ГБ памяти, процессором 4,5 ГГц и 45 ГБ дискового пространства.

- Дублирующий контроллер региона (включая PostgreSQL) на втором хосте, также с 4,5 ГБ памяти, процессором 4,5 ГГц и 45 ГБ дискового пространства.

- Контроллер стойки, установленный на третьем хосте, с памятью 2,5 ГБ, 2.Процессор 5 ГГц и 40 ГБ дискового пространства.

- Дублирующий контроллер стойки на четвертом хосте, также с 2,5 ГБ памяти, процессором 2,5 ГГц и 40 ГБ дискового пространства.

Приведенные выше таблицы относятся только к инфраструктуре MAAS. Они не покрывают ресурсы, необходимые для добавляемых впоследствии узлов. Обратите внимание, что на машинах должны быть установлены контроллеры BMC на базе IPMI для включения и выключения питания. Дополнительные сведения см. В разделе «Управление питанием».

Некоторые примеры факторов, влияющих на технические характеристики оборудования, включают:

- количество подключаемых клиентов (клиентская активность)

- как вы решили распределять услуги

- независимо от того, используете ли вы высокую доступность / балансировку нагрузки.

- количество образов, которые вы выбираете для хранения (дисковое пространство, влияющее на PostgreSQL и контроллер стойки)

Кроме того, это обсуждение не принимает во внимание возможное локальное зеркало изображения, которое потребляет много дискового пространства.

Один контроллер стойки должен обслуживать не более 1000 машин, независимо от того, как вы распределяете их по подсетям. На уровне стойки нет балансировки нагрузки, поэтому вам потребуются дополнительные независимые контроллеры стойки.Каждый контроллер должен обслуживать свою собственную подсеть (и).

Последнее обновление 15 дней назад.

Устранение неполадок, связанных с использованием дискового пространства на узлах сервера Tableau

Когда доступное дисковое пространство на узле Tableau Server мало, производительность может снизиться. Если свободного места становится слишком мало, Tableau Server может начать работать нестабильно.

Для отслеживания свободного места на диске настройте Tableau Server для сохранения информации об использовании диска (по умолчанию это включено) и, при желании, включите уведомления по электронной почте о нехватке места на диске.Дополнительные сведения см. В разделе Настройка уведомления о событиях на сервере.

Примечание. При мониторинге дискового пространства измеряется свободное дисковое пространство на каждом узле сервера. На доступное пространство могут влиять программы или процессы, не являющиеся частью Tableau Server.

Если вы обнаружите, что ваша установка Tableau Server работает с ограничениями по свободному месту на диске, вам следует предпринять шаги, чтобы освободить больше места. В этой теме предлагается несколько способов сделать это.Вы также можете найти полезную информацию в базе знаний Tableau: узлы, застрявшие в состоянии ошибки после перезапуска TSM (ссылка открывается в новом окне)

Просмотр использования диска на узлах сервера Tableau

Когда включен мониторинг использования дискового пространства (это значение по умолчанию), администраторы сервера могут использовать административное представление «Дисковое пространство сервера» для просмотра текущего использования дискового пространства и данных об использовании за один месяц на узлах сервера Tableau. Используйте это представление, чтобы помочь вам определить, испытывает ли один из ваших серверных узлов скачок использования пространства или увеличилось ли использование пространства с течением времени.

Используйте это представление, чтобы помочь вам определить, испытывает ли один из ваших серверных узлов скачок использования пространства или увеличилось ли использование пространства с течением времени.

Чтобы минимизировать пространство на сервере, используемое Tableau Server, вы можете удалить ненужные файлы.

Используйте команду tsm maintenance cleanup для удаления файлов журналов, временных файлов и ненужных записей в базе данных PostgreSQL. Если вы хотите сохранить журналы перед их очисткой, вы можете создать архив. Для получения дополнительной информации см. Удаление ненужных файлов.

После очистки файлов журналов и временных файлов вы можете использовать административные представления, чтобы определить, какие книги и источники данных занимают больше всего места на вашем сервере и не используются ли какие-либо из них.Дополнительные сведения см. В разделе «Административные представления».

Сокращение журналов службы координации

Служба координации может создавать большое количество журналов транзакций во время нормальной работы. По умолчанию служба координации собирает их, создавая моментальный снимок для каждых 100 000 журналов транзакций и удаляя моментальные снимки старше пяти дней. Если существует менее 100 000 журналов транзакций, моментальный снимок не создается, и журналы остаются на месте до достижения порогового значения журнала транзакций.В результате на диске может не хватить места по мере накопления журналов. По умолчанию журналы и снимки сохраняются в каталоге данных Tableau Server: C: \ ProgramData \ Tableau \ Tableau Server \ data \ tabsvc \ appzookeeper \ .

Если вы испытываете нехватку дискового пространства из-за старых журналов транзакций, ваша установка Tableau Server может создавать менее 100 000 журналов в день. Вы можете настроить количество журналов, необходимых для запуска создания моментального снимка, с помощью

Вы можете настроить количество журналов, необходимых для запуска создания моментального снимка, с помощью zookeeper.config.snapCount вариант:

tsm configuration set -k zookeeper.config.snapCount -v

tsm в ожидании изменений применяются

Для получения дополнительной информации см. Zookeeper.config.snapCount.

Невозможно получить доступ к серверу Tableau или веб-интерфейсу TSM после нехватки места на диске

Чтобы избежать нехватки дискового пространства, рассмотрите возможность настройки уведомлений о нехватке дискового пространства, чтобы вы знали, когда пространство достигает заранее определенного размера.Дополнительные сведения см. В разделе Настройка уведомления о событиях на сервере.

Если вам не хватает места на диске, у вас могут возникнуть проблемы с доступом к Tableau Server или TSM с помощью веб-интерфейса. Чтобы решить эту проблему, удалите посторонние файлы, чтобы освободить место на диске, а затем принудительно перенастройте сервер, установив несуществующий ключ.

На начальном узле откройте командную строку от имени администратора.

Установить несуществующий ключ конфигурации:

набор конфигураций tsm -k foo -v barПримените изменения для принудительной реконфигурации:

tsm в ожидании изменений применяются

Установка несуществующего ключа не повлияет на Tableau.

— обзор

Выделенные контроллеры RAID

Для более быстрого ввода данных вам необходимо обратиться к выделенному контроллеру жесткого диска, который находится на шине PCI-E. Однако этот подход вступает в противоречие с нашей необходимостью иметь видеокарты на одной и той же шине. С воздушным охлаждением все графические процессоры представляют собой двухслотовые карты. Возможно, вам придется извлечь карту графического процессора, чтобы можно было вставить выделенную карту контроллера жесткого диска и / или высокоскоростную сетевую карту.

С системами с жидкостным охлаждением это немного проще, потому что каждая карта имеет один слот. Однако вы по-прежнему ограничены общим энергопотреблением ПК, обычно до 1,5 кВт. Фактически это означает, что, по крайней мере, для высокопроизводительных карт будут свободные слоты PCI-E.

Предполагая, что у вас есть подсистема SSD-накопителей SATA-3 на 550 МБ / с, для достижения входной пропускной способности 5 ГБ / с для одной карты GPU вам потребуется 10 SSD-накопителей. Если используемая вами карта RAID поддерживает одновременную передачу данных на шину PCI-E и обратно, вам потребуется всего 20 твердотельных накопителей SATA-3 для поддержки полной пропускной способности одного RAID-контроллера PCI-E X16.

Итак, чтобы иметь возможность предоставлять и хранить в реальном времени полную пропускную способность одной карты с графическим процессором , даже с использованием твердотельных накопителей, потребуется 20 твердотельных накопителей. Даже с четырьмя твердотельными накопителями по 6 на каждый отсек для дисков вам потребуется 4 отсека для дисков.

Если вы посмотрите на конфигурацию графического процессора высшего класса, то решением будет решение с четырьмя графическими процессорами с жидкостным охлаждением на основе материнской платы, которая поддерживает семь разъемов шины PCI-E. Без дополнительных карт все графические процессоры работают на скорости X8 (2,5 ГБ / с на входе, 2,5 ГБ / с на выходе) с четырьмя картами графического процессора и X16 с двумя картами графического процессора.

В системе с жидкостным охлаждением у вас есть свободные слоты между картами, так как большинство решений с жидкостным охлаждением являются однослотовыми. Как только вы добавите карту контроллера RAID, соответствующий слот упадет до X8 или X4 как для графического процессора, так и для карты RAID. Это если вы не выделите слот X16 для RAID-контроллера, что мы рекомендуем.

Существует физическое ограничение на количество отсеков для дисков, которые могут быть включены в формат рабочей станции. Даже на материнской плате с семью слотами PCI-E, которую часто называют материнскими платами суперкомпьютеров, остается только три слота, когда присутствуют четыре графических процессора с жидкостным охлаждением.Это может позволить втиснуть в такие системы два контроллера RAID и одну высокоскоростную сетевую карту.

RAID — это не просто скорость, хотя для этого используется режим RAID-0. RAID-1 поддерживает зеркалирование, при котором данные полностью копируются на другой диск. В таком случае отказ одного диска означает, что система переключается на оставшийся диск без значительного влияния на работу системы. Однако очевидно, что неисправный диск необходимо заменить как можно скорее.Это избавит вас от ситуации, когда несколько недель вычислительного времени могут быть потеряны из-за неисправного жесткого диска.

В небольшом кластере жесткие диски выходят из строя достаточно редко, так что это не такая уж большая проблема. Однако в более крупной установке с тысячами активных дисков вы будете регулярно менять диски.