GPU (Graphic Processor Unit) — что это такое и для чего нужен?

В статьях компьютерной тематики частенько можно встретить непонятные аббревиатуры. Например, GPU — что это такое и как расшифровывается? Рассмотрим, для чего нужен данный компонент, и как узнать его параметры.

Что такое GPU?

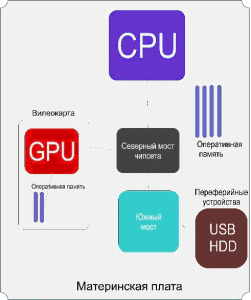

Ни для кого не секрет, что центральный процессор, который является мозгом любого компьютера, имеет аббревиатуру CPU. Данное буквосочетание пошло из английского языка и расшифровывается оно как Central Processor Unit. Почему процессор называют центральным? Все очень просто. Данное «звание» вычислитель получил, потому что именно он управляет всеми подсистемами компьютера. Это и является основной функцией данного устройства. Управление осуществляется через чипсет и шины.

Если проводить аналогию с центральным процессором, то можно догадаться что такое GPU в домашнем компьютере. Данная аббревиатура расшифровывается как Graphic Processor Unit. Если говорить простым языком, то это графический чип, который в простонародье также именуется видеокартой (что неверно, так как видеокарта – отдельный аппаратный модуль).

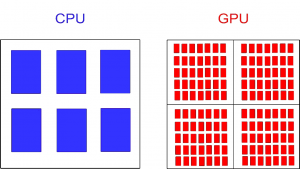

Чем графический адаптер отличается от центрального процессора? Главное различие между этими двумя компонентам – архитектура. Структура CPU выполнена таким образом, что он обрабатывает порции информации последовательно, поочередно. А видеочип, в свою очередь, способен сразу же взаимодействовать с большими объемами данных. Это стало возможно благодаря огромному количеству ядер, которые проводят параллельные вычисления. Если с функциями ЦПУ мы уже разобрались, то появляется вопрос: а для чего нужен ГПУ? Ответ даст следующий раздел данной статьи.

Предназначение GPU

Графический процессор предназначен для обработки специального формата данных – графики. То есть данный аппаратный модуль отвечает за изображение, которое вы видите на экране компьютера. ГПУ способен принимать и обрабатывать команды, которые формируют трехмерную графику.

Стоит заметить, что графический процессор – ключевой компонент видеосистемы компьютера. Именно от видеочипа зависит то, насколько быстро и качественно будет прорисовываться изображение во время игры или же при просмотре видеоролика высокого качества. В общем ЦПУ отвечает за обработку графики. Однако это далеко не все на что способен данный аппаратный модуль. GPU можно найти уйму применений, которые никак не связаны с обработкой графики. Например, графический процессор используется для добычи криптовалюты.

Температура

Как упоминалось выше, ГПУ обрабатывает огромные объемы данных. Из-за этого видеочип сильно нагревается. Высокая температура GPU может привести к поломке устройства. Чтобы избежать неприятностей необходимо убедиться в том, что ваша система охлаждения достаточно мощная. Как это проверить? Все довольно-таки просто. Руководствуйтесь следующей инструкцией:

- Скачайте и инсталлируйте программу под названием TechPowerUP GPU-Z. Сделать это можно совершенно бесплатно.

- Запустите скачанную утилиту. Программа просканирует систему и выдаст вам информацию касательно вашего ГПУ.

- Нас интересует пункт под названием GPU Temperature. Если данный параметр превышает планку в 80 градусов, то в таком случае вам стоит задуматься о смене системы охлаждения.

Вывод

GPU – это аббревиатура, обозначающая графический процессор. Данный аппаратный модуль есть не только на ПК, но и на лептопах, планшетах, телефонах на базе Андроида и iOS. Предназначение ГПУ — обработка и воспроизведение графики. Эти функции видеочип выполняет благодаря уникальной архитектуре.

что это в компьютере, температура GPU

Изучая технические характеристики компьютера, вы можете встретить такой термин как GPU. Данный термин обычно не объясняется простыми словами, поэтому пользователи редко понимают, что конкретно он означает. Иногда под GPU пользователи понимают видеокарту, хотя это не совсем верно. На самом деле GPU является частью видеокарты, а не самой видеокартой. В этом материале мы подробно расскажем о том, что такое GPU в компьютере, а также как узнать свой GPU и его температуру.

Что такое GPU в компьютере

Аббревиатура GPU расшифровывается как Graphics Processing Unit, что можно перевести как устройство для обработки графики. Фактически GPU именно этим и является это отдельный модуль компьютера, который отвечает за обработку графики. В компьютере GPU может быть выполнен как отдельный кремниевый чип, который распаян на материнской или собственной отдельной плате (видеокарте), либо как часть центрального процессора или чипсета (северный мост).

Как выглядит GPU в компьютере.

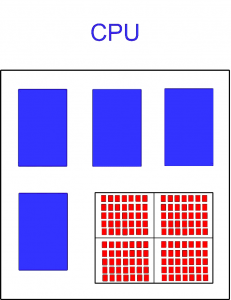

Если GPU выполнен в качестве отдельного чипа, то его обычно называет графическим процессором, а если GPU является частью центрального процессора или чипсета, то часто для его обозначения используется термин интегрированная графика или встроенная графика.

В некоторых случаях под термином GPU понимают видеокарту, что не совсем верно, поскольку GPU – это именно чип (графический процессор), который занимается обработкой графики, а видеокарта — это целое устройство ответственное за обработку графики. Видеокарта состоит из графического процессора, памяти, имеет собственную плату и BIOS.

Другими словами, GPU – это графический процессор, который представляет собой кремниевый чип, на отдельной плате (видеокарте). Также под GPU может пониматься модуль, встроенный в центральный процессор (основной чип компьютера). В обоих случаях GPU занимается обработкой графики.

В современных условиях GPU часто используется не только для обработки графики, но и для решения других задач, которые могут быть обработаны с помощью графического процессора более эффективно, чем с помощью центрального процессора. Например, GPU используют для кодирования видео, машинного обучения, научных расчетов.

Как узнать какой GPU в компьютере

Пользователи часто интересуются, какой GPU используется в их компьютере. При этом под термином GPU чаще всего понимают видеокарту. Это связано с тем, пользователи обычно имеют дело с видеокартой в целом, а не конкретно с GPU. Например, название видеокарты необходимо для установки подходящих драйверов и проверки минимальных требований компьютерных игр. В то время как название GPU пользователю практически никогда не требуется.

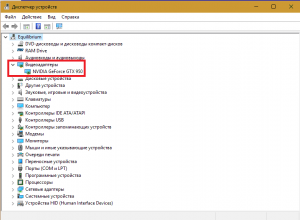

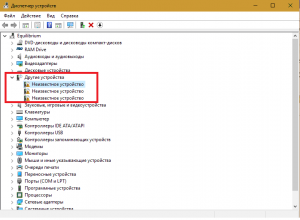

Существует несколько способов узнать название видеокарты. Самый простой – это посмотреть в диспетчере устройств. Для этого нужно нажать комбинацию клавиш Windows-R и выполнить команду «mmc devmgmt.msc». Также «Диспетчер устройств» можно открыть и другими способами.

В результате должно открыться окно «Диспетчера устройств». Здесь в разделе «Видеоадаптеры» будет указано название видеокарты.

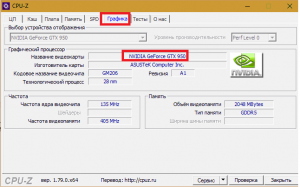

Но, вариант с диспетчером устройств не самый надежный. Если вы не установили драйверы для видеокарты, то система может ее не опознать и в диспетчере устройств не будет информации о ее названии. В таком случае лучше обратиться к сторонним программам. Например, можно установить программу GPU-Z, которая покажет всю возможную информацию об установленной видеокарте. Например, в GPU-Z название видеокарты можно узнать в строке «Name» в самом верху окна программы. На скриншоте внизу показано название видеокарты, это NVIDIA GTX GeForce 950.

Также в GPU-Z можно узнать название самого GPU (графического процессора). Например, на скриншоте внизу показано, что видеокарта NVIDIA GTX GeForce 950 построена на базе графического процессора GM206.

Температура GPU

GPU является один из самых горячих компонентов компьютера. Как и центральный процессор, GPU выделяет много тепла и его нужно эффективно отводить. Иначе графический процессор начнет перегреваться, что приведет к снижению производительности, сбоям в работе, перегрузкам компьютера и даже поломке.

Узнать температуру GPU можно с помощью специальных программ. Например, можно использовать GPU-Z, которую мы уже вспоминали. Если в программе GPU-Z перейти на вкладку «Sensors», то можно получить информацию о текучем состоянии видеокарты. Здесь будет указана частота GPU, его загрузка, температура и другие параметры.

Если вы хотите проверить не только температуру GPU, но и температуры других компонентов компьютера, то для этого удобно пользоваться программой HWmonitor. Данная программа отображает температуру, частоты, загрузку и другие параметры сразу для всех компонентов.

После проверки температуры часто возникает вопрос, какую температуру можно считать нормальной. Точного ответа на этот вопрос нет, поскольку у разных GPU разный предел температур, которые они могут переносить без последствий. Но, в среднем нормальной температурой графического процессора является:

- до 55 °C в режиме простоя;

- до 80 °C под нагрузкой;

Если температура вашего GPU выходит за эти пределы, то это можно считать перегревом. В таком случае нужно улучшить охлаждение графического чипа, для того чтобы привести эти значения к норме.

Если нужно понизить температуру видеокарты, то стоит начать с удаления пыли, которая скопилась на ее радиаторе. Если радиатор сильно забит пылью, то это может повышать температуру графического процессора на 5-10 градусов. Если простая чистка радиатора не помогает, то нужно заменить термопасту. В крайнем случае можно улучшить продуваемость корпуса компьютера, добавив несколько вентиляторов на вдув и выдув воздуха.

Посмотрите также:

различия c CPU в современных компьютерах

Привет, друзья. Вы любите поиграть в реалистичные игры на компе? Или посмотреть фильм в качестве, при котором четко видно каждую мелочь? Значит, вы должны представлять, что такое gpu в компьютере. Ничего о нем не знаете? Моя статья поможет вам избавиться от этого недоразумения ;-).

GPU — это не видеокарта

Неизвестное для многих сочетание букв подразумевает под собой понятие «graphics processing unit», что на нашем языке означает графический процессор. Именно он отвечает за воспроизведение картинки на вашем железе, и чем лучше его характеристики, тем качественнее будет изображение.

Всегда считали, что эти функции выполняет видеокарта? Вы, конечно, правы, но она является комплексным устройством, и главным ее компонентом выступает как раз графический проц. Он может существовать и автономно от видюхи. Об этом поговорим немного позже.

Что такое GPU и в чём разница с CPU?

Несмотря на сходство аббревиатур, не путайте предмет нашего разговора с CPU (Central Processor Unit). Да, они похожи, как в названии, так и в функциях. Последний тоже может воспроизводить графику, правда, слабее в этом деле. Все же это абсолютно разные устройства.

Они отличаются архитектурой. CPU является многоцелевым девайсом, который отвечает за все процессы в компьютере. Для этого ему хватает нескольких ядер, с помощью которых он последовательно обрабатывает одну задачу за другой.

В свою очередь, GPU изначально разработан как специализированное устройство, предназначенное для выполнение графического рендеринга, с высокой скоростью обрабатывающее текстуры и сложные изображения. Для таких целей его оснастили многопоточной структурой и множеством ядер, чтобы он работал с большими массивами информации единовременно, а не последовательно.

В виду этого преимущества, лидеры среди производителей видеоадаптеров выпустили модели, в которых графические процессоры могут стать усовершенствованной заменой центральным. У бренда nVidia такой девайс называется GTX 10xx, а у его главного конкурента AMD — RX.

Виды графических процев

Чтобы вы могли ориентироваться на рынке GPU, предлагаю ознакомиться с видами этого устройства:

- Дискретный. Входит в состав видеоадаптера. Подключается к системной плате через специально отведенный разъем (чаще всего PCIe или AGP). Имеет собственную оперативную память. Вы требовательный геймер или работаете со сложными графическими редакторами? Берите дискретную модель.

- Интегрированный (IGP). Раньше впаивался в материнскую плату, теперь встраивается в центральный процессор. Изначально не годился для воспроизведения реалистичных игр и тяжелых графических программ, однако новые модели справляются с этими задачами. Все же учтите, что такие чипы несколько медлительнее, потому что не имеют личной оперативки и обращаются к памяти CPU.

- Гибридная графическая обработка. Это 2 в 1, то есть когда в компьютере устанавливается и первый вид, и второй вид GPU. В зависимости от выполняемых задач, включается в работу или один, или другой. Однако бывают ноутбуки, в которых могут работать сразу 2 вида устройств.

- Внешний тип. Как несложно догадаться, это графический процессор, расположенный снаружи компа. Чаще всего такую модель выбирают обладатели ноутбуков, которым сложно впихнуть в свое железо дискретную видеокарту, но очень хочется получить достойную графику.

Как выбирать?

Когда будете подбирать для себя видеоадаптер, обращайте внимание на такие характеристики:

- Тактовая частота. Указывается в мегагерцах. Чем цифра выше, тем больше информации за секунду сможет обработать устройство. Правда, не только она влияет на его результативность. Архитектура также имеет значение.

- Число вычислительных блоков. Они призваны обрабатывать задачи — шейдеры, отвечающие за вершинные, геометрические, пиксельные и универсальные расчеты.

- Быстрота заполнения (филлрейт). Этот параметр может рассказать, с какой скоростью GPU может вырисовывать картинку. Он делится на 2 вида: пиксельный (pixel fill rate) и текстурный (texel rate). На первый влияет количество ROP-блоков в структуре проца, а на второй — текстурных (TMU).

Обычно в последних моделях GPU первых блоков меньше. Они записывают рассчитанные видеоадаптером пиксели в буферы и смешивают их, что по-умному называется блендинг. TMU выполняют выборку и фильтрацию текстур и другой информации, требуемой для выстраивания сцены и общих расчетов.

Геометрические блоки

Раньше на них никто не обращал внимания, потому что виртуальные игры имели простую геометрию. Этот параметр стали учитывать после появления в DirectX 11 тесселяции. Не понимаете, о чем я? Давайте по порядку.

DirectX является средой (набором инструментов) для написания игр. Чтобы вы ориентировались в теме, скажу, что последняя версия продукта — 12-я, которая вышла в 2015 году.

Тесселяция — это деление плоскости на части для заполнения их новой информацией, что повышает реализм игры.

Таким образом, если вы захотите с головой окунуться в атмосферу Metro 2033, Crysis 2, HAWX 2 и т. п., при выборе GPU учитывайте количество геометрических блоков.

Память

Собрались брать новую видеокарту? Значит, вам нужно учесть еще несколько характеристик оперативки:

- Объем. Важность RAM несколько переоценена, так как не только ее емкость, но также тип и свойства влияют на производительность карты.

- Ширина шины. Это более весомый параметр. Чем шире, тем больше информации сможет отправить память чипу и наоборот за определенное время. Для воспроизведения игр необходимо минимум 128 бит.

- Частота. Тоже определяет пропускную способность оперативки. Но учтите, что память с 256-битной шиной и частотой 800 (3200) МГц работает продуктивнее, чем со 128 битами на 1000 (4000) МГц.

- Тип. Не буду грузить вас лишней информацией, а лишь назову оптимальные на сегодня типы — это GDDR 3 и 5 поколения.

Немного об охлаждении GPU

Задумали приобрести видеоадаптер с мощным чипом? Сразу позаботьтесь о выборе охлаждения. А если собираетесь регулярно выжимать из девайса все соки, можно подумать и над жидкостной системой.

В целом, следите за температурой видюхи. Помочь в этом вам может программа GPU-Z и т. п., которая помимо этого параметра расскажет все об устройстве.

Конечно, современные видеокарты оснащаются защитной системой, которая вроде бы не допускает перегрева. Для разных моделей предельная температура отличается. В среднем, она составляет 105 °C, после чего адаптер сам выключается. Но лучше поберечь дорогой девайс и обеспечить вспомогательное охлаждение.

Почерпнули для себя кое-что полезное?

Поделитесь этим с друзьями в социальных сетях. Вдруг они тоже не знают, что такое gpu.

До скорого!

CPU и GPU в чем разница и как выбрать для своих целей

В чем разница между CPU и GPU? Все мы знаем, что у видеокарты и процессора несколько различные задачи, однако знаете ли вы, чем они отличаются друг от друга во внутренней структуре? Как CPU (англ. — central processing unit), так и GPU (англ. — graphics processing unit) являются процессорами, и между ними есть много общего, однако сконструированы они были для выполнения различных задач. Подробнее об этом вы узнаете из данной статьи.

Что такое CPU

CPU расшифровка — это аббревиатура центрального процессора компьютера (Central Processing Unit).

Блок управления (CU) является составной частью центрального процессора компьютера (CPU) и руководит его работой. Он сообщает памяти компьютера, арифметическому, т.е. логическому, устройству, а также устройствам ввода и вывода, как реагировать на инструкции программ.

Отдельный вопрос: графическое ядро в процессоре что это такое? Если совсем просто – то это встроенная в центральный процессор видеокарта.

Сгенерированная компьютером графика, например, в видеоиграх или других анимациях, требует, чтобы каждый отдельный кадр был «нарисован» компьютером индивидуально. А это требует большого количества энергии и вычислительных мощностей.

Что такое GPU

На вопрос «gpu что это» ответ таков – это графический процессор, т.е. программируемый логический чип, предназначенный для функций отображения на экране. GPU создает изображения, анимацию и видео на мониторе. Графические процессоры (гпу) расположены на сменных платах, в чипсете на материнской плате или в той же микросхеме, что и процессор. Итак, GPU это видеокарта или процессор? Ответ Вы уже знаете – это процессор!

Графический процессор ( GPU ) — это компьютерная микросхема, которая делает быстрые математические вычисления, в основном для представления изображений, но в последнее время активно используемые в майнинге. Блок обработки графики помогает компьютеру работать бесперебойно.

Графические процессоры являются более мощными, чем CPU, потому что графические процессоры отличаются гораздо большим количеством процессорных ядер. Обычный пользователь ПК не использует их для своих стандартных нужд, потому что GPU требуется коллективный тип работы.

Все компьютеры имеют графический процессор .Однако не все компьютеры имеют выделенный графический процессор. Нет необходимости иметь его, если вы не собираетесь использовать свой компьютер для продвинутых игр и майнинга.

Интегрированный графический процессор представляет собой просто графический чипсет, встроенный в материнскую плату. Теперь становится понятно, чем отличается видеокарта от процессора GPU.

Короче говоря, GPU — это процессор, специально разработанный для обработки интенсивных задач визуализации графики, и который используется для майнинга. А видеокарта – это отдельное устройство, имеющее свой собственный GPU.

Отличие CPU и GPU

Основное различие между CPU и GPU состоит в том, что CPU акцентирован на малой задержке. GPU же делает упор на высокую пропускную способность. Проще говоря — графические процессоры предназначены для одновременного выполнения множества задач, а центральные процессоры задействуются для одновременного выполнения одной операции, но очень быстро.

Разница в скорости вычислений

Основная характеристика PU — это тактовая частота, измеряемая в герцах (МГц или ГГц). Чтобы запускать приложения, процессор (в основном, центральный) должен постоянно выполнять вычисления. И чем выше тактовая частота, тем быстрее вычисления. В результате приложения будут работать быстрее и более плавно. На обычном процессоре – максимум 2 ядра, а на GPU: 4-10. Разница в скорости вычислений очевидна.

Майнинг bitcoin

В качестве награды за работу по отслеживанию и защите транзакций майнеры зарабатывают биткойны, практически — за каждый успешно обработанный блок. В Bitcoin основатели установили лимит 21 млн Bitcoins, доступного для добычи, поэтому стоимость криптовалюты постоянно растет, как и число желающих их заполучить.

Потенциальным майнерам нужно сначала узнать про GPU и что это в компьютере, а потом уже разбираться в блокчейнах и криптовалютах. Хорошо понимать, что такое RAM и CPU в компьютере, а потом двигаться дальше.

Печальная правда заключается в том, что в настоящее время только те, у кого есть специализированное, мощное оборудование, могут выгодно добывать биткойны. Хотя их добыча по-прежнему теоретически и технически возможна для всех. Однако, те, у кого недостаточно мощные устройства, рано или поздно обнаружат, что на электроэнергию тратится больше денег, чем на добычу биткоинов.

Принципиально работа майнеров заключается в подборе одной-единственной из многих миллионов комбинаций хэша, подходящего ко всем вновь созданным транзакциям и сгенерированному секретному ключу. Ясно, что только самое производительное оборудование способно обеспечить майнеру конкурентное преимущество и обеспечит получение награды.

Майнинг Ethereum

Добыча криптовалюты является чрезвычайно динамичной отраслью, с ее постоянными обновлениями оборудования и программного обеспечения. Всё труднее рассчитать доходность и принципиальную возможность добычи криптомонет. Ethereum – не исключение, хотя эта криптовалюта появилась после биткоинов. Но работает эта блокчейн-система по тем же принципам, что и биткоин. Однако, биткоин – самодостаточный «первенец», ресурсы которого уже на 2/3 освоены, причем первыми майнерами. А Ethereum – это не только одноименная криптовалюта. В первую очередь – это открытая для всех программная платформа для разработки новых криптовалют. Хотя сама криптомонета Ethereum, как и биткоин, служит хорошим инвестиционным активом, но для добычи уже мало перспективна.

Майнинг других криптовалют

Начинающим крипто-претендентам следует взяться за какую-то из самых простых и новых монет, чтобы реально их добыть. В 2019-м году это:

- Monero,

- Aeon,

- DogeCoin,

- Vertcoin,

- ByteCoin,

- Steem,

- Electroneum…

Monero, признанный самой передовой монетой конфиденциальности, основан на алгоритме хеширования с проверкой работоспособности, известном как CryptoNight. Вы можете легко добывать Monero на обычном компьютере просто путем загрузки и установки программного обеспечения Monero добычи. Поэтому эта новая криптовалюта считается одним из лучших вариантов майнинга с GPU, по сравнению с другими.

Читайте так же «Облачный майнинг»

Виды графических процессоров

Большинство графических процессоров созданы для конкретного использования. Чаще всего – для отображения трехмерной графики в реальном времени, или других массированных вычислений:

Часто спрашивают: GPU — это видеокарта?

Нет, видеокарта — это отдельное оборудование, в то время как GPU — чип, лишь часть видеокарты. Видеокарта — это аппаратная часть, которая выводит картинку на монитор. Чип – это микросхема, обеспечивающая работу видеокарты.

Главное отличие графических процессоров; внутренние они или внешние. Внешние видеокарты выбирают обычно пользователи, у которых физически невозможно установить GPU внутри устройства. Например, это актуально для владельцев ноутбуков, которые ценят продвинутую графику.

Как выбирать

При выборе хорошей видеокарты геймерам и майнерам следует обращать внимание на следующие показатели:

- Тактовая частота (МГц). Чем больше цифра, тем лучше.

- Архитектура имеет большое значение. Чем больше вычислительных блоков, тем быстрее будут выполняться графические задачи.

- Скорость заполнения (филлрейт). Это показатель того, с какой скоростью графический процессор прорисовывает картинку.

Геометрические блоки

В графических процессорах 2 вида геометрических блоков:

- Пиксельные,

- Текстурные.

В современных GPU пиксельных блоков меньше. Они заняты блендингом, т.е. записью рассчитанных видеоадаптером пикселей в оперативку и перемешивании их. Текстурные блоки выбирают и фильтруют текстуры и прочую информацию для построения сцен и общих расчетов.

До появления DirectX 11 мало кто вообще знал, что DirectX – это программная среда (т.е. набор инструментов) для разработки компьютерных игр. В 2015-м появился DirectX 12. Чем выше тесселяция, т.е. дробление плоскости экрана на части для тщательного заполнения их графической информацией, тем выше реализм игры.

Т.е., чтобы с головой погрузиться в атмосферу таких продвинутых игр, как Metro 2033 и т.п., нужно учитывать число геометрических блоков при подборе GPU.

Память

Единственные два типа памяти, которые фактически находятся на чипе GPU, — это регистровая и разделяемая. Локальная, глобальная, постоянная и текстурная память находятся вне чипа. Интегрированный GPU не имеет собственной памяти для выполнения расчетов, а для графики и связанных с ней вычислений, особенно в 3D играх, требуется огромное количество памяти. Такой графический процессор (интегрированный GPU) использует оперативную память в качестве собственной.

Но у оперативки есть несколько ключевых особенностей:

- Объем. Этот показатель несколько переоценен, другие характеристики более важны;

- Ширина шины – параметр важнее, чем объем. Чем шире шина, тем большее количество информации отправит оперативная память чипу за промежуток времени, и наоборот. Для воспроизведения большинства игр требуется минимум: 128 бит;

- Частота, от нее завист пропускная способность оперативной памяти. Однако, 256-битная шина при частоте 800 (3200) МГц оказывается продуктивнее, чем 128-битная при 1000 (4000) МГц.

- Тип. Оптимальные на 2019 год типы — это 3-е и 5-е поколения GDDR.

Охлаждение GPU

Если Вы сами собираете игровой ПК, то рекомендуется использовать отдельные кулеры для процессора и для видеокарты. Если вы хотите всерьез разогнать систему, то Вам следует перейти с воздушного на жидкостное охлаждение. Процессор GPU с жидкостным охлаждением всегда имеет штатный кулер.

Температура графической карты обычно составляет от 30°C до 40°C на холостом ходу и от 60°C до 85°C под обычной нагрузкой. Большинство высокопроизводительных видеокарт настроены на максимальную температуру 95°C-105°C, после чего система автоматически отключается. Вот почему интенсивным процессорам требуется хорошее охлаждение. Для мониторинга температуры центрального процессора и видеокарты есть специальный софт, например, «GPU-Z» и проч.

Итак, теперь Вы в принципе понимаете, что такое CPU и GPU (т.е. что такое графический процессор), оперативка и видеокарты. И как они меняют жизнь геймеров и майнеров.

Что такое gpu в компьютере и его температура

Нередко причиной частых выключений является графический процессор. Что такое GPU в компьютере и его температура разберём как можно подробнее. Вопрос на самом деле не сложный.

Сложности начинаются в тот момент, когда приходится проводить необходимое техническое обслуживание. Особенно, если делать его самостоятельно.

Что такое GPU?

За вывод изображения отвечает монитор компьютера или ноутбука. Но вот сигналы на монитор передаются с помощью видеокарты. Она и является графическим процессором или Graphical Processor Unit (либо же, GPU, если сокращённо).

Назначение графической карты

Обработка требующегося изображения производится именно через видео карту компьютера. Она получает команды от оперативной памяти о том, что и как нужно вывести на монитор. После обработки указанных команд на монитор передаётся сигнал о том, какие элементы и как подсветить.

Проще всего рассмотреть на примере игр, которые дают наибольшую нагрузку на GPU и требует его высокого качества. Итак, сама игра запускается на каком-либо движке, который определяет алгоритмы обработки команд процессором.

Во время обработки поступают сигналы о том, какой видео ряд должен идти на мониторе. Эти сигналы через RAM, или, что чаще, напрямую, подаются на видео карту. Процессор графического элемента обрабатывает их и передаёт изображение монитору. Такой алгоритм характерен не только играм, но и самой ОС.

Примечание: указанный пример предельно упрощён. Фактически же каждая игра даёт настолько огромный поток данных для обработки, что задействуются все элементы компьютера.

Почему так важна температура?

Во время работы процессор греется. Происходит это из-за того, что вычислительные действия производятся с выделением теплового излучения (принцип работы кремниевых микросхем имеет такой недостаток).

Эту температуру принято компенсировать с помощью:

- специальных мембран, которые располагаются над процессором;

- термопасты, которая усиливает проводимость тепла от мембраны до кулера;

- кулера или элемента охлаждения, который снижает температуру мембраны рассеиванием тепла либо активным нагнетанием холодного воздуха с помощью вентилятора.

Звучит сложно. На деле же всё просто: вентилятор дует, чем и охлаждает железку, которая не даёт перегореть самому вычислительному элементу.

Что будет если карта перегреется?

Существует 2 сценария по которым будут развиваться события если карта перегреется. Зависят они как от изготовителя карты, так и от настроек системы/драйвера. Оба этих случая могут иметь печальные последствия, поэтому следить за температурой нужно.

- Срабатывает «защита от перегрева». Если в драйверах установлено предельное значение температуры, то устройство по его достижению работает около минуты, после чего отключается. Это сделано, чтобы избежать повреждений процессора, связанных с перегревом. В такой ситуации компьютер сразу выключается или перезапускается, а ОС сообщает о некорректном завершении работы.

- Расслаивается или сгорает чип. Если высокая нагрузка будет продолжительной, и температура станет критической, а защита не сработает, то видеокарта сгорит. Перегорание характерно любой электронике при нарушении температурного режима. Пожара, конечно, не будет. Но вот дальнейшая эксплуатация GPU станет невозможной. Повреждения будут слишком большими.

Для пользователя предпочтительнее первый сценарий. Лучше лишиться данных за некоторое время, чем лишится дорогой видеокарты. При этом отсутствие нагрузки за время выключения и повторного включения позволяет чипу остыть. Не стоит опасаться обычного использования и даже игр.

Чтобы видеокарта перегрелась нужно чтобы компьютер не чистился порядка 3х лет и при этом постоянно нагружался программами или играми, которые имеют высокие системные требования. Тогда пересохнет и перестанет передавать тепло термопаста, что и повлечёт за собой перегрев.

Как измерить температуру?

Почему важна температура мы рассмотрели. Фактически, это показатель нормальной работы комплектующих. Высокая температура – другой разговор. Она свидетельствует о неспособности системы охлаждения справляться с нагрузкой.

Поэтому нужно будет искать информацию о нормальной рабочей температуре карты. А также следить за текущей температурой компонента.

Программы

Простейшим решением является использование программ. Благо, список таких приложений не маленький. Остановиться следует только на самых распространённых или полезных:

FurMark. Тест стабильности видеокарты. Он позволяет следить за температурой при этом предельно нагружая видеокарту. Работать такое приложение может только в активном режиме и ему требуется время. Зато, нагрузив с его помощью видео карту можно проверить активна ли защита, и способно ли охлаждение справится с нагрузкой.

Если тест прерывается – помните, что Furmark даёт предельно возможную нагрузку. Не факт, что пользователь сможет нагрузить компонент также.

PiriForm Speccy. Программа, работающая от встроенных элементов контроля. На большинстве внутренних элементов компьютера есть свои датчики. Speccy считывает их значения и передаёт пользователю. Состояние, которое показывает программа актуальна в данный момент времени.

GPU Temp. Сокращение от GPU Temperature. Приложение, которое решает только 1 вопрос: контроль температурного режима видео карты (на самом деле ещё и контроль, что за видеокарта установлена в системе).

Обладает функцией графика, который выводит на экран информацию о нагреве в процессе работы. Можно оставить работать в фоновом режиме, а потом проверить температуру под нагрузкой.

GPU-Z. Более продвинутое приложение, которое выводит полную информацию о GPU. Отображает его возможности, температуру и характеристики.

Что такое gpu в компьютере и для чего это нужно?

Автор Дмитрий Костин На чтение 3 мин. Опубликовано

Доброго всем времени суток, мои дорогие друзья и гости моего блога. Сегодня я бы хотел поговорить немного об аппаратной части наших компьютеров. Скажите пожалуйста, вы слышали про такое понятие как GPU? Оказывается просто многие впервые слышат такую аббревиатуру.

Как бы банально это не звучало, но сегодня мы живем в эру компьютерных технологий, и порой сложно найти человека, который понятия не имеет, как работает компьютер. Так, например, кому-то достаточно осознания, что компьютер работает благодаря центральному процессору (CPU).

Кто-то пойдет дальше и узнает, что есть ещё и некий GPU. Такая замысловатая аббревиатура, но похожая на предыдущую. Так давайте же разберемся, что такое GPU в компьютере, какие они бывают и какие различия есть у него с CPU.

Небольшая разница

Простыми словами, GPU — это графический процессор, иногда его именуют видеокартой, что отчасти является ошибкой. Видеокарта — это готовое компонентное устройство, в состав которого как раз и входит нами описываемый процессор. Он способен обрабатывать команды для формирования трёхмерной графики. Стоит отметить, что он является для этого ключевым элементом, от его мощности зависит быстродействие и различные возможности видеосистемы в целом.

Графический процессор имеет свои отличительные особенности по сравнению с его собратом CPU. Основное различие кроется в архитектуре, на которой он построен. Архитектура GPU построена таким образом, что позволяет обрабатывать большие массивы данных более эффективно. CPU, в свою очередь, обрабатывает данные и задачи последовательно. Естественно, не стоит воспринимать эту особенность как минус.

Виды графических процессоров

Существует не так много видов графических процессоров, один из них именуется, как дискретный, и применяется на отдельных модулях. Такой чип достаточно мощный, поэтому для него требуется система охлаждения из радиаторов, кулеров, в особо нагруженных системах может применяться жидкостное охлаждение.

Сегодня мы можем наблюдать значительный шаг в развитие графических компонентов, это обуславливается появлением большого количества видов GPU. Если раньше любой компьютер приходилось снабжать дискретной графикой, чтобы иметь доступ к играм или другим графическим приложениям, то сейчас такую задачу может выполнять IGP — интегрированный графический процессор.

Интегрированной графикой сейчас снабжают практически каждый компьютер (за исключением серверов), будь то, ноутбук или настольный компьютер. Сам видео-процессор встроен в CPU, что позволяет значительно снизить энергопотребление и саму цену устройства. Кроме того, такая графика может быть и в других подвидах, например: дискретная или гибридно-дискретная.

Первый вариант подразумевает наиболее дорогое решение, распайку на материнской плате или же отдельный мобильный модуль. Второй вариант называется гибридным неспроста, фактически он использует видеопамять небольшого размера, которая распаяна на плате, но при этом способен расширять её за счёт оперативной памяти.

Естественно, такие графические решения не могут поравняться с полноценными дискретными видеокартами, но уже сейчас показывает достаточно хорошие показатели. В любом случае, разработчикам есть куда стремиться, возможно за таким решением будущее.

Ну а на этом у меня, пожалуй, все. Надеюсь, что статья вам понравилась! Жду вас снова у себя на блоге в гостях. Удачи вам. Пока-пока!

GPU в компьютере что это?

Главный чип на материнской плате – это центральный процессор (CPU – Central Processor Unit). Центральный, потому что управляет всеми остальными подсистемами, с помощью системы шин и чипсета.

Подсистема, которая управляет визуализацией и выводом информации на экран называется видеосистемой. Она интегрируется в материнскую плату через слот в виде видеокарты. Видеокарта – инженерное решение и представляет собой плату с собственным процессором (тем самым GPU) и оперативной памятью.

GPU NVidia Nv45 на видеокарте

Процессор на видеокарте называют GPU (Graphic Processor Unit), чтобы подчеркнуть:

- Что это процессор.

- Что он не центральный, то есть подчиненный для CPU.

- Что он ориентирован на обработку специальных данных – графики.

Расположение GPU на материнской плате

Поскольку обработка графики – это специализация в обработке данных, GPU – это специализированный CPU. Логически специализация выражается отделением GPU от CPU, физически – тем, что GPU устроен иначе.

CPU содержит десятки ядер, GPU – тысячи

Такая физическая реализация GPU обоснована необходимостью обрабатывать тысячи параллельных задач, связанных с отрисовкой. Центральный процессор ориентирован на обработку данных – долгие и последовательные задачи.

Современный ЦП (CPU) может включать в себя графический процессор.

Четрыехядерный процессор с дополнительным графическим ядром GPU

Такое решение позволяет компьютеру обойтись без видеокарты за счет встроенного в центральный процессор GPU. Это снижает потребляемую энергию от 30 до 180%. Стоимость процессора при этом возрастает не более чем на 20%.

Главный минус такой реализации – низкая производительность. Такое решение подходит для офисных компьютеров, где работают с документами и базами данных, но современную компьютерную игру на нем не запустишь, Фотошоп будет притормаживать, а Автокад может зависнуть намертво.

Как узнать GPU в компьютере

Для пользователя GPU прочно ассоциируется с видеокартой, хотя это только процессор. Знать, какой графический адаптер установлен в компьютере полезно в трех случаях:

- при установке или обновлении драйверов;

- при оценке компьютера на соответствие системным требованиям программного обеспечения;

- чтобы хвастаться перед друзьями.

Ели на компьютере установлены все драйвера, то самый быстры способ – посмотреть в диспетчере устройств, в разделе видеоадаптеры:

Просмотр GPU в диспетчере устройств

Если драйвера не установлены диспетчер устройств покажет только надпись о неизвестных устройствах:

GPU в диспетчере устройств в случае отсутствия драйверов

В этом случае скачайте утилиту CPU-Z, запустите и перейдите на вкладку «Графика» (Graphics в англ. версии):

Просмотр GPU в программе CPU-Z

В чем разница между ЦП и ГП?

Примечание редактора: обновили наш исходный пост о различиях между графическими и центральными процессорами , автор Кевин Кревелл , опубликованный в декабре 2009 года.

ЦП (центральный процессор) называют мозгом ПК. В ГПУ его душа. Однако за последнее десятилетие графические процессоры вырвались из рамок ПК.

Графические процессорывызвали мировой бум искусственного интеллекта.Они стали ключевой частью современных суперкомпьютеров. Они были встроены в новые гипермасштабируемые центры обработки данных. По-прежнему ценимые геймерами, они стали ускорителями, ускоряющими выполнение всех видов задач — от шифрования до работы в сети и искусственного интеллекта.

И они продолжают продвигать достижения в области игровой и профессиональной графики для рабочих станций, настольных ПК и ноутбуков нового поколения.

Что такое графический процессор?

В чем разница между ЦП и ГП?

В чем разница между ЦП и ГП?В то время как графические процессоры (графические процессоры) — это гораздо больше, чем ПК, в которых они впервые появились, они по-прежнему связаны с гораздо более старой идеей, называемой параллельными вычислениями.Вот что делает графические процессоры такими мощными.

Разумеется,процессоров остаются незаменимыми. Быстрые и универсальные, центральные процессоры выполняют ряд задач, требующих большого количества интерактивности. Например, вызов информации с жесткого диска в ответ на нажатия клавиш пользователем.

Напротив, графические процессоры разбивают сложные проблемы на тысячи или миллионы отдельных задач и решают их сразу.

Это делает их идеальными для графики, где текстуры, освещение и рендеринг форм должны выполняться одновременно, чтобы изображения не пропадали по экрану.

CPU против GPU

| CPU | GPU |

|---|---|

| Центральный процессор | Графический процессор |

| Несколько ядер | Много ядер |

| Низкая задержка | Высокая пропускная способность |

| Хорошо для последовательной обработки | Хорошо для параллельной обработки |

| Может выполнять несколько операций одновременно | Может выполнять тысячи операций одновременно |

Архитектурно ЦП состоит всего из нескольких ядер с большим количеством кэш-памяти, которые могут обрабатывать несколько программных потоков одновременно.Напротив, графический процессор состоит из сотен ядер, которые могут обрабатывать тысячи потоков одновременно.

Графические процессорывоплощают некогда эзотерическую технологию параллельных вычислений. Это технология с выдающейся историей, в которую входят такие имена, как гений суперкомпьютеров Сеймор Крей. Но вместо того, чтобы принимать форму огромных суперкомпьютеров, графические процессоры воплотили эту идею в жизнь на настольных компьютерах и игровых консолях более чем миллиарда игроков.

Для графических процессоров, компьютерная графика — первое из многих приложений

Это приложение — компьютерная графика — было лишь первым из нескольких приложений-убийц.И это продвинуло вперед огромную движущую силу НИОКР, стоящую за графическими процессорами. Все это позволяет графическим процессорам опережать более специализированные чипы с фиксированной функцией, обслуживающие нишевые рынки.

Еще один фактор, делающий всю эту мощь доступной: CUDA. Платформа параллельных вычислений, впервые выпущенная в 2007 году, позволяет кодерам использовать вычислительную мощность графических процессоров для обработки общего назначения, вставляя в свой код несколько простых команд.

Это дает возможность графическим процессорам распространяться в удивительных новых областях. А благодаря поддержке быстрорастущего числа стандартов, таких как Kubernetes и Dockers, приложения можно тестировать на недорогих графических процессорах для настольных ПК и масштабировать до более быстрых и сложных серверных графических процессоров, а также на всех крупных поставщиках облачных услуг.

ЦПи конец закона Мура

С отменой закона Мура графические процессоры, изобретенные NVIDIA в 1999 году, появились как раз вовремя.

Закон Мура утверждает, что количество транзисторов, которые можно втиснуть в интегральную схему, будет удваиваться примерно каждые два года. На протяжении десятилетий это приводило к быстрому росту вычислительной мощности. Этот закон, однако, натолкнулся на жесткие физические ограничения.

Графические процессорыпредлагают способ продолжить ускорение приложений, таких как графика, суперкомпьютеры и искусственный интеллект, путем разделения задач между несколькими процессорами.По мнению Джона Хеннесси и Дэвида Паттерсона, победителей конкурса AM 2017 г., такие ускорители имеют решающее значение для будущего полупроводников. Премия Тьюринга и авторы Компьютерная архитектура: количественный подход — основополагающего учебника по микропроцессорам.

Графические процессоры: ключ к искусственному интеллекту, компьютерному зрению, суперкомпьютерам и многому другому

За последнее десятилетие это стало ключом к расширению спектра приложений.

Графические процессорывыполняют гораздо больше работы на каждую единицу энергии, чем процессоры.Это делает их ключом к суперкомпьютерам, которые в противном случае вышли бы за рамки сегодняшних электрических сетей.

В ИИ графические процессоры стали ключом к технологии, называемой «глубокое обучение». Глубокое обучение передает огромные объемы данных через нейронные сети, обучая их выполнять задачи, слишком сложные для описания любого человека-программиста.

AI и игры: глубокое обучение на базе графического процессора — полный цикл

Эта возможность глубокого обучения ускоряется благодаря включению в графические процессоры NVIDIA выделенных тензорных ядер.Тензорные ядра ускоряют операции с большими матрицами, что составляет основу ИИ, и выполняют вычисления умножения и накопления матриц смешанной точности за одну операцию. Это не только ускоряет традиционные задачи искусственного интеллекта всех видов, но и используется для ускорения игр.

Графические процессоры совершают полный цикл: тензорные ядра, встроенные в графические процессоры NVIDIA Turing, ускоряют ИИ, которые, в свою очередь, теперь используются для ускорения игр.

Графические процессоры совершают полный цикл: тензорные ядра, встроенные в графические процессоры NVIDIA Turing, ускоряют ИИ, которые, в свою очередь, теперь используются для ускорения игр.В автомобильной промышленности графические процессоры предлагают множество преимуществ. Они предоставляют непревзойденные возможности распознавания изображений, как и следовало ожидать.Но они также являются ключом к созданию беспилотных транспортных средств, способных учиться и адаптироваться к огромному количеству различных реальных сценариев.

В робототехнике графические процессоры являются ключом к тому, чтобы машины воспринимали окружающую среду, как и следовало ожидать. Однако их возможности искусственного интеллекта стали ключом к машинам, которые могут изучать сложные задачи, такие как автономная навигация.

В области здравоохранения и биологических наук графические процессоры предлагают множество преимуществ. Конечно, они идеально подходят для задач визуализации. Но глубокое обучение на основе графического процессора ускоряет анализ этих изображений.Они могут обрабатывать медицинские данные и превращать их с помощью глубокого обучения в новые возможности.

Короче говоря, графические процессоры стали незаменимыми. Они начали с ускорения игр и графики. Теперь они ускоряют все больше и больше областей, в которых вычисление лошадиных сил будет иметь значение.

Похожие сообщения

.Что такое графический процессор? Основное определение видеокарт

Nvidia GeForce GTX 1080 Pascal GPUGPU означает графический процессор. Вы также увидите графические процессоры, которые обычно называют видеокартами или видеокартами. Каждый ПК использует графический процессор для рендеринга изображений, видео и 2D- или 3D-анимации для отображения. Графический процессор выполняет быстрые математические вычисления и освобождает ЦП для других дел. В то время как ЦП использует несколько ядер , ориентированных на последовательную последовательную обработку, графический процессор имеет тысячи ядер меньшего размера, предназначенных для многозадачности.

Существует два разных типа графических процессоров:

- Интегрированные Графические процессоры расположены на центральном процессоре ПК и совместно используют память с процессором центрального процессора.

- Дискретные графические процессоры работают на собственной карте и имеют собственную видеопамять (VRAM), поэтому ПК не должен использовать свою RAM для графики.

Итог: для достижения наилучшей производительности выберите дискретный графический процессор.

Многие видеокарты сегодня работают на GDDR SDRAM, что означает синхронную динамическую оперативную память с удвоенной скоростью передачи данных.Другие варианты, от худшей к лучшей производительности: GDDR2, GDDR3, GDDR4, GDDR5, GDDR5X и GDDR6.

Эта статья является частью Tom’s Hardware Glossary .

Дополнительная литература:

.CPU против GPU: в чем разница?

Будь то приложения для глубокого обучения, массовый параллелизм, интенсивные 3D-игры или другая требовательная рабочая нагрузка, сегодня от систем требуется больше, чем когда-либо прежде. Центральный процессор (ЦП) и графический процессор (ГП) играют очень разные роли. Для чего используются процессоры? Для чего используются графические процессоры? Знание роли каждого из них важно при покупке нового компьютера и сравнении характеристик.

Что такое ЦП?

ЦП, состоящий из миллионов транзисторов, может иметь несколько процессорных ядер и обычно называется мозгом компьютера. Он необходим для всех современных вычислительных систем, поскольку выполняет команды и процессы, необходимые для вашего компьютера и операционной системы. ЦП также важен для определения скорости работы программ, от просмотра веб-страниц до создания электронных таблиц.

Что такое графический процессор?

Графический процессор — это процессор, состоящий из множества более мелких и более специализированных ядер.Работая вместе, ядра обеспечивают огромную производительность, когда задача обработки может быть разделена и обработана между несколькими ядрами.

В чем разница между процессором и графическим процессором?

CPU и GPU имеют много общего. Оба являются критически важными вычислительными механизмами. Оба являются микропроцессорами на основе кремния. И оба обрабатывают данные. Но процессоры и графические процессоры имеют разную архитектуру и созданы для разных целей.

ЦП подходит для широкого спектра рабочих нагрузок, особенно тех, для которых важны задержки или производительность на уровне ядра.Мощный механизм выполнения, ЦП фокусирует свое меньшее количество ядер на отдельных задачах и на быстром выполнении задач. Это делает его уникальным оборудованием для различных задач, от последовательных вычислений до работы с базами данных.

Графические процессорыначинались как специализированные ASIC, разработанные для ускорения определенных задач 3D-рендеринга. Со временем эти механизмы с фиксированной функцией стали более программируемыми и гибкими. В то время как графика и все более реалистичное изображение в современных популярных играх остаются их основной функцией, графические процессоры эволюционировали и стали более универсальными параллельными процессорами, обслуживающими постоянно растущий спектр приложений.

Что такое интегрированная графика?

Интегрированная или совместно используемая графика встроена в тот же чип, что и ЦП. Некоторые процессоры могут поставляться со встроенным графическим процессором, а не полагаться на выделенную или дискретную графику. Также иногда называемые IGP или интегрированными графическими процессорами, они разделяют память с ЦП.

Интегрированные графические процессоры предлагают несколько преимуществ. Их интеграция с центральными процессорами позволяет им обеспечивать преимущества в пространстве, стоимости и энергоэффективности по сравнению с выделенными графическими процессорами.Они предоставляют возможности для обработки данных, связанных с графикой, и инструкций для общих задач, таких как исследование Интернета, потоковая передача фильмов 4K и обычные игры.

Такой подход чаще всего используется с устройствами, для которых важны компактный размер и энергоэффективность, например ноутбуки, планшеты, смартфоны и некоторые настольные компьютеры.

Accelerating Deep Learning and AI

Сегодня графические процессоры выполняют все больше рабочих нагрузок, таких как глубокое обучение и искусственный интеллект (AI).Для обучения глубокому обучению с несколькими слоями нейронной сети или на массивных наборах определенных данных, таких как 2D-изображения, идеально подходят графические процессоры или другие ускорители.

Алгоритмы глубокого обучения были адаптированы для использования подхода с ускорением на графическом процессоре, что позволило значительно повысить производительность и впервые довести обучение нескольким реальным задачам до возможного и жизнеспособного диапазона.

Со временем процессоры и программные библиотеки, которые на них работают, эволюционировали и стали более способными выполнять задачи глубокого обучения.Например, благодаря обширной оптимизации программного обеспечения и добавлению специального оборудования искусственного интеллекта, такого как Intel® Deep Learning Boost (Intel® DL Boost) в новейшие процессоры Intel® Xeon® Scalable, системы на базе ЦП улучшили производительность глубокого обучения.

Для многих приложений, таких как глубокое изучение языка, текста и данных временных рядов с высоким разрешением, 3D и без изображений, центральные процессоры превосходны. ЦП могут поддерживать гораздо больший объем памяти, чем даже лучшие графические процессоры сегодня, для сложных моделей или приложений глубокого обучения (например.g., обнаружение 2D-изображения).

Комбинация ЦП и ГП, а также достаточный объем оперативной памяти обеспечивают отличную тестовую площадку для глубокого обучения и искусственного интеллекта.

Десятилетия лидерства в разработке процессоров

Intel имеет долгую историю инноваций в области процессоров, начиная с 1971 года, когда представила 4004, первый коммерческий микропроцессор, полностью интегрированный в один чип.

Сегодня процессоры Intel® позволяют создавать искусственный интеллект, который вы хотите и где хотите, на базе известной вам архитектуры x86.От высокопроизводительных процессоров Intel® Xeon® Scalable в центрах обработки данных и облаке до энергоэффективных процессоров Intel® Core ™ на периферии — Intel поставляет ЦП для любых нужд.

Интеллектуальная производительность процессоров Intel® Core ™ 10-го поколения

Наши процессоры Intel® Core ™ 10-го поколения используют полностью новую архитектуру ядра ЦП, полностью новую графическую архитектуру и встроенные инструкции AI для интеллектуального обеспечения оптимальной производительности и удобства.

оснащены новейшим графическим процессором Intel® Iris® Plus, который представляет собой огромный скачок вперед в тонких и легких ноутбуках, обеспечивая более плавное, детальное и яркое взаимодействие, чем когда-либо поставляла Intel перед.

Intel® Iris® Plus графика обеспечивает встроенную графику процессора для встроенного ускорения вывода глубокого обучения, предлагая примерно вдвое улучшенную графическую производительность. 2 Графический адаптер Intel® Iris® Plus также обеспечивает исключительную энергоэффективность.

Скоро появится графический процессор Intel®

В настоящее время Intel стремится использовать возможности ЦП и встроенного графического процессора для разработки специализированных графических процессоров. Intel планирует представить свой первый дискретный графический процессор Intel®, который предоставит полный портфель вариантов ЦП и ГП и снабдит вас необходимыми инструментами для удовлетворения растущих вычислительных потребностей.

Сегодня вопрос сравнения ЦП и ГП уже не стоит. Более чем когда-либо вам нужны и то, и другое для удовлетворения разнообразных вычислительных потребностей. Наилучшие результаты достигаются, когда для работы используется правильный инструмент.

В ближайшие месяцы ждите анонсов новых графических процессоров Intel®.

.Что такое графический процессор и нужен ли он для глубокого обучения? | Джейсон Дсуза

Любой специалист по анализу данных или энтузиаст машинного обучения хотя бы раз в жизни слышал, что для глубокого обучения требуется много оборудования. Некоторые тренируют простые модели глубокого обучения в течение нескольких дней на своих ноутбуках (обычно без графических процессоров), что создает впечатление, что для выполнения глубокого обучения требуются большие системы.

Это породило миф о глубоком обучении, который создает препятствия для новичков.

В каждой книге, на которую я ссылался в последние несколько лет, автор всегда упоминает следующее:

Для работы с глубоким обучением требуются большие вычислительные мощности.

Но у меня нет центров обработки данных, и когда я построил свою первую модель глубокого обучения на большом ноутбуке, я знал, что консенсус был либо неверным, либо изображался с примерно на истины.

Чтобы стать экспертом в области глубокого обучения, необязательно брать на себя управление Google.

Для любой нейронной сети этап обучения модели глубокого обучения является наиболее ресурсоемкой задачей

Во время обучения нейронная сеть принимает входные данные, которые затем обрабатываются в скрытых слоях с использованием весов , которые настраивается во время обучения, и затем модель выдаёт прогноз. Веса корректируются, чтобы найти закономерности, чтобы делать более точные прогнозы.

Обе эти операции по существу представляют собой умножения матриц .Простое матричное умножение может быть представлено изображением ниже

Источник: jeremyjordan.meВ нейронной сети мы можем увидеть, что первый массив — это вход в нейронную сеть, а второй массив формирует его вес .

Легко, правда?

Да, если ваша нейронная сеть имеет около 10, 100 или даже 100 000 параметров. Компьютер по-прежнему сможет справиться с этим за считанные минуты или даже часы, самое большее.

А что, если ваша нейронная сеть имеет более 10 миллиардов параметров? Для обучения такого рода систем с использованием традиционного подхода потребуется года .Ваш компьютер, вероятно, выйдет из строя, прежде чем вы пройдете хотя бы одну десятую пути.

«Нейронная сеть, которая принимает входные данные для поиска и делает прогнозы на основе 100 миллионов выходных данных или продуктов, обычно в конечном итоге имеет около 2000 параметров для каждого продукта. Итак, вы умножаете их, и последний слой нейронной сети составляет 200 миллиардов параметров. И ничего изощренного я не сделал. Я говорю об очень-очень простой модели нейронной сети ». — к.э.н. студент Университета Райса

Модели глубокого обучения можно обучать быстрее, просто выполняя все операции в одно и то же время , а не одну за другой.

Вы можете добиться этого, используя GPU для обучения вашей модели.

Графический процессор (GPU) — это специализированный процессор с выделенной памятью, который обычно выполняет операции с плавающей запятой, необходимые для рендеринга графики.

Другими словами, это однокристальный процессор, используемый для обширных графических и математических вычислений, который освобождает увеличить количество циклов ЦП для других заданий.

Основное различие между графическими процессорами и процессорами состоит в том, что графические процессоры выделяют пропорционально больше транзисторов для арифметико-логических устройств и меньше — на кэширование и управление потоком по сравнению с процессорами.

В то время как ЦП в основном применимы для задач, требующих синтаксического анализа с по или интерпретации сложной логики в коде, графические процессоры предназначены для специальных рабочих лошадок графического рендеринга компьютерных игр, которые позже были усовершенствованы для ускорения других геометрических вычислений (для например, преобразование полигонов или вращение вертикалей в различные системы координат, такие как 3D).

Графический процессор меньше, чем ЦП, но обычно имеет больше логических ядер (арифметико-логические блоки или ALU, блоки управления и кэш памяти), чем последний.

Источник: fast.aiНа диаграмме выше вы можете видеть, что графические процессоры (красный / зеленый) теоретически могут выполнять в 10–15 раз больше операций ЦП (показано синим цветом). Это ускорение очень применимо и на практике.

Если рассматривать ЦП как Maserati, графический процессор можно рассматривать как большой грузовик.

ЦП (Maserati) может быстро загружать небольшие количества пакетов (3-4 пассажира) в ОЗУ, тогда как графический процессор (грузовик) работает медленнее, но может извлекать большие объемы памяти (~ 20 пассажиров) за один ход.

В этом видео представлена дальнейшая концепция:

GPU оптимизированы для обучения моделей искусственного интеллекта и глубокого обучения, поскольку они могут обрабатывать несколько вычислений одновременно.

Они имеют большое количество ядер, что позволяет лучше вычислять несколько параллельных процессов. Кроме того, вычисления в глубоком обучении должны обрабатывать огромные объемы данных — это делает пропускную способность памяти графического процессора наиболее подходящей.

Есть несколько решающих параметров , чтобы определить, использовать ли ЦП или графический процессор для обучения модели глубокого обучения:

Пропускная способность памяти:

Пропускная способность — одна из основных причин, почему графические процессоры быстрее обрабатывают вычисления, чем процессоры.С большими наборами данных ЦП занимает много памяти при обучении модели.

Вычисления огромных и сложных заданий занимают много тактовых циклов ЦП — ЦП выполняют задания последовательно и имеют меньшее количество ядер, чем его аналог, графический процессор.

С другой стороны, автономный графический процессор поставляется с выделенной памятью VRAM (видеопамять). Таким образом, память процессора может использоваться для других задач.

Сравнение пропускной способности процессоров и графических процессоров с течением времениРазмер набора данных

Для обучения модели глубокому обучению требуется большой набор данных, а значит, большие вычислительные операции с точки зрения памяти.Для эффективного вычисления данных оптимальный выбор — графический процессор. Чем больше объем вычислений, тем больше преимущество графического процессора над центральным процессором.

Оптимизация

Задачи оптимизации намного проще в CPU. Ядра ЦП хоть и меньше, но мощнее тысяч ядер графического процессора.

Каждое ядро ЦП может выполнять разные инструкции (архитектура MIMD), тогда как ядра графического процессора, которые обычно организованы в блоки по 32 ядра, выполняют одну и ту же инструкцию в заданное время параллельно (архитектура SIMD).

Распараллеливание в плотных нейронных сетях очень сложно, учитывая требуемые усилия. Следовательно, сложные методы оптимизации труднее реализовать в GPU, чем в CPU.

.